在当今数字时代,人工智能辅助写作与编程的需求持续增长。很多从业者和爱好者开始使用类似于ChatGPT和Claude这样的大型语言模型来完成复杂的任务。尤其是在软件开发、文本生成以及创意思维过程中,AI助手的表现直接影响工作效率和满意度。近年来,Claude因其简洁高效的回答和对上下文的优秀理解能力而备受推崇,用户反映它能够在收到简短提示时迅速给出准确且有深度的答案。然而,许多人尝试使用ChatGPT时却感受到显著的差异,尤其是在处理大型代码库和复杂指令时,ChatGPT有时表现不佳,甚至无法准确检索和理解附带的文件内容。为何这两者会有如此不同的体验?又如何利用现有资源和技巧,优化ChatGPT的表现,使其与Claude看齐甚至超越?探索和解决这些问题,有助于提升人工智能助手的实用价值。

首先,了解两款AI的核心机制与设计理念至关重要。Claude是由Anthropic开发,强调安全性与对话守则的执行,同时在理解长文本内容和多轮对话中表现出色。它倾向于以更“人性化”的方式回应,尤其擅长在有限提示下捕捉关键细节。ChatGPT由OpenAI打造,基于GPT系列模型,结构更加通用且适配广泛应用。由于训练数据和调整目标不同,ChatGPT在特定任务上可能需要更详细的上下文和指令,以获得理想的输出质量。另一方面,ChatGPT强大的可定制性和丰富的模型生态使得熟练用户能通过提示工程显著提升表现。

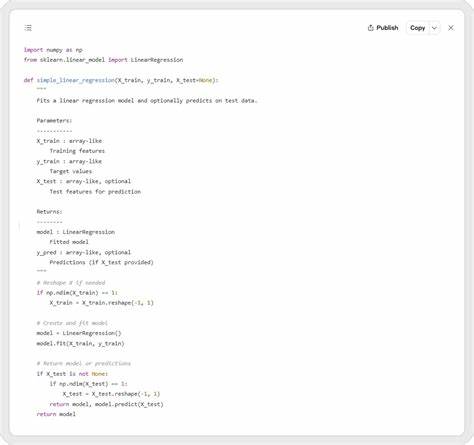

针对日常使用中遇到的挑战,有几个行之有效的方法可以提升ChatGPT的表现。最核心的策略是在提示设计上精耕细作。相比于一次性提供过长的代码库或模糊的请求,用户应将任务拆解成更小的部分,逐步引导模型理解和处理。通过细化指令、明确所需结果,有助于模型避免遗漏信息或产生无关回答。例如,将大型代码拆分成模块,利用多轮对话逐块分析和生成,可以弥补ChatGPT在处理海量信息时可能的记忆限制。此外,向模型主动表达预期的格式和细节要求,清晰说明需要展示完整代码还是仅修改部分,以免出现只给出差异或片段的情况。

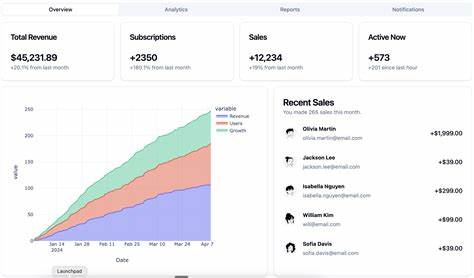

另一关键技巧是合理使用对话上下文。ChatGPT对对话历史的掌握依赖于令牌限制。合理调整之前提问和回答的内容,把重点内容保持在对话窗口的前端,提升模型的记忆效率,可以避免重复询问或内容遗失。同时,针对代码数据,使用清晰的注释和结构化提示,帮助模型精准定位,提高召回和生成的准确率。一些用户还发现结合外部工具,如代码索引和搜索插件,辅以ChatGPT的自然语言交互,能够更好地弥补对大型附件直接支持的不足。 从订阅方案和模型选择角度来看,不同版本的ChatGPT在处理能力和上下文长度上存在差异。

选择支持更大上下文窗口(如GPT-4-32k版本)的模型,能有效扩大单次交互能处理的信息量,提升复杂任务的表现。同时,订阅企业版或定制方案也可能带来更多后台优化和专属功能。相比之下,Claude对长文本的处理更为本地化和流畅,但通过合理的提示和对话设计,ChatGPT同样可以达到接近的效果。 此外,社区经验分享和学习提示工程不可忽视。大量优质示范和模板提示流传于网络和论坛,通过模仿和调整,有助于新用户快速掌握高效对话方式。建议用户积极参与技术社区,关注动态更新和优化技巧,持续完善自己的交互风格。

无论是简化问题描述,还是采用分阶段反馈,良好的沟通习惯是释放ChatGPT潜力的关键。 综上所述,虽然Claude在部分应用场景中表现更为优秀,但借助科学的提示设计、有效的对话管理和合理的版本选择,ChatGPT完全可以迎头赶上。对于追求高效、精准输出的用户,掌握核心技巧尤为重要。未来,随着模型的不断迭代和辅助工具的丰富,ChatGPT的表现势必持续提升,提供更加智能便捷的交互体验。不断探索使用策略,将帮助用户更好地驾驭AI技术,提升工作和创作效率,成就更多可能。