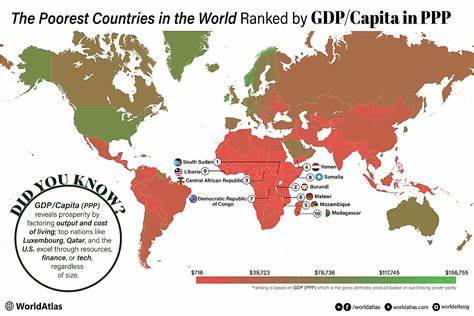

近年来,人工智能(AI)技术以惊人的速度发展,尤其是AI聊天机器人因其便捷的信息整合和回答能力,迅速成为科研人员获取知识和撰写论文的重要助手。然而,随着这些工具的普及,学术界也逐渐意识到一个不可忽视的问题 - - AI聊天机器人在助力科研的同时,也在无形中影响并偏颇了学术研究的引用和文献选择。 AI系统在收集和整理海量数据时,往往依赖网络上的公开信息和已有的研究成果,但其算法和数据来源可能存在偏差,导致推荐的文献和信息并非完全客观或均衡。例如,一些AI工具倾向于推崇高引用率、热门机构或特定地区的研究,忽视了同样有价值但较少被引用或来自非主流来源的工作。这样不仅加剧了学术资源的不平等分配,也可能影响新兴思想和跨领域创新的发展空间。 以2025年初的实际数据为例,美国知名AI企业OpenAI在引导用户访问学术出版社网页时采集的材料远超实际点击量,从每次访问250页飙升至1500页;另一家初创公司Anthropic的采集比例更是从6,000页飞跃至60,000页。

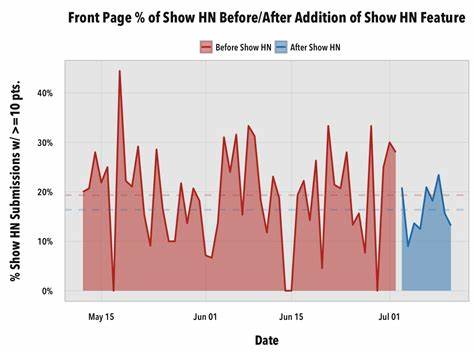

这一现象不仅反映了AI对信息海量处理的能力,也暴露出其在传播和推荐机制上的潜在问题。用户通过AI聊天机器人获取信息,大多数时候并未直接访问原始出处,削弱了学术出版社的流量及其内容的传播价值。 此外,搜索引擎巨头谷歌在推出其AI概览功能后,将推荐文章的比例从过去的每次6篇翻升至18篇,强调了"答案引擎"正逐渐主导信息生态系统的局面。用户越来越依赖AI机器人对问题的直接解答,而非传统的主动搜索和筛选,这种趋势加剧了信息单一化,进一步放大了算法偏好和数据源偏见带来的影响。 这不仅仅是信息传播方式的变化,更深刻地涉及到学术研究的基础 - - 文献综述和引用体系。科研诚信和成果的真实性依赖于全面、公正地掌握已有研究进展。

AI工具若未能保证推荐内容的多样性与准确性,学者面临的风险是"被引文献的失真",进而影响论文质量甚至研究方向。 面对这一挑战,学术界呼吁立即制定并实施针对AI聊天机器人的使用指导原则,明确其在科研中的角色界限和责任。首先,要提高对AI生成内容潜在偏见的认识,确保研究人员能够识别并谨慎对待基于AI推荐的资料。其次,推动AI开发企业与学术机构合作,开放更多高质量、权威的学术数据库接口,使机器人能够从更广泛且合理筛选的信息来源中学习和推荐。 同时,倡导增加AI系统的透明度,向用户披露其内容来源和筛选标准,避免"黑箱"操作导致的信息偏差难以追溯和纠正。科研机构和出版社也应在数字环境中探索创新机制,比如引入验证工具对AI生成内容进行人工或自动核查,保障学术成果的原创性和引用的准确性。

此外,教育培训同样关键,应提升研究人员尤其是年轻学者的信息素养,教会他们如何合理运用AI工具,结合传统文献检索和自己的判断力,有效辨别信息价值而非盲目依赖机器答案。 总结来看,人工智能聊天机器人的兴起对学术研究带来了便利,也带来了挑战。其在内容推荐和引用偏见方面的问题不容忽视,需从技术机制、制度规范和用户教育等多方面综合施策。只有建立明确的使用指南和监督体系,科学研究才能在新时代信息环境中保持公正、中立和创新的生命力。人类学者与AI工具应形成互补,携手推动学术进步而非阻碍。展望未来,AI在科研中的合理应用将是技术发展与学术伦理融合的关键所在,值得全球科学界共同关注和努力。

。