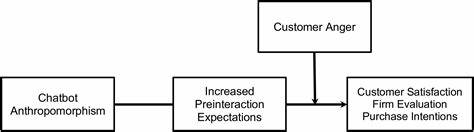

在人工智能技术不断进步的当下,聊天机器人已经不再是单纯的娱乐工具,其在金融、医疗、法律等领域的应用日益广泛。尤其是在信息传播和金融投资领域,聊天机器人的影响力日益显著。然而,当这些智能系统输出错误甚至误导性信息时,责任应该如何界定?用户因依赖聊天机器人而遭受损失,是否能够追责这些背后的技术提供商?这些问题引发了广泛的讨论和争议。 最近,彭博社专栏作家马特•莱文(Matt Levine)在一篇报道中指出,随着大型语言模型的普及,类似证券欺诈的风险正在显现。假设用户向聊天机器人询问某家公司是否值得投资,机器人生成了错误的“肯定”或“否定”答案,导致用户据此买卖股票,从而遭受经济损失。此时,是否可以将聊天机器人制造商视为涉嫌证券欺诈的责任方? 现实中,该类法律纠纷存在诸多复杂问题。

首先,证券欺诈的判定通常要求存在“在购买或销售证券过程中”的欺诈行为,且制作者本人需要从中获利。聊天机器人生成的内容往往附带免责声明,表明其信息可能不准确,用户是否合理依赖这些信息?这些因素都使得追责变得困难。另一方面,聊天机器人“幻觉”现象(即生成不真实但看似合理的信息)不仅给个人投资者带来风险,也对整个金融市场的信息透明度造成威胁。错误信息的传播可能引起股价的异常波动,进而影响市场稳定性。 除了金融领域,更多行业也在面临类似挑战。客服聊天机器人一旦提供误导性建议,可能导致消费者权益受损。

医疗健康领域中,如果智能助理错误诊断或遗漏关键信息,后果甚至更加严重。对于所有这类情况,责任归属成为法律、伦理和技术层面亟需解决的难题。 在法律层面,当前多数司法体系尚未完全适应人工智能技术带来的新风险。传统的责任认定规则往往强调人的意图和过失,但聊天机器人没有“意识”,生成内容主要依赖于训练数据及算法设计。针对这种“非人行为”,如何制定合理的法律框架,保障用户权益而不阻碍技术创新,是监管机构面临的重大课题。 一些国家和地区正在积极探索对人工智能相关责任的立法尝试。

例如,欧盟在《人工智能法案》中提出了风险等级分类,针对高风险AI系统设定严格的合规要求,并明确生产者责任。类似措施试图通过事前规范和事后追责相结合的方式,提高技术安全性和可信度。 技术层面,聊天机器人开发者也在不断改进模型的准确率和透明度。引入多轮对话验证、多源信息交叉核查等机制,有助于降低错误产生概率。同时,增强用户教育,提升公众对AI工具局限性的认知,也至关重要。 很多人认为,责怪聊天机器人本身并无意义,因为它们只是工具,错误的根源应归咎于人类设计和监管不力。

然而,随着AI系统自主性的增强,传统的工具观念正在被挑战。如何界定人工智能系统的“代理地位”,是未来伦理讨论的热点。 此外,商业模式对责任归属也有影响。当前许多聊天机器人依赖广告收益或订阅服务,若其内容误导广告商或用户,则涉及利益相关方间的复杂法律关系。透明、公开和可追溯的内容生成过程可能成为缓解纠纷的重要手段。 总体来看,聊天机器人带来了便利和效率提升,但伴随其产生的信息风险不可忽视。

法律法规需要与时俱进,形成覆盖设计、使用到售后的全链条责任分配体系。行业内部应加强自律,技术层面不断提升安全性。公众应保持理性和警惕,既享受科技成果,也要避免盲目信任。 未来,随着人工智能技术愈加成熟和普及,对聊天机器人责任的界定将更加明晰。跨学科合作,涵盖法律、技术、伦理及社会学等领域,将是应对挑战的关键。只有这样,才能促进人工智能的健康发展,造福全社会,而非成为法律和道德的盲点。

聊天机器人并非“罪魁祸首”,背负的是如何在赋能社会的同时承担相应责任的时代使命。我们无法责怪机器,但必须认真思考其背后的设计和治理,确保智能化浪潮中每个人的权益都能得到保障。