自2025年7月25日英国《在线安全法》正式生效以来,关于网络内容监管的讨论进入了一个全新的阶段。该法案旨在保护未成年人免受有害内容影响,如色情、犯罪剥削以及鼓励自杀的材料。然而,随着年龄验证机制的实施,社会各界开始关注该法案对言论自由,尤其是新闻报道和抗议视频传播的潜在影响。拒绝或限制合法抗议视频的现象引发了公众对网络表达权利与安全保障之间平衡的激烈探讨。 该法律核心要求各大社交平台、搜索引擎及视频分享服务对用户进行“高度有效”的年龄验证,确保未满18周岁的未成年人无法接触可能对其身心健康构成伤害的内容。未能执行这一要求的公司将面临高达1800万英镑或全球营业额10%的罚款。

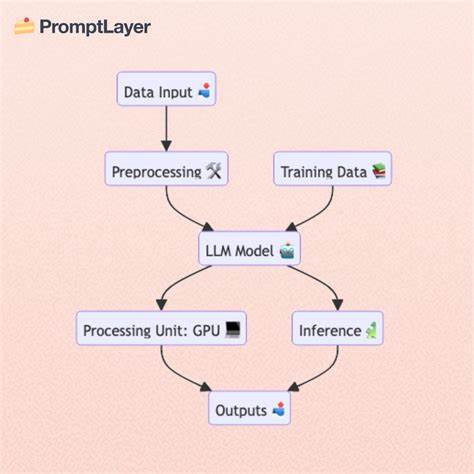

这无疑为平台增加了巨大的合规压力,同时也对内容审核提出了前所未有的严苛标准。 技术层面上,简单的勾选年龄框或同意使用条款已不再被视为合格的年龄验证方式。为了满足监管要求,平台被要求采用生物识别技术,如面部年龄估计、身份证扫描,甚至是使用开放银行账户凭证和数字身份钱包等更为先进的工具。这些技术虽能有效提高验证的准确率,却也带来了用户隐私安全的担忧和技术误判的风险。 在内容管理策略上,平台不仅需要屏蔽未成年人难以承受的非法内容,还必须对可能“有害”的合法内容进行预先过滤,这包括许多新闻类视频、抗议片段及政治评论。实际上,这种算法过滤导致了大量合法内容被错误屏蔽。

例如,2025年7月25日当天,一段记录了英国利兹Seacroft地区反对将寻求庇护者安置在本地旅馆的抗议活动的视频,就在社交平台X被大量英国用户无法访问,取而代之的是“因当地法律限制,需进行年龄验证”的提示。 西约克郡警方明确否认参与屏蔽行动,而平台本身则未作公开回应,其人工智能聊天机器人Grok暗示该视频因涉及暴力内容而被自动限制。这类通过自动系统筛选暴力场面以保护未成年用户的举措,虽然初衷良好,但同时也忘记了新闻透明度和社会监督对民主的重要意义。抗议录像往往是揭示社会问题和政府行为的重要证据,限制其传播无疑削弱了公众知情权和表达权。 另一令人关注的问题是年龄验证流程的不透明和难以操作。目前平台上的年龄核验机制采用的是基于内部信号的估算模式,如账户创建时间、历史验证信息以及用户行为数据。

一旦系统无法确认用户已满18岁,他们便被默认置于敏感内容过滤模式,用户无法主动发起验证请求。这种默认“关闭模式”极有可能导致成年用户长期处于内容受限状态,减少了他们对合法信息的访问机会,而心理学研究也表明,人们通常不会主动改变预设的选择,这加剧了这种不平等现象。 从更广泛的视角看,《在线安全法》的实施改变了互联网内容可见性的默认逻辑。过去,合法的言论和信息可以自由公开地传播,用户默认享有访问权利。然而,新的监管环境似乎在推行一种“默认关闭”模式,即未经一定的年龄验证程序,用户无法获得完整内容访问权。这种模式虽然在保护未成年人方面提供了便利,却也带来了言论自由的隐忧,尤其是在涉及政治表达和社会抗议的领域。

社交媒体巨头们在应对法规的同时,也面临着如何在内容安全与言论自由之间找到平衡点的难题。部分平台采取了较为保守的策略,大面积屏蔽敏感内容以规避潜在风险;另一些平台则试图通过创新技术手段缓解用户验证的门槛,确保成年用户的正常内容体验,但普遍尚未形成完善机制。 在未来的发展趋势中,数字身份认证或将成为网络世界的标准配置,帮助平台更加精准地判定用户身份和权限,降低误判和过度限制的可能性。然而,这也引发了关于数据隐私、监控扩张及技术滥用的担忧。社会各界如何在保障个人自由权利与保护未成年人权益之间取得合理平衡,仍需持续关注和深入探讨。 总体而言,《在线安全法》的实施体现了互联网治理从宽松自治向严格监管转变的趋势。

在保护弱势群体免受伤害和维护公共安全的基础上,必须警惕监管措施引发的言论审查与信息封锁风险。政府、平台和用户三方应共同推动透明、高效且公平的内容管理体系,保障网络空间的开放性与安全性,实现技术进步与人权保障的有机结合。呼吁社会关注网络平台对合法新闻及抗议内容的过滤现象,推动制定更合理、更具包容性的法规和操作指南,让网络成为公民自由表达的真正舞台。