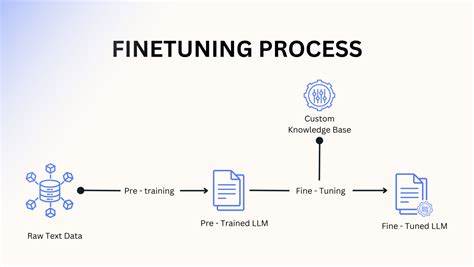

在人工智能领域,随着大规模预训练模型的普及,机器学习工程师们越来越重视微调技术的重要性。微调(Fine-Tuning)指的是基于一个已经预训练好的大型模型,通过少量定制化数据进行调整,以适应特定任务或业务需求。相比从零开始训练模型,微调具备显著的效率优势和更优的性能表现,成为2025年机器学习工程师不可或缺的秘密武器。 预训练模型的兴起改变了传统机器学习的面貌。大型语言模型(LLM)如GPT系列、BERT以及其他Transformer架构模型,通过在海量文本数据上学习,掌握了丰富的语言知识和模式。但预训练本身并不能直接满足特定应用场景的需求,比如医疗诊断、金融分析或客户服务。

此时,微调技术应运而生,它让工程师仅用相对较小的训练集,就能使模型专注并优化特定领域的表现。 微调不仅节省了训练时间,也显著降低了计算资源的消耗,同时还能利用预训练模型学到的通用知识,避免孤立训练带来的信息孤岛与过拟合风险。换言之,微调是一种充分利用已有资源,快速适配多样化任务的高效手段。因此,掌握微调技术对于任何希望在AI应用和工业界取得优势的工程师而言,都是必不可少的能力。 近些年来,随着技术迭代,微调方法也不断进化。从最初的全参数微调,到后来的参数高效微调(如LoRA、Prefix Tuning等),以及基于强化学习的人类反馈微调(RLHF),这些创新极大地提升了模型适应性的灵活性和性能表现。

特别是RLHF,结合了人工反馈与强化学习,从根本上改善生成模型在理解和满足人类需求方面的能力,是当前和未来AI模型优化的重要趋势。 对于实际应用,Hugging Face推出的TRL库成为了开源社区和工业界的福音。它封装了微调流程中的复杂步骤,让机器学习工程师能够更快捷、更简单地进行包括RLHF在内的先进微调操作。TRL的普及不仅降低了技术门槛,还促进了社区交流和知识共享,使得微调技术的应用更加广泛和深入。 在2025年,微调技术已经从理论和实验阶段,迈入了规模化商用落地的黄金时代。各行各业纷纷借助微调优化后的AI模型提升生产力和智能化水平。

无论是智能客服、内容生成、医学影像分析,还是金融风控和自动驾驶,微调的价值无可替代。它不仅增强了AI技术的适用通用性,更促进了跨领域的合作和创新。 未来,随着模型规模不断扩大和多模态技术的兴起,微调技术将持续演进。如何更高效地利用有限数据进行模型调整,更智能地结合人类知识与反馈,将是工程师需要重点关注和钻研的方向。同时,隐私保护和模型安全性也会成为微调实践中不可忽视的重要议题。 总的来说,微调作为连接预训练模型与具体应用场景的关键桥梁,已经成为推动AI技术普及和落地的核心动力。

2025年的机器学习工程师若能娴熟掌握微调,必将在激烈的人工智能竞争中占据优势,实现创新与价值最大化。未来的人工智能世界,离不开微调这瓶“秘密酱料”,它将持续释放模型潜力,塑造更加智能和高效的技术生态。