人工智能领域的不断进步,推动着交互方式和应用场景的日益丰富。作为行业领先者之一,OpenAI始终致力于通过优化模型接口设计,提升开发者与AI模型的交互体验。近日,OpenAI推出了全新的Responses API,这一接口不仅继承了此前API的优势,更针对GPT-5等推理模型进行了深度定制,开创了智能推理和多模态交互的新纪元。 Responses API的设计灵感来源于解决传统API在多轮推理和工具调用中的局限性。早期的/v1/completions接口主打简单的文本补全功能,虽然便捷,但在复杂任务上的适应力有限。随着强化学习与对话模型的崛起,OpenAI推出了/v1/chat/completions,支持角色设定和上下文维持,极大丰富了对话交互体验。

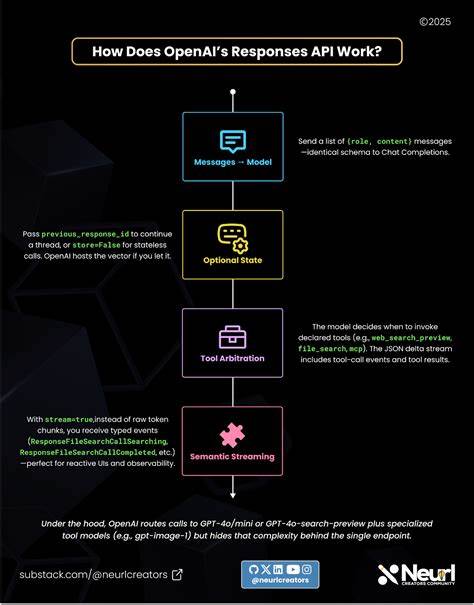

然而,随着模型能力的提升,用户对连续推理和多任务协作的需求日益增强。传统的chat completions接口在多轮推理时丧失了先前的思考痕迹,如同侦探每次离开现场就忘记线索一般。这直接影响了任务完成的效率和准确性。为了解决这一痛点,Responses API应运而生。 它以"智能推理循环"的理念设计,让模型在多轮交互中保持思考状态,犹如侦探始终携带调查笔记,确保每一步决策基于完整的背景信息。相比单条消息输出,Responses可以返回多种类型的输出项,包括模型的文字回复、工具调用记录、中间推理步骤等,让开发者不仅获取最终答案,还能追踪推理链条。

这种分层次、多样化的响应结构为构建复杂智能应用提供了坚实基础。开发者可以根据需求选择展示内容,提升透明度和调试效率。特别是在涉及代码解释器、文件检索、网络搜索等托管工具时,Responses管理了服务器端的工具执行流程,显著降低了延迟和成本,同时避免了频繁依赖客户后端转发请求造成的瓶颈。 OpenAI深刻认识到模型推理链路的隐私与安全挑战。直接暴露模型"链式思维"(Chain of Thought)内容,虽然能增加可追溯性,但伴随误导信息、敏感内容泄露以及知识产权风险。Responses API选择将推理状态加密并隐藏于客户端之外,既保障了推理的持续性,也保护了用户和平台的利益。

这种设计体现了OpenAI对负责任AI发展的承诺。 多模态支持是Responses API的另一大亮点。它从一开始便内置对文本、图像、音频及函数调用等不同信息形式的统一处理,避免了将多模态能力强行依附于单一文本接口的"补丁式"设计。借助此架构,开发者能够轻松搭建涉及视觉识别、语音交互、实时计算等多样功能的复杂应用,推动AI在人机交互领域实现质的飞跃。 在性能层面,Responses API展现了卓越的表现。内部基准测试表明,该接口在缓存利用率上比传统聊天接口提升了40%至80%,这意味着更低的延迟和更经济的调用成本。

除此之外,API和SDK也针对开发者体验进行了优化,包括语义流式事件支持、结构化的多态输出、以及更加友好的参数组织等,极大提升了开发效率与维护便利性。 与此同时,OpenAI并未放弃Chat Completions接口。相反,对于需求简单、对话单轮性较强的场景,Chat Completions依旧是稳健且成熟的选择。Responses API则定位为连接现有与未来能力的桥梁,是适应持续推理、多模态和智能代理趋势的全新标准。 从长远来看,Responses API不仅是接口层的革新,更代表着智能助手架构范式的转变。它通过持续维护推理状态,结合多样托管工具和丰富的数据类型,构建了一个更接近人类思维过程的"智能循环"。

这一机制不仅能够提升模型的表现,还为未来实现更复杂的自动化任务、实时协作和灵活交互提供了无限可能。 对于开发者而言,拥抱Responses API意味着可以更快捷地构建涵盖实时信息搜集、复杂推理推断、定制化工具调用及跨模态交互的高端应用,无需承担繁琐的状态管理和多系统整合负担。这也使得开放AI生态系统的创新门槛得以大幅降低,推动产业智能化升级。 综上所述,OpenAI的Responses API以其智能推理循环设计、多模态原生支持、托管工具深度整合及安全推理状态保护,推出了一个性能优异且未来感十足的API平台。它不仅满足当下复杂AI应用的需求,更为未来人工智能技术的不断突破奠定了坚实基础。不断迭代的技术和活跃的开发者社区,无疑预示着Responses API将在接下来的岁月里成为行业标准,带来更加智慧和高效的数字时代人机交互体验。

。