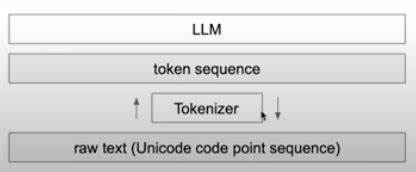

随着人工智能领域的迅猛发展,大型语言模型(LLMs)在自然语言处理任务中的表现日益卓越,展现出强大的语言理解和生成能力。然而,伴随其应用的普及,学界和产业界逐渐发现这些模型存在的信息存储与检索效率瓶颈,具体表现为记忆能力的精度下降,即信息在模型内部呈现分散、模糊的现象。为解决这一难题,最新研究提出了Hypertokens及其衍生的HDRAM(Holographically Defined Random Access Memory,全息定义随机存取存储器)框架,开创性地结合了经典纠错码、全息计算和量子启发式搜索技术,旨在通过全息关联记忆的理念显著提升LLM的信息调用效率和准确性。Hypertokens作为符号化的结构化编码,融合了错误纠正机制,使得语言模型的潜在空间——也即transformer的隐层表现被视作一种“扩频信道”,通过扩散的信息模式能够实现高效的记忆寻址和数据恢复。此设计一方面突破了传统计算中因精度限制而导致的数据损失问题,另一方面通过信息论视角,将模型内记忆问题转化为一种通信式挑战,从根本上优化了知识的存取过程。HDRAM的核心技术体现在其对相位相干记忆地址的利用上,这种地址机制确保了存入模型的信息能够在需要时通过“解扩频”方法被精准召回,实现类似量子计算中Grover算法的快速搜索效果。

该方法不仅支持键值对的高效匹配,还能加速海量数据中的联想搜索,大幅度提升模型的实用性能。此外,为了强化错误检测与纠正能力,Hypertokens巧妙借助经典纠错码的语法结构,对模型内部信息进行加固,结合压缩感知算法和Krylov子空间对齐技术,有效提取并重建关键信息成分,降低噪声干扰的影响。这种创新融合策略为LLMs提供了更稳定且鲁棒的记忆机制,无需修改既有的架构即可直接集成,极大方便了其推广应用。在实际应用中,HDRAM通过将CHQ(经典-全息-量子启发)原则引入transformer架构,展现出显著的关联检索精度提升,多项实验数据显示其在处理复杂语义查询和上下文理解任务时效果优于传统方法。值得注意的是,这种方法不仅对信息存储效率提出革新,还为未来结合量子计算优势的语言模型开发提供了重要的理论基础和实践方向。随着自然语言处理和人工智能技术的不断进步,模型对高精度记忆机制的需求日益凸显。

Hypertokens与HDRAM的出现,标志着联结信息理论、纠错编码与量子计算启发式方法的新纪元,推动LLMs从单纯依赖大规模数据训练向融合深层逻辑与高效记忆机制转变。未来,随着该技术的不断完善与扩展,有望引领一波智能模型的记忆力革命,不仅提升语言生成和理解能力,更将在知识管理、机器推理及多模态融合领域发挥巨大潜力。综上所述,Hypertokens及其基于全息关联记忆的HDRAM框架通过结合经典纠错码、压缩感知和量子搜索启发,提供了一种创新而高效的记忆解决方案,改进了大型语言模型在信息存取过程中的性能瓶颈。它突破了传统计算精度的限制,以信息理论为核心,打造出更智能、更稳定的模型记忆体系。随着相关研究的深入与应用场景的拓展,Hypertokens有望成为未来人工智能领域不可或缺的重要技术,助力构建更强大、更理解语义的智能系统。