随着人工智能技术的发展,智能化应用正成为各行业数字化转型的重要推动力。苹果作为业内领先的科技巨头,积极推动在设备端实现强大而高效的智能模型处理,保障用户数据隐私并提升响应速度。为了让开发者能够便捷地使用苹果智能Foundation模型,libai应运而生。作为一款基于C语言的开源库,libai为多种编程语言提供了无缝访问苹果内置AI模型的接口,支持在本地设备上运行AI推理,彻底摆脱对外部网络和云端API的依赖。libai不仅兼具强大的功能性和灵活性,更具备跨平台特性,适用于iOS、iPadOS、macOS、Mac Catalyst及visionOS等苹果生态系统,支持Intel与Apple Silicon架构的Mac,以及iPhone、iPad和最新的Apple Vision Pro设备。针对开发者而言,libai的最大优势在于它通过C语言接口桥接苹果FoundationModels框架,使得C、C++、Python、Rust、Go等几乎所有支持C调用约定的编程语言都能调用苹果智能功能,极大拓展了应用场景范围。

libai的核心设计围绕会话管理构建,应用每次使用AI时都基于独立的会话实例,支持同步和异步两种文本生成模式,并且允许通过回调实现实时流式输出,从而满足交互式界面或长文本生成的需求。此外,libai引入结构化响应生成机制,确保AI输出结果符合预定义的JSON Schema。这种功能对数据抽取、表单填充、结构化信息提取等任务尤为关键,借助内置的验证过程,保证应用端处理的数据准确完整。工具调用是libai另一个引人注目的功能,开发者可以注册本地C语言回调函数作为编译时工具,也能通过Model Context Protocol (MCP) 服务器集成第三方外部服务,实现动态交互和功能扩展。工具定义采用Claude工具格式的JSON Schema规范,保障参数校验和文档自洽,为复杂的接口设计提供了标准化方案。无论是简单的天气查询、日程管理还是复杂的多系统联动,libai都提供了开发友好的基础框架。

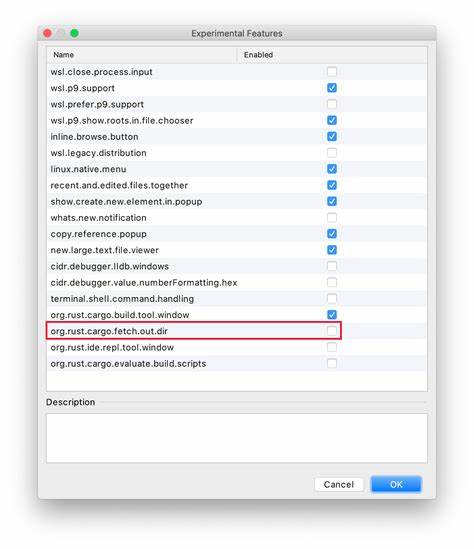

针对安装和构建,libai同样简洁高效。用户可以直接下载安装包,或通过git克隆源码并使用Makefile快速编译,极大降低环境配置门槛。对于开发者而言,只需通过ai_init函数完成库的初始化,创建上下文、会话后便可开始生成文本、处理工具调用和管理会话生命周期。配套文档完善,API说明细致,包括函数参数、返回值说明及内存管理要求,方便快速上手。针对流式文本生成,libai通过定义的回调接口,将来自苹果AI模型的文本生成结果逐块传输,支持应用展现渐进式输出,打造响应迅速的用户体验。示例代码充分展示了从初始化、会话创建、响应生成到回调处理的完整流程。

为了便于开发者深入体验和快速验证功能,libai自带了一个名为momo的终端用户界面应用。momo能够实时流式展示响应内容,支持多行输入和语法高亮,并内置工具调用示范。同时,也支持通过MCP服务器实现外部工具扩展,使得AI交互更加灵活强大。momo项目的开源极大促进了libai生态的建设和社区活跃。值得一提的是,libai不仅局限于单一语言的调用,它提供了语言检测和可用性接口,允许程序根据设备支持的语言列表进行适配,保证了多语言环境下稳定运行。同时,启动前可以使用可用性检测接口判断苹果智能功能是否在设备上启用,确保调用安全。

面对现代软件开发的挑战,错误处理是关键环节。libai提供了全面的错误码体系和错误描述接口,使得开发者能够精准识别问题根源,有效提升调试效率和应用稳定性。技术层面,libai建立在苹果FoundationModels的本地推理能力基础上,单次会话支持约4096个token上下文,考虑这一限制,开发者可以通过会话链机制管理复杂对话流程。未来,libai计划在Windows和Android等非苹果平台上扩展适配,通过统一抽象层实现跨平台智能体验,增强产品竞争力。综合来看,libai作为一款功能丰富、架构清晰的本地AI库,为开发者打开了苹果智能模型的便捷之门。它不仅降低了AI能力集成壁垒,还充分发挥了本地化处理在隐私与速度上的独特优势。

无论是移动端应用、桌面软件还是跨语言服务,libai都提供了坚实的技术基石,助力开发者打造创新智能产品。展望未来,伴随苹果设备和智能模型生态的不断发展,libai将持续优化功能和生态建设,推动本地AI向更加开放、多元、智能的方向迈进。对于所有关注本地智能处理、期待脱离网络束缚的开发者而言,libai绝对值得深入探索和掌握,是实现苹果智能本地化应用开发的首选利器。