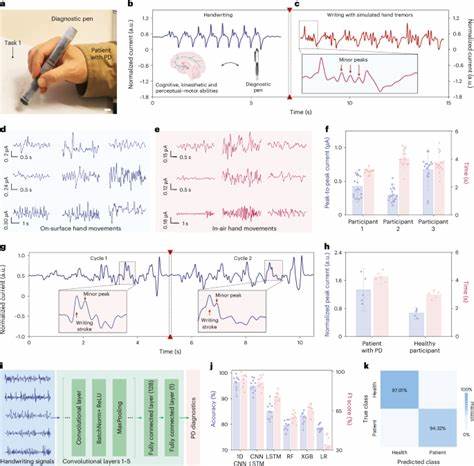

近年来,人工智能在各个领域的应用不断深化,尤其是在政府机构的采购监察和合同管理中,AI的参与度日益提高。然而,伴随着新技术的引入,也暴露出诸多棘手的问题和挑战。特别是在针对退伍军人事务部(VA)合同审查这项极其敏感的工作中,由特朗普政府推动的快速人工智能事件流产(DOGE)项目所使用的AI工具,因其设计缺陷及误判行为,揭示了公共部门运用人工智能时存在的严重风险。 事件源于特朗普于2025年2月发布的一项行政命令,要求对退伍军人事务部所有合同进行30天内的审查,目的是削减开支,优化资源配置。为抢时间完成任务,政府通过DOGE团队研发了一个自动化系统,应用大型语言模型(LLM)来“咀嚼”(munch)合同,即自动判断合同是否可取消。然而,专家们纷纷指出,该系统在设计与执行上存在显著缺陷,多数判定基于不完整甚至错误的信息,最终导致本应保留的关键合同被错误标记。

首先,AI模型所依赖的代码及提示词存在根本问题。引导模型的系统提示尝试教AI区分“直接支持病患护理”的合同与可以取消的“软服务”合同。然而这些定义极度模糊,没有详细界定“核心医疗服务”的具体范畴,也未提供足够背景来识别专业咨询或复杂服务的真实价值。更重要的是,提示中将多样的服务如数据管理、行政管理甚至多元化、公平与包容性(DEI)相关项目都归纳为可取消的“软服务”,反映了政策上的执行导向,但缺少对服务实际作用的充分理解。 此外,该AI系统只读取合同文本的前一万字符,这意味着约75%的文档内容未被分析。合同通常信息冗长且结构复杂,关键条款往往隐藏于后期部分。

限制内容导致模型无法完整把握合同全貌,严重影响了其判断准确性。更糟糕的是,使用的是较早版本的模型,技术上未能利用现有大语言模型强大的信息处理能力,限制了AI在细节识别和专业推理的表现。 在合同金额识别方面,模型经常表现出荒谬的幻想(hallucination)。它误将合同金额估计为3400万美元,显著高于实际数额,这种错误严重影响了风险评估和优先级划分。更令人担忧的是,模型还时常从错误的合同页码抓取数字,显示其缺乏对合同结构和格式的专业理解,说明这一审核系统缺乏基本的合同解析工具支持。 专家指出,常见问题还包括将互联网服务合同等基础设施支出误判为可取消合同。

尽管互联网连通对于现代医疗体系至关重要,但系统却因其远离直接患者护理,而被列入了“可吞噬”列表,暴露出系统在区分“直接支持”与“间接支持”服务上的力不从心。多位学者强调,判断一项服务是否可内包(insourced)需深厚的医疗管理知识和人力资源熟悉程度,若一味依赖一般AI模型,风险极大。 另一个引人注目的问题是针对多样性、公平与包容性(DEI)合同的处理。由于政策意图让这些项目遭受裁减,系统内嵌了将DEI相关服务标记为“可取消”的指令。但实际上,这些内容在合同文件开头很少出现,AI很难准确识别对应条款,结果这些合同并未被大量标记,反映了AI指令与实际文档信息的脱节。 服务中诸如医疗设备维护、合规审计、医疗记录保护以及质量管理等对保障退伍军人医疗安全关键的项目,也被系统分类为“软服务”,认定为可取消,甚至在某些案例中AI自己都承认这些服务“对保证准确性至关重要”,却仍将其含糊地归为行政支持范畴。

此类误判直接威胁到医疗服务的正常运行与安全保障。 在一段对维护天花板升降设备合同的判定中,AI仅因未检测到必要医疗程序信息,便断定其为可取消。殊不知,这类设备在患者护理中扮演重要角色,对于医护人员和病患安全至关重要。此例充分体现AI判定标准的片面性和表浅理解。 此外,许多显示为“可注销”的合同涵盖内容包括视频制作、多媒体、客户支持、基础IT服务、培训和活动策划等。这些项目虽然看似偏“软”,但专业人士指出,他们往往是维持VA整体运作和效率的关键环节,外包合约的取消可能导致内部重组和额外成本增加。

更重要的是,当前VA尚面临人力资源短缺及招聘冻结,强推内部替代存在现实困难,盲目裁撤反而可能削弱机构功能。 针对这些问题,DOGE编写者兼软件工程师萨希尔·拉文吉亚承认整个系统存在缺陷,部分原因是时间紧迫和工具不足,且强调最终的合同取消决策仍需人工复核。虽有人工参与,但自动化筛选的误导已造成影响。此外,政府层面对AI技术的急躁采纳反映了公共政策与科技之间的脱节。 退伍军人事务部对此AI审查机制表示支持,认为这是一种“常识性先例”,并正计划探索将AI技术应用于更多流程,如加速残疾赔偿申请处理。文件显示,初步试点项目使3%的赔偿申请在30天内完成,目标是逐步提升至30%。

然而,批评声音认为,若不解决AI识别不足和误判风险,扩大AI使用范围恐加剧系统不公和服务质量下降。 业内专家建议,为确保AI在公共部门的合理运用,应基于深度专业知识训练模型,明确界定合同类别和服务标准,严格限定可分析内容,避免过度简化和通用指令带来的误导。同时,应确保关键决策始终由具备相关经验的专业人员负责,AI仅作为辅助工具而非最终仲裁者。 总体来看,退伍军人医疗合同的AI辅助审查暴露出当前技术应用在政策执行中的盲点。AI虽具备强大信息处理潜力,但若缺乏准确的指导原则与背景知识,反而可能带来严重后果。未来,政府在引入前沿科技改善公共服务时,需兼顾技术成熟度、应用合理性和透明监督,切实保障退伍军人及公众的切身利益。

AI应是推进效率与公平的助力,而非草率决策的替代品。 这一事件为各级政府提供了宝贵教训,也唤起社会对人工智能伦理与监管的广泛关注。在全方位拥抱智能化的同时,唯有增强人机协同,建立科学规范,方能真正实现技术惠及社会的美好愿景。退伍军人是国家的英雄,他们应享有最优质的医疗保障,而不是成为科技试验的牺牲品。未来的道路虽充满挑战,但科学、审慎、以人为本的技术应用无疑是推动公共服务迈向更好未来的唯一正确方向。