在生产环境中,性能回归常常比功能缺陷更难察觉与定位。它可能悄无声息地出现,只在某项监控或定期任务上暴露异常响应时间,但却会对可用性和运维流程产生严重影响。以下基于一次真实案例,详述从现象发现到问题定位、验证、上游沟通与最终解决的完整流程,重点围绕 ipset/ip_set_swap 的性能退化以及与 Linux 内核补丁的关联,提供可复用的排查方法与实践建议。 问题出现与第一手症状 在对 Kubernetes 节点例行升级与维护后,原本完成于约 2 秒的安全检查脚本突然变成了需要一分钟以上才能返回"ALL OK"。该脚本在运行过程中调用了 iptables-save 来枚举主机上的防火墙规则,发现 iptables/iptables-save 的响应时间大幅增加。快速排查显示,系统在通过 getsockopt 向内核询问 ipset 信息时变慢,strace 显示与 IPSET 相关的 getsockopt 调用延迟显著上升。

定位与假设 将注意力集中到 ipset 后,进一步调查发现节点上存在大量 ipset(示例中超过 6,000 个)。这些 ipset 是由 CNI 插件 kube-router 用于实现 Kubernetes NetworkPolicy 而自动维护的:kube-router 会根据策略把允许的源 IP 加入到某个 ipset,然后在 iptables 中匹配该 ipset。每当 pod 变更或策略变更时,kube-router 会通过一系列 ipset create、swap、flush 操作来原子性地替换集合内容,以免产生短暂不一致。 要重现与分析 ipset 相关的延迟,可以先把 kube-router 生成的 ipset restore 输入保存到文件,然后在受影响主机上单独运行 ipset restore -exist < file,在受控环境下观察延迟。使用 strace -tT 可以看到单个 IPSET_CMD_SWAP netlink 消息的处理时间从微秒级异常变成了毫秒级,差异达到三位数量级。perf flamegraph 也显示 iptables-restore 过程主要时间耗费在等待 ipset 信息返回。

使用 eBPF 做量化分析 为了量化内核函数的延迟分布,可以用 bpftrace 追踪内核函数 ip_set_swap 的入口与返回时间,统计延迟直方图。受影响主机的 ip_set_swap 延迟集中在 8ms 到 32ms,而对照组主机延迟多在几十微秒到数百微秒,这是典型的性能回归信号,说明某次内核变更极有可能引入了额外的同步或等待路径。 从变更回溯到补丁 在检查了升级清单后,注意到内核从 6.1.67 升级到了 6.1.69。查看发行版(例如 Debian/Ubuntu)内核包的 change log,发现一条描述"netfilter: ipset: fix race condition between swap/destroy and kernel side add/del/test"的记录。通过在内核源代码树中定位相关提交并使用 git bisect,可以确认某个提交引入了调用 synchronize_rcu() 的代码路径,从而在高并发或大量 ipset 操作时引起明显延迟。 验证与修复流程 把怀疑的补丁回退或对比构建内核,通过在受影响环境与对照环境上重复 ipset 相关操作,可以验证延迟变化是否与该提交直接相关。

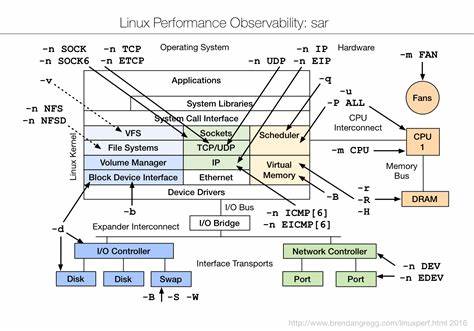

确认后,向 Linux Kernel Mailing List(LKML)和 ipset 子系统维护者报告问题。快速响应的维护者在收到报告后回溯补丁目的及副作用,并提交了兼顾正确性与性能的修复补丁,上游合并后也推到了稳定分支(例如 6.1.y)的维护更新中。 从工程实践角度的可操作建议 在面对类似性能回归时,可以遵循若干可复用的排查步骤:先收集重现场景并最小化干扰,保存相关命令的输入(如 ipset restore 的 stdin),在受控环境单独运行以便重复测量。通过 strace -tT 观察系统调用与 netlink 消息的延迟;用 perf record -g 采样火焰图以确定时间热点;用 bpftrace 或 SystemTap 在内核态对关键函数(例如 ip_set_swap)做延迟直方图或事件计数。对比受影响主机与对照主机的数据可以帮助确认是否为新版本引入的回归。 在变更管理上,建议把内核升级先在规模较小的预发布或灰度环境进行验证,特别是当集群中存在大量 ipset、conntrack 条目或其他网络命名空间相关状态时。

建立关键路径的基准测试并自动化运行,例如批量执行 ipset swap/flush/restore 场景,量化操作延迟与资源占用。升级前把生产节点与控制节点的行为差异纳入回归测试范围,能显著降低升级风险。 应对与缓解手段 当在生产中遇到此类回归,短期的减轻措施包括回滚到上一个已知正常的内核版本,或者在厂商/发行版发布补丁前应用上游补丁的 backport 补丁。另一种可以临时缓解的方法是减少 ipset 的数量或合并规则,降低需要执行 swap 的操作次数。也可以调整 kube-router 或其它控制平面组件的更新策略,合并多次小变更为一次批量更新,减少对 ipset 的频繁操作。 与上游沟通的重要性 及时把可复现的最小复现步骤、性能测量数据和内核回归对比结果提交给上游维护者,是解决回归问题的关键。

像本案例中,维护者迅速确认并提供补丁,证明了开放源代码社区在处理紧急性能回归时的高效互动能力。在报告问题时,提供 strace 日志片段、perf flamegraph、bpftrace 输出以及 git bisect 结果会大大提高问题被快速定位和修复的概率。 长期治理与防范策略 从制度层面看,应把性能回归检测纳入常规 CI/CD 流程。对关键内核路径或依赖组件(例如 ipset、netfilter)制定回归测试用例,定期运行并对比历史基线。如果使用的发行版提供内核补丁或稳定分支,关注安全与稳定更新通告,及时评估补丁对生产场景的影响。对 Kubernetes 网络插件(如 kube-router、Calico、Cilium 等),在升级前阅读发行说明以了解对 ipset/iptables/ebpf 的依赖与变更。

总结与启示 性能回归往往是系统演进中不可避免的一环,但通过系统化的排查流程与合适的工具链,可以快速定位根因并推动修复。关键要点包括:尽量把故障场景最小化并在可控环境中复现,使用 strace、perf、bpftrace 等工具量化内核态与用户态的时间消耗,对比受影响与正常的机器得到明显证据,利用 git bisect 回溯引入回归的提交并与上游沟通。对于依赖大量 ipset 的 Kubernetes 部署,更应在升级策略、测试覆盖与运行时监控上投入关注。 通过这样一套方法论,不仅能解决个案性能问题,还能把经验沉淀成组织的运维能力,使将来遇到类似的 Linux 性能回归时,团队能更快地响应、定位并修复,从而把风险降到最低。 。