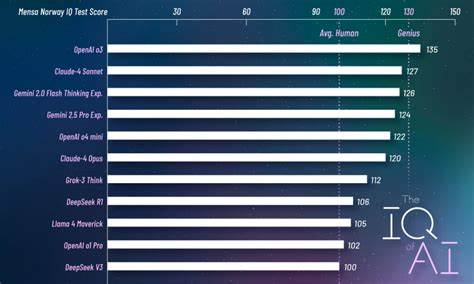

人工智能技术的迅猛发展正在重塑全球科技生态。然而,在这场以数据和算力角逐的赛跑中,数据质量和数据来源的重要性逐渐凸显。人工智能并非仅仅依赖大量的文本数据,更依赖深度、结构化且经过同行评审的科学知识来辅助模型对复杂问题的推理、理解和创造。西方的学术内容在全球科学界享有盛誉,大量核心论文汇聚于顶级期刊之中,其中Elsevier作为学术出版领域的巨头占据重要地位。然而,这背后的版权壁垒正成为西方人工智能发展的一大隐患,而中国正因突破这些限制而获得独特优势。Elsevier的版权管理策略一直强调保护经济利益,严格限制未经授权的文本和数据挖掘行为,尤其是禁止将其内容用于人工智能模型的训练。

这意味着,即使西方的高校和研究机构支付了高额的订阅费用,研究人员和AI团队也难以近乎自由地利用这些数据进行创新开发。西方的科研人员只能“阅读论文”,却无法将其转化为训练数据资源。这种版权模式本质上是印刷出版时代的产物,难以适应数字化和人工智能驱动的时代需求,并且形成了一种隐形的“国家AI税”,无形中抑制了创新活力。相比之下,中国在学术数据获取方面采取了截然不同的策略。凭借集中式的资源管理和政策支持,中国科研团队能够绕过传统的版权限制,获得几乎所有主流西方期刊的访问权限。这种访问不仅通过合法的机构资源获取,还涵盖了使用镜像站点、半合法资源库,甚至直接抓取公开数据的手段。

同时,诸如Sci-Hub这样的工具在国内的某些范围内被默许甚至集成为内部系统的部分,进一步丰富了训练数据集。实际效果显而易见——中国的人工智能模型正在吸收和理解包含最新科学发现的完整学术语料,这为深化理解、跨学科创新和高质量推理提供了坚实基础。此举在全球范围内为中国争取了数据上的领先。另一方面,西方主流的人工智能模型往往依赖赋予大量在线公开信息,包括Reddit社区讨论、维基百科条目以及各种网络博客内容。虽然数量庞大,但这类数据缺乏系统严谨的审校和结构化表达,难以支撑更高级别的科学应用。显然,在“用什么训练AI”上,量与质的平衡至关重要。

计算能力固然重要,但最终决定胜负的是训练数据的深度与广度。掌握了几乎所有核心科学论文的中国,正逐步在这一关键环节中建立优势。而西方国家因版权制度束缚,陷入内容获取困境,难以匹配相同的学习速度。这种差距不仅影响科研发展,也关乎整个技术产业的未来布局。人工智能被比作新一代的“电力”,它将驱动经济、医疗、工程和众多其他领域的创新。Elsevier及类似出版商的版权政策仿佛一道大坝,努力控制着知识数据的流动,而中国则悄然构建绕行渠道,破解这一阻碍。

未来,谁能共享最丰富、最权威的内容资源,谁就拥有塑造AI时代的话语权。虽然存在法律和伦理争议,但从战略视角看,中国的这一策略无疑提升了其在人工智能领域的国际竞争力。与此同时,西方的研究机构和企业也开始意识到传统版权体系的限制,正寻求通过政策改革、谈判新版权协议或其他创新方式打破瓶颈。然而,这一过程进展缓慢,远远赶不上迅速变化的AI技术节奏。此外,语言与文化复杂度也是一大因素。有观点认为汉语的字符体系及复杂语法结构增加了模型训练难度,但事实上,这种复杂也迫使开发者创造更先进的技术,从而间接促进AI能力的提升。

中文处理的挑战反而成为推动技术进步的动力之一。归根结底,数据归属和访问权是决定人工智能未来走向的核心问题。中国利用集中化资源和非传统获取方式,为AI训练提供了丰富的科学知识土壤。这种优势在长远看,不仅仅关乎技术,更关乎国家在全球科技竞争中的主导地位。全球AI发展应关注如何实现知识共享,推动开放科学,同时确保版权合理价值,为创新提供更优沃土壤。否则,像Elsevier这样固守旧版权模式的机构,将可能成为挫败全球AI潜能释放的最大阻碍。

中国通过绕过版权壁垒,在人工智能领域抢占先机的故事,已经证明数据和内容的开放与获取,在数字时代的重要性远远超出传统的资源投资与算力比拼。这一切正逐步改写全球科技竞赛的规则,改造未来产业版图。