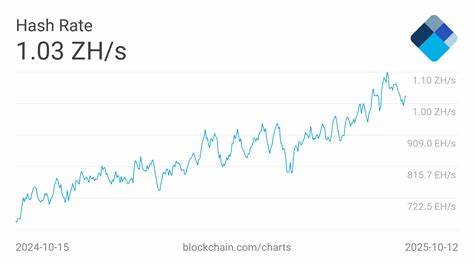

近年来,大型语言模型(Large Language Models,简称LLMs)在自然语言处理领域表现出惊人的能力,尤其是在生物医学领域,成为推动自动化文本分析、信息提取、辅助诊断和医患交流的重要工具。然而,随着模型规模不断扩大,所需的计算资源和存储空间也呈指数增长,这对实际应用尤其是在资源有限的医疗环境中造成了巨大障碍。生物医学数据通常涉及患者隐私,限制了云端处理的可行性,使得研究人员和医疗机构亟需高效且安全的本地部署方案。量化技术作为一种有效的模型压缩策略,正逐渐成为解决这一难题的关键。量化是指将模型中的浮点数参数转换为低精度数值表示,如8位或更低,从而极大地降低模型对GPU内存的需求,同时保持推理速度和性能。最新研究表明,通过对包括通用和生物医学专用的十二种大型语言模型在内的全面评估,量化可以将显存使用率降低多达75%,使得高达700亿参数规模的模型能够在仅有40GB显存的消费级GPU上运行。

这意味着医院和研究机构无需依赖昂贵的服务器或云端服务,便能利用行业领先的语言模型处理医学文本,保障患者数据安全。技术层面上,量化不仅压缩模型大小,还在一定程度上优化了模型的响应效率,有助于实现实时应用。例如,在命名实体识别(NER)、关系抽取、多标签分类和问答系统等关键任务中,量化后的模型表现依然维持在高度接近原始模型的水平。这对于医疗领域尤为重要,因为错误或信息丢失都可能导致严重后果。更值得关注的是,特定于生物医学领域的知识和语义理解也未因量化而显著衰减。这表明,量化处理并未削弱模型对专业术语和复杂语义关系的敏感度,反而推动技术在临床文本挖掘、药物发现和医学研究中的广泛应用。

先进的提示工程方法同样展示了良好的兼容性,即使在低精度模型下,复杂多轮对话和推理也能有效进行,为智能助手和自动化诊断系统提供了坚实基础。在实际应用层面,由于量化降低了硬件门槛,更多医疗机构能够自主掌控数据处理流程,避免因传输或存储引发的隐私风险。这不仅符合各国日益严格的数据保护法规,也提升了医疗服务的安全性与信任度。此外,量化还促进了模型生态系统的发展,研发者能够通过开放代码和工具,快速部署优化后的生物医学LLMs,推动学术交流与技术创新。未来,随着量化技术与模型架构的不断进步,预计会出现更高效、精细化的模型压缩方案,进一步缩减资源消耗,提高模型适应性和推理速度。结合联邦学习、多模态融合和知识蒸馏等前沿技术,将为生物医学人工智能带来更多突破,助力精准医疗和智能健康管理。

总而言之,量化大型语言模型在生物医学自然语言处理中的应用,正在打破硬件瓶颈,实现安全高效的本地智能化服务。其显著降低的计算成本和强大的性能保持能力,为临床实践、中药研发、学术研究等多个领域带来了前所未有的便利和可能。随着技术不断成熟,量化必将成为医疗AI发展的重要推动力,助力行业迈向更加智慧、安全的未来。 。