在当今科技飞速发展的时代,数据规模和复杂性正以前所未有的速度增长,特别是对于像特斯拉这样在智能制造和新能源交通领域领先的企业而言,构建一个高效、可靠且可扩展的观测平台显得尤为关键。特斯拉不仅需要对其遍布全球的Gigafactory工厂进行精准监控,还要实时追踪数百万辆联网汽车和复杂的能源管理系统,庞大的数据量对背后的数据处理技术提出了极高要求。面对这一挑战,特斯拉选择了ClickHouse这一开源列式数据库,打造了名为Comet的观测平台,实现了千万亿级别的数据存储和实时查询能力,树立了工业级数据分析的新标杆。 特斯拉观测平台的需求远超一般企业,背后是亿级时间序列数据的挑战。传统监控系统如Prometheus虽在中小规模应用中表现不俗,却因单机架构的限制无法满足特斯拉海量指标数据的水平扩展和高可用需求。该系统在面对巨量数据时容易产生性能瓶颈,且存在数据丢失风险,是特斯拉无法接受的。

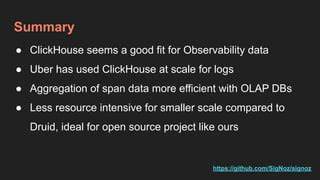

相较之下,ClickHouse具备卓越的水平扩展能力,以列式存储和高性能压缩技术支持海量数据的写入和查询,确保系统具备极高的吞吐量及容灾能力。 ClickHouse不仅保证了数据的高效持久化存储,更让特斯拉能够简单灵活地执行复杂的分析和自定义查询。特斯拉工程师们通过Comet平台可以使用熟悉的PromQL查询语言,一方面保留了原有监控系统的语法优势,另一方面借助ClickHouse的卓越性能实现秒级查询响应。值得一提的是,ClickHouse支持用户自定义函数(UDFs),为复杂指标处理提供了强大后盾,使得工程师无论对何种业务逻辑都能迅速实现。 在架构设计上,Comet采用了两条并行的核心数据管道。一条主要负责数据的高速摄取,利用OpenTelemetry分布式收集器将指标数据输送至Kafka兼容队列,再通过定制的ETL流程将其转换成适合列式存储的结构数据批量写入ClickHouse。

该流程支持系统横向扩展,即使在数据量剧增期间也能保持稳定的吞吐和低延迟。另一条则专注于PromQL查询的实时转译,将用户请求转换成高效的ClickHouse SQL查询并即时返回字节级完全兼容Prometheus接口的结果,保证所有仪表盘和告警规则的无缝承接。 据特斯拉高级软件工程师Alon Tal透露,在Comet投入生产环境前,团队曾进行了一次突破性测试:向系统持续写入每秒十亿行数据,运行持续长达11天,系统表现稳定,CPU和内存使用保持平稳无异常。最终数据量超过一千万亿行,刷新了业界对观测平台性能极限的认知。这种规模的承载力,不仅展现了ClickHouse卓越的性能,也让特斯拉的监控体系能够无忧应对不断增长的业务需求。 Comet之所以能够实现如此惊人的性能和可靠性,关键在于结合了ClickHouse的强大引擎与特斯拉对系统可用性与灵活性的严格把控。

系统设计保证了即便某部分硬件或服务故障,数据也不会丢失,持续稳定提供指标查询服务。复杂多样的查询需求和自定义分析任务也能快速响应,给予工程师强大支持。 得益于Comet,特斯拉的运营团队能够实时洞察从制造设备到全车联网的各种关键指标,准确识别运输异常、预测设备风险以及优化能量消耗。这不仅提升了工厂与车辆的运维效率,也极大增强了特斯拉整个生态系统的智能化水平,有效推动了其自动驾驶、能源管理等核心业务的技术迭代。 展望未来,特斯拉还计划基于相同架构逐步拓展更多观测维度,包括分布式追踪(TraceQL),实现对事件链路的全面监控和追踪分析。这将赋予工程师在故障排查和优化流程上的更强洞察力。

更令人期待的是,特斯拉考虑将Comet开源,让更多企业和开发者得以体验和借鉴这一高端观测平台的设计理念和运营经验。 总结来说,特斯拉的千万亿级观测平台Comet充分彰显了现代数据基础设施与创新工程结合的巨大潜力。通过选择ClickHouse作为核心数据引擎,不仅突破了单机系统的瓶颈,还实现了极致的数据摄取速度和查询响应能力。配合完善的高可用设计和PromQL兼容性,Comet真正满足了特斯拉在极端规模与多样场景下的观测需求。 这一成就为整个行业提供了宝贵的借鉴样本,证明在面对指数级增长的数据挑战时,高性能分布式数据库与灵活架构的结合必不可少。未来,随着更多创新技术的加入,基于ClickHouse的观测平台必将以更丰富的功能和更稳健的性能,助力企业驾驭数据海洋,实现数字化转型和智能决策的跨越式发展。

。