在数字化时代,数据已成为企业的核心资产。产品分析作为驱动业务增长和优化用户体验的重要手段,依赖于对庞大用户行为数据的高效查询与分析。然而,许多企业在进行复杂的产品分析查询时遭遇性能瓶颈,尤其是在使用传统事务型数据库时,往往会出现数据库资源被长时间占用,甚至系统宕机的风险。本文将系统解读如何在保证数据分析需求的前提下,避免数据库宕机,实现产品分析查询的高效稳定。 首先,我们需要明确为什么传统事务型数据库容易在执行复杂分析查询时出现性能问题。事务数据库设计初衷是快速处理高并发的简短读写请求,保障数据的ACID特性。

典型场景下,查询往往是点查或者小范围的数据读取,事务数据库在这类操作中表现卓越。然而,产品分析需要对海量数据进行大规模扫描和聚合操作,一条分析查询可能涉及数百万行数据,复杂的join、group by及distinct计数操作使得数据库CPU和内存资源消耗剧增。在多用户并发执行分析查询的情况下,单节点数据库容易出现资源争抢,导致CPU飙高、I/O饱和,最终影响整个系统的响应速度,严重时甚至引发宕机。 举例来说,一条针对过去12个月客户购买数据的查询,可能会涉及跨表扫描、时间范围过滤、多维度聚合等多重计算。若无专门优化,数据库会进行全表扫描,构建内存中的hash表以实现join和group by,distinct计数则进一步增加内存使用。这种资源密集型操作在高峰期尤为明显,当闪购活动等导致交易量暴增时,数据库负载迅速抵达极限,影响业务系统正常运行。

数据库宕机不仅导致用户体验变差,更直接造成收入损失和客户流失。 面对这一挑战,传统做法通常是对现有数据库进行“规模升级”。通过创建多种索引以加速查询条件的过滤,数据库能够更快定位数据,减少全表扫描的发生。但索引的改善是有限的。随着业务量增长,写入操作必须同步更新所有索引,写性能必然受到影响,写入延迟增加。此外,索引对聚合计算尤其是distinct计数无能为力,仍需扫描大量数据完成计算。

索引加多后数据库空间使用大幅增长,带来运维和存储成本的攀升。 另一种常见改进是利用只读副本分担分析查询压力。通过将分析请求定向到副本,主库性能得以短暂缓解。然而读取副本的维护依赖主库,需要同步所有索引,写入端瓶颈仍然存在。副本架构提升了读取吞吐,但无法根治根本问题,丢失了真正意义上的分析查询优化。 为了进一步提升查询效率,材料化视图成为热门方案。

材料化视图允许预先计算聚合结果,查询时直接读取视图而非底层数据,显著降低查询时的资源需求和响应时间。尽管降低了延迟,材料化视图要求定期刷新,维护工作量随数据规模增长而增加。视图若未及时更新,将导致分析数据滞后,用户体验受损。保持视图与底层数据一致的复杂性在中大型系统中尤为突出。 表分区技术虽然未被所有团队采纳,但也是传统数据库优化分析查询的重要手段。通过按时间、地域等维度分区,查询时限制扫描特定分区,避免扫描整个大表。

分区减少了I/O负担,但分区设计需合理,管理复杂度提高。同时,分析查询往往涉及跨分区聚合,仍然需要一定资源,效果有限。 纵向扩展通过升级服务器硬件如CPU、内存和存储,短期内提升查询能力,但单机扩展存在天花板,硬件成本逐渐攀升。横向扩展采用数据分片技术,将数据分散存储在多台服务器,通过分布式查询实现性能提升。分库分表引入了应用层复杂性,需要开发额外的路由逻辑和一致性保障,带来开发和运维挑战。多节点协同的复杂度较高,不适合初创和中小团队。

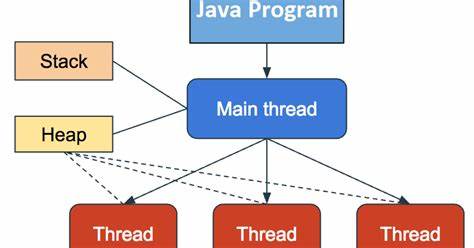

根本上,事务型数据库和分析查询的需求存在本质上的架构不匹配。事务数据库主要优化点查和高并发短事务,分析查询则要求大规模列扫描、压缩、高效批处理。针对这一点,分析数据库通常采用列存储格式,按列存储数据,极大提升压缩率和I/O效率。利用列式存储,仅访问查询所需的字段,减少无谓读取;同时,向量化执行引擎可批量处理数据,充分利用CPU SIMD指令,实现高速计算。 这推动了企业逐步引入专门的数据仓库和列式数据库。典型的做法是构建ETL(抽取-转换-加载)流程,将生产数据库中的数据定期抽取,经过清洗、转换后加载至分析型仓库中,比如Snowflake。

分析团队可以在仓库中执行复杂查询,解放生产数据库资源。此举大幅提升查询性能,使仪表盘响应时间缩短至毫秒级。但这种方案也带来新的挑战,如数据延迟(通常每日刷新)、管道维护复杂性、依赖专门数据工程团队等。企业需权衡实时性与稳定性,明确团队职责分工,防止沟通成本上升和故障排查困难。 针对不具备成熟数据团队及庞大数据量的企业来说,传统数据仓库架构可能过于复杂。近几年,涌现出多种轻量化、嵌入式或专为在线分析设计的创新数据库技术。

例如,DuckDB作为一种嵌入式分析引擎,无需运行独立服务,可直接集成到应用或数据科学工作流中,适合本地分析和探索性查询。ClickHouse则拥有分布式架构,擅长处理海量数据,适用于对延迟和吞吐要求极高的场景。BemiDB作为PostgreSQL的分析只读副本,以开源单进程binary形式实现数据同步,兼顾了PostgreSQL兼容性和列式存储优势,简化运维难度。Materialize引入流式计算和增量视图技术,提供实时分析能力,适合需要持续监控的业务场景。 选择合适的分析技术,应基于企业的数据规模、实时性需求和团队能力。对初创企业和中小团队而言,先在生产数据库上保持事务负载的稳定性,将分析查询迁移至轻量级列式分析引擎,是有效避免数据库宕机的策略。

仅当数据源多样、数据量巨大且需要跨业务系统整合时,再考虑搭建完整数据仓库,充分发挥其优势。 总之,避免数据库宕机的关键在于理解事务数据库和分析查询的不同需求,将分析负载从生产数据库剥离出来,利用现代分析数据库技术实现高效查询。同时,合理设计ETL流程和数据刷新策略,协调数据团队与产品工程团队的协作,才能构建稳健且可扩展的产品分析体系。未来,随着分析技术的不断进步,企业有望以更低的成本和更简单的架构,实现对产品数据的深入洞察,驱动业务持续优化和创新。