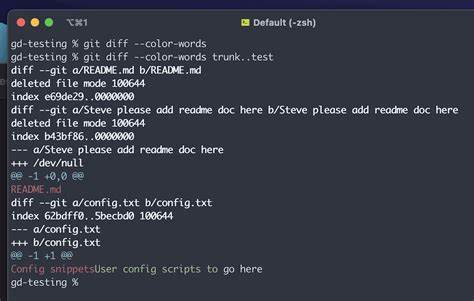

随着机器学习技术的广泛应用,模型版本管理和对比分析日益成为数据科学家和工程师面临的重要挑战。传统的代码版本控制工具虽能管理代码变化,但无法直接揭示机器学习模型在预测行为上的差异。为此,开源项目Tarmac应运而生,提供了一种以类Git diff方式进行机器学习模型比较的全新思路,不仅帮助用户直观理解模型间的差异,还支持生成可解释的规则,极大改进模型的透明度和可管理性。Tarmac是由adrida团队开发的开源Python包,旨在帮助开发者理解和文档化不同版本的机器学习模型之间预测的差异。它不仅能比较两种模型的输出,还能自动判断任务类型(分类或回归),并通过智能采样策略选取合适的数据进行模型对比,最高效地捕获和解释模型预测差异。使用Tarmac,用户能够获得结构化的输出结果,既支持JSON格式便于后续自动化处理,也有易读文本格式,满足不同使用场景的需求。

此外,项目未来计划支持基于欧盟AI法案的自动合规性报告生成功能,帮助企业在监管日趋严格的环境中保持合规性。比较机器学习模型的传统方法通常依赖于总体性能指标,如准确率、均方误差等,但这些指标难以揭示模型预测差异发生的具体数据区域及原因。相较之下,Tarmac所采用的解释性决策规则,能够明确指出模型在哪些输入样本上产生了不同预测,及其差异背后的逻辑依据。其实现基于最新研究成果,特别是2023年发表于DynXAI研讨会的论文“Dynamic Interpretability for Model Comparison via Decision Rules”,该方法通过提取决策规则动态解释模型间差异,极大提高了模型差异分析的透明度和实用性。在实际应用中,Tarmac支持使用内置数据集如iris和diabetes数据集,方便用户快速上手和调试。对于更复杂场景,用户可以输入自定义的数据集,采用联合采样策略覆盖两个模型的训练数据,然后进行系统性的比较分析。

其自动任务检测功能可智能识别模型属于分类还是回归任务,必要时提供用户自行指定的灵活性,配合可调节的参数如最小叶子样本数和误差阈值,使得差异检测既敏感又稳定。Tarmac的安装相对简单,用户只需从GitHub克隆源码并通过pip安装即可使用。丰富的命令行接口和示例便于用户在具体项目中快速上手,实现模型间差异的探索性分析,同时可输出详尽的解释报告,有助于跨团队的沟通和决策。更重要的是,Tarmac作为AGPL-3.0许可下的开源项目,鼓励社区贡献和改进,同时保障项目的自由和开放。对于希望深化模型管理、提升模型演变可解释性,以及满足未来合规性需求的企业和研究机构来说,Tarmac无疑是一个创新且具巨大潜力的利器。放眼未来,随着人工智能治理法规的不断完善,自动生成合规报告的能力将成为机器学习工具链中的关键模块。

Tarmac将通过新增功能,使得合规检查自动化成为可能,极大减轻数据科学家和法律团队的负担。通过对比模型在不同数据子空间的决策边界,用户不仅能发现模型改进或退步的具体区域,还能据此制定针对性的优化策略,从而推动模型持续演进。总之,Tarmac突破了传统模型对比工具的限制,实现了机器学习模型差异的深度可解释性,既适合学术研究探索,也契合实际工程应用需求。随着生态的壮大和功能完善,它有望在未来成为机器学习生命周期管理中不可或缺的核心组件,助力AI技术健康、透明和负责任的发展。