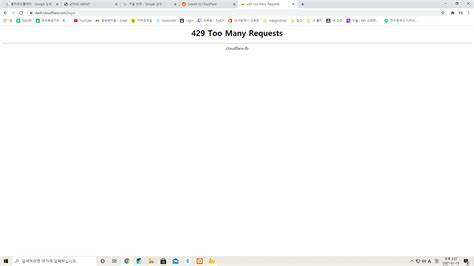

随着云计算服务的快速发展,Cloudflare作为领先的互联网基础设施提供商,其创新产品R2(无服务器对象存储服务)因高性能和灵活性受到广泛关注。然而,近期Cloudflare R2服务经历了显著的429错误激增,给众多依赖该服务的用户带来了不小的困扰。这一事件不仅影响了大量网站和应用的正常运行,也引发了业界对服务稳定性和流量控制机制的广泛讨论。本文将深入解析此次429错误激增的背景、技术细节、影响范围以及Cloudflare的应对措施,帮助读者全面了解这一事件的来龙去脉。首先,了解429错误的基本概念非常重要。HTTP状态码429代表"请求过多"(Too Many Requests),这是服务器用来告知客户端发出的请求数量超过其允许阈值的一种反馈。

当用户或应用在短时间内向服务器发送大量请求时,服务器可能为了保护自身资源和整体服务质量,采取限制策略,从而返回429状态码。Cloudflare R2作为一个分布式对象存储系统,在数据访问和传输过程中需要维持高吞吐率和低延迟,同时需要避免资源过载。近期发生的429错误率激增,意味着在某段时间内,R2服务的请求超过了其设计的限制,触发了流量控制策略。根据Cloudflare官方发布的状态更新信息,该事件于2025年9月1日开始引起异常,Cloudflare团队迅速察觉到客户访问R2时频繁收到429错误的情况,并立即启动调查。这种错误等级的集中爆发,通常反映了某种内部机制的异常或外部流量激增。调查显示,部分自动化访问脚本和大量并发请求可能导致请求速率突破了R2的请求阈值限制,从而触发频繁的限流响应。

Cloudflare对相关机制进行了调整和优化,最终在当日晚上成功实施修复措施,随后错误率显著下降,服务恢复正常。此次事件的影响范围涵盖了使用Cloudflare R2存储进行数据托管的众多网站和应用,尤其是依赖实时数据访问和大规模静态资源存储的企业客户。429错误频发不仅导致请求失败,造成用户访问体验下降,也可能使自动化服务和缓存策略失效,影响业务整体稳定性和响应速度。面对这种突发状况,如何有效应对成为业界关注的重点。Cloudflare方面表示,他们采取多管齐下策略解决问题。首先是精准定位异常请求流的来源,对恶意或异常流量进行快速限制,防止请求过多情况进一步恶化。

其次,调整请求限流算法,优化资源负载均衡,提升系统的弹性与容错能力。最后,加强监控告警体系,实现对异常波动的早期预警和自动响应。通过这些措施,Cloudflare成功控制并恢复了R2服务的正常运行。从技术层面来看,这次事件凸显了大规模分布式存储系统在面对突发流量变化时的脆弱性。限流机制虽能保证服务资源的健康使用,但如果设置不合理,可能导致正常业务受到误伤。如何在保证系统稳定性的同时,提升对真实业务流量的识别能力,是未来优化方向。

对于使用者而言,合理设计访问模式,减少不必要的高频请求,同时积极利用缓存机制,可以有效降低触发限流的风险。此外,及时关注Cloudflare发布的状态更新和公告,有助于在服务异常期间快速调整策略,确保业务连续性。本次429错误事件也反映出云服务供应商与客户之间的沟通重要性。Cloudflare通过透明发布事件进展,展示了承诺和专业性。未来,期待更多云服务平台能够借鉴案例,不断完善服务稳定性及应急响应能力,为全球用户打造更为坚实可靠的互联网基础设施保障。综合来看,Cloudflare R2上的429错误激增是一场突发但受控的技术挑战,展现了互联网基础设施在高速发展中不可避免的压力测试。

通过技术和管理的协同创新,云服务生态正在不断迈向更高的稳定性和智能化水平。用户应以此次事件为契机,增强自身技术储备和风险管理意识,合理规划云资源使用,积极参与到云生态的共建共享中,共同推动行业健康有序发展。未来,随着云计算持续深入人类生活的各个层面,只有不断提升技术韧性和服务质量,才能真正满足日益增长的数据处理需求,助力数字经济腾飞。Cloudflare R2及类似产品的稳定运行不仅是技术问题,更关乎互联网的未来发展方向和用户体验品质。 。