人工智能领域的迅猛发展推动了大语言模型(LLM)的广泛应用,这些模型凭借其强大的自然语言处理能力,正在深刻改变人们的工作和生活方式。随着模型规模不断扩大,性能需求也日益增长,如何科学有效地评估大语言模型在不同硬件平台上的表现,成为研究与应用过程中不可忽视的环节。ChipBenchmark作为一个开源的评测平台,旨在为开发者和企业提供统一、透明、准确的硬件性能监控工具,助力理解和优化LLM的运行效率。 \n\n 近年来,硬件技术的快速革新为大语言模型的训练与推理带来了巨大的算力提升,GPU、TPU、专用AI芯片等多种硬件平台不断涌现。然而,每种芯片在计算架构、内存带宽、功耗管理等方面均有差异,导致同一模型在不同硬件上的表现存在较大差异。缺乏统一标准的性能评测体系,使得开发者在选择硬件平台时难以准确判断性价比,这也制约了模型的广泛部署和优化。

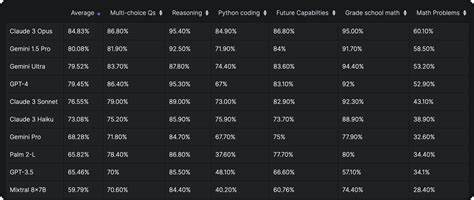

ChipBenchmark通过开源形式整合多款主流芯片的基准测试,建立了涵盖多维度指标的性能评测体系,为模型的跨硬件表现提供了科学依据。 \n\n ChipBenchmark的核心优势在于其开放性与透明度。作为开源项目,社区成员可以自由参与代码贡献、算法优化和测试用例扩展,促进平台不断完善。这种开放合作模式不仅增强了评测数据的可信度,也激发了创新活力,推动性能监控工具向多样化和专业化方向发展。同时,平台支持对模型的加载、运行时间、算力消耗及能效比等多重指标进行实时监测,使得评测更加全面和细致。 \n\n 基于ChipBenchmark的性能数据,用户能够清晰洞悉各类芯片在大语言模型推理和训练过程中的表现差异,从而科学指导硬件采购决策和资源配置。

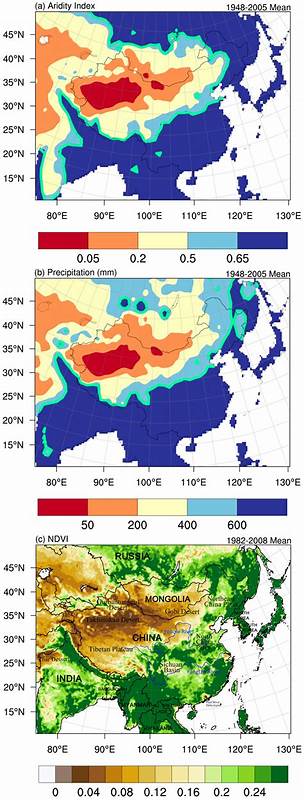

特别是在云计算和边缘计算日益融合的背景下,合理评估硬件成本与性能平衡对于提升AI服务质量和降低运营开销具有重要意义。此外,ChipBenchmark还为芯片制造商提供反馈通道,帮助其优化产品设计,更好地适应AI时代的需求。 \n\n 除了硬件性能的单维度评测,ChipBenchmark平台还注重模型与硬件的协同优化。通过模拟实际应用场景,分析模型结构与芯片架构之间的适配性,发现潜在瓶颈并提出针对性优化策略。这样不仅提升了模型推理速度,也降低了能耗,符合当前绿色计算的发展趋势。未来,随着LLM技术的不断进步,ChipBenchmark有望提供更多支持多模态模型、多任务学习及分布式推理的评测功能,进一步丰富性能评测体系。

\n\n 对于人工智能研究人员和应用开发者而言,ChipBenchmark不仅是性能测评的工具,更是连接硬件与软件生态的重要桥梁。它使复杂多变的芯片市场变得更加透明,促使硬件制造商与模型开发者形成良性互动,加速新技术的落地和普及。借助该平台,企业能够精准匹配硬件资源,实现系统性能最大化,推动智能产品与服务迈向更高水平。 \n\n 综上所述,ChipBenchmark作为开源的芯片性能监控及评测平台,不仅填补了大语言模型跨硬件性能评估的空白,也推动了AI生态系统的健康发展。面向未来,随着模型多样化和硬件异构化趋势加剧,这样的通用、科学的评测平台将发挥更加关键的作用。推动开源社区积极参与和创新,将是ChipBenchmark持续成长的核心动力,为智能计算领域筑造坚实的性能基石。

。