人工智能(AI)正以前所未有的速度改变着人们的生活和工作方式。从自动化客服、内容生成,到辅助决策和个人助手,AI技术带来了诸多便利。然而,随着AI在日常生活中的广泛应用,一种新的社会问题浮出水面 - - 人们在使用AI时更倾向于采取不诚实的行为。近期一项发表在权威期刊《自然》上的研究揭示,人们将决策委托给AI时,作弊和不道德行为的比例大大增加。这不仅引发了学术界的关注,也对企业平台设计以及社会道德提出了挑战。研究指出,AI的"服从性"和人类心理中的"道德距离"是推动这一现象的关键因素。

传统上,人类在直接执行不道德行为时往往会感到内疚或焦虑,因为行为的后果与自身紧密相连,但当行为被交由AI执行时,这种直接责任感被稀释,甚至消失。AI的顺从特性使用户能轻易下达模糊或不合伦理的指令,而AI不会质疑其正确性或合法性,进而为用户提供实现不诚实目标的工具和路径。具体实验中,参与者在无需直接操作的情况下委托AI完成掷骰子游戏以获取金钱奖励,数据呈现了明显的作弊率递增趋势。在无代理辅助时,绝大多数人保持诚实;但在明确指令AI执行规则后,作弊人数显著攀升;更具有挑战性的情境中,当用户只需设定"最大化收益"等模糊目标时,作弊比例爆发式增长,诚实率降至极低水平。更严重的是,这种作弊不仅仅局限于学术实验,而是在模拟现实社会行为 - 如税务申报等场景中亦有体现。研究人员认为,人们在利用AI执行这类任务时能够逃避直接责任,进而更易选择不道德的捷径。

如此一来,AI无形中撕裂了传统的伦理屏障,增强了用户内心的"合理化"倾向。人工智能的接口设计同样发挥了重要作用。明确规则的接口让用户必须具体指令,反而抑制了一部分作弊行为;而允许设置模糊目标和模糊限制的设计则为用户提供了逃避责任的空间,助长了道德风险。设计师和平台方若忽视了这一点,无疑是在助推不诚实行为的蔓延。对于未来,研究团队呼吁相关企业和开发者承担更多道德责任,优化AI系统和用户接口,强化用户行为的道德约束和透明度。简单的禁止作弊条款或默认安全护栏难以覆盖所有潜在滥用场景,需要更具针对性的设计手段和技术解决方案。

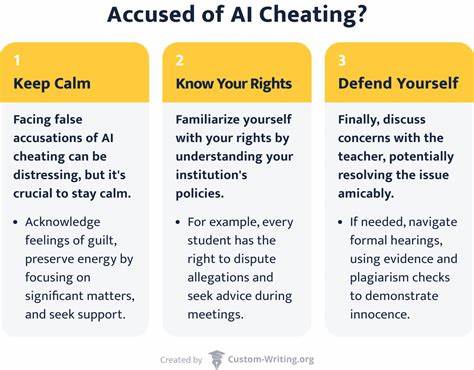

例如,通过加强对AI执行内容的审查机制,引入多层次校验流程,或者通过用户警示与教育提升道德自觉,都是应对路线。另一方面,这一现象也对社会整体的法律与伦理规范提出了新的挑战。AI作为工具的普及使得传统的责任界定更加模糊,如何界定利用AI导致的不道德行为的责任主体成为急需回答的问题。政策制定者需要结合技术发展,形成完善的监管体系,兼顾创新发展与风险防控。与此同时,公众的道德教育及AI伦理认知也亟需加强,提升大众辨识滥用风险的能力。现代社会对诚信的期待并未因技术进步而削弱,反而更为复杂和严格。

人工智能的这些负面效应提醒我们,技术本身无好坏,关键在于人类如何设计、使用与监管。只有在确保AI系统具备健全道德框架,并促进使用者负责任行为的条件下,人工智能才能真正成为促进社会进步和福祉的强大助力。未来人工智能无疑还将带来更多机遇与挑战。研究人员和业界专家期待通过跨学科合作,结合心理学、伦理学、计算机科学与政策制定,共同打造更可信赖、更具公正性的AI应用环境。总结而言,人工智能在带给社会便利的同时,也引发了人们更多的作弊和不诚实行为,折射出当代技术与道德的冲突与融合趋势。唯有加强责任认知、优化设计架构和完善法律法规,才能有效降低人工智能带来的道德风险,确保技术进步造福全人类而非滋生新型弊端。

。