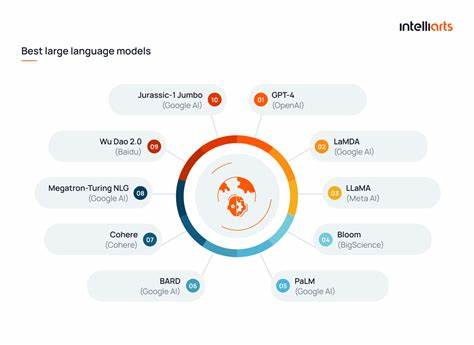

人类的视觉认知系统天生具备识别模式和意义的能力,尤其是对人脸的敏感识别。这种能力在进化过程中被强化,因为快速识别人脸有助于促进社会互动和生存。然而这种强大的模式识别能力也导致了错视现象(Pareidolia),即人们看到本不存在的人脸或形状。这种错觉广泛存在于自然界中,例如云彩、树木纹理甚至墙面裂缝中,都可能被误认为是某种具体形象。近年来,这种类比逐渐被引入人工智能领域尤其是大型语言模型(LLM)的表现中,试图解释AI如何在语言生成与理解任务中出现“虚假认知”或错误解读。大型语言模型是一类基于深度学习的自然语言处理工具,能够生成文章、回答问题甚至创作诗歌和代码。

它们通过分析大量文本数据,学习词语间的统计关联,从而预测下一个最可能出现的词语。尽管表现出令人惊叹的语言能力,这些模型依然存在本质上的局限——它们不具备真正的理解能力。简单来说,LLM无法“理解”语言的含义,只是根据概率做出响应。换句话说,语言模型的“认知”方式和人类本质不同,其结果带有明显的统计学痕迹。这里便出现了与人类错视现象高度相似的一个AI领域的问题,即“语言错视现象”。该现象指的是大型语言模型倾向于生成语法正确、结构合理但语义上荒谬或错误的句子,仿佛它“看到”了文本中的某种合理含义,但实质上是误认了无意义组合。

很多研究者和使用者将此现象视为AI生成文本的一个重要隐患,因其可能误导用户导致错误信息传播。著名的科技博主泰伦斯·伊顿(Terence Eden)在其博客中形象地阐述了这种现象。他指出人类易于在云朵中看到面孔,而计算机视觉同样会犯类似错误,误把无生命物体当作人脸识别。这体现了机器学习模型的错误分类能力。当他使用人工智能工具对照片进行人脸识别时,模型意外地识别出不存在的人脸,证明机器也会产生错视现象。但进而他提出,大型语言模型尽管不是直接处理视觉信息,但在文本领域同样存在类似的“语义错视”,会输出文法通顺但内容荒诞的答案。

就如谷歌旗下的Gemini语言模型,泰伦斯举例说明它在回答一个简单问题时产生了严重错误——比如计算“teamwork”中有多少个字母“i”,机器错误地受到网络流行误解和双关语的影响,给出了荒谬的回答。这反映出大型语言模型在面对含有讽刺、双关或幽默的文本时无法正确理解其语义内涵,只能根据统计权重来“猜测”,导致逻辑和事实上的错误。语言错视不仅是模型自身的局限,也暴露了当前人工智能研发和应用的挑战。开发者和用户需理解即使高级模型能力强大,错误和偏差仍无法完全避免。AI表现出的“认知错觉”提醒我们将其视为辅助工具而非智能实体,应用时必须有人类监督和批判性思考。此外,语言错视现象引发了更深层次的哲学和技术思考。

人类理解语言基于语境、常识和抽象思维,而大多数大型语言模型依赖庞大数据的统计规律,而缺乏认知和经验。未来人工智能的突破或许需要引入更多结构化知识和推理机制,以减少语言错视带来的风险和误导。社会各界也应关注AI错视现象带来的伦理与安全隐患。在错误信息泛滥的环境中,用户面对AI生成内容时易产生过度信任,特别是当模型生成流畅专业的文本时,更难分辨真假。这对新闻传播、医学辅助、法律咨询等关键领域构成威胁。进一步提升模型透明度和可解释性,增强用户识别能力,构建多层次审查机制是亟需解决的问题。

大型语言模型和错视现象的关系揭示了人工智能认知的深刻本质。正如人脑的感知存在偏差和误判,机器学习与自然语言处理系统也不可避免地表现出类似错觉。认识和应对这种错视,有助于推动技术进步和理性应用,避免陷入对AI能力的过度迷信。未来的人工智能发展或许将融合神经网络、符号推理及知识图谱等多种技术手段,从根本上改善语言模型“理解”能力,减少错视错误,带来更可靠可信的智能体验。总而言之,错视现象不仅是人类感知的一个有趣现象,也是大型语言模型性能评价中的重要参考。拥抱其带来的启示,厘清人机认知异同,才能更好地驾驭AI技术,为社会带来积极变革。

与此同时,用户自身也应提高对AI输出的鉴别意识,在享受智能带来的便利时,保持谨慎与批判,以构筑健康可持续的人工智能生态。