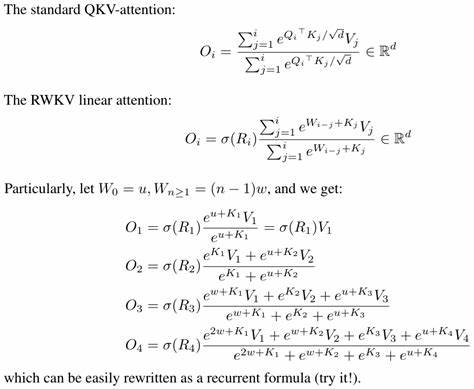

随着人工智能领域的迅速发展,模型架构和计算效率的不断优化成为各大研究机构和企业竞相追逐的目标。Flash Linear Attention作为近年来备受关注的高效注意力机制技术,其在提升模型运行速度和降低计算资源消耗方面表现卓越。然而,近期Flash Linear Attention宣布不再维护对RWKV系列模型的支持,这一决定不仅引发行业广泛关注,也对相关开发者和研究者产生了深远影响。 Flash Linear Attention的核心优势在于利用线性化的注意力机制,突破了传统自注意力机制在计算复杂度上的瓶颈,从而大幅提升序列模型尤其是在长序列处理中的性能和效率。RWKV系列模型作为一种融合了递归神经网络和变换器优势的新型架构,一直以来依赖于高效的注意力机制来实现优异的性能表现。Flash Linear Attention曾是RWKV模型计算优化的重要工具之一,为其实现低延迟推理和训练优化提供了有力支持。

然而,Flash Linear Attention停止维护RWKV系列的支持,表面上看似技术细节的调整,实则反映了底层架构适配和持续优化的复杂性。维护一个跨模型架构的框架,需要不断跟进各模型的细微更新,同时兼顾兼容性和性能提升,投入的人力和资源显著。因此,在权衡成本与收益后,Flash Linear Attention团队选择了缩减支持范围,专注于其核心优势领域,这为RWKV系列用户带来了新的挑战。 这一调整意味着依赖Flash Linear Attention进行优化的RWKV模型用户,在后续开发和部署中可能面临若干技术障碍。首先,模型运行效率可能受到影响,尤其是在大规模部署和低延迟场景下,缺少高效的注意力计算支持将降低整体吞吐量。其次,开发者需要寻找替代的加速方案或者转向其他兼容性更好的注意力机制实现,增加了开发成本和时间。

在这一背景下,社区和开发者纷纷开始探索替代方案。多种基于稀疏注意力、局部窗口注意力以及重参数化技术的创新尝试不断涌现,旨在弥补Flash Linear Attention停更带来的性能缺口。同时,开源社区对于RWKV系列的维护和优化也加大了投入,力求提升模型本身对多样化注意力机制的适配能力。 此外,这一变动对人工智能产业链也产生了不可忽视的影响。众多依赖RWKV模型进行自然语言处理、语音识别、时间序列预测等应用的企业,需要重新评估其技术栈的稳定性和可持续性。当下,关注模型架构的灵活性和跨平台支持能力成为重要的战略方向,鼓励更多基于模块化设计和微服务架构的创新,提升系统整体的鲁棒性和扩展性。

从长远来看,Flash Linear Attention停止对RWKV系列的支持也许是推动技术生态多样化发展的催化剂。面对不断演进的模型需求,单一的优化技术难以满足所有模型架构的需要,多种注意力机制的并行发展势必带来更丰富的选择空间。开发者应加深对于注意力计算原理和模型架构特点的理解,灵活采用适合自己项目的最佳方案,避免过度依赖某一技术路径。 综合来看,虽然Flash Linear Attention停止维护RWKV系列支持带来了短期内的不便和挑战,但也为整个AI模型优化领域注入了新的思考动力。未来,围绕高效注意力机制的研究仍将持续深入,更多创新技术和优化策略有望涌现。对于关注模型性能和资源效率的开发者而言,保持技术敏感性和灵活调整策略,将是应对这一变化的关键所在。

面对这一技术变革,积极参与和贡献开源社区,加强与同行的技术交流,将有助于加快替代方案的研发和推广。同时,企业在技术选型时,也应综合考虑生态支持、技术成熟度以及与自身业务需求的契合度,确保技术演进与业务发展同步推进。这样,才能在AI技术快速迭代的浪潮中稳步前行,抓住更多创新机遇,推动智能应用迈向更加高效和智能的未来。