随着大数据时代的到来,数据质量的重要性日益凸显。企业和组织依赖数据质量工具来确保输入数据的准确性和完整性,从而支持下游业务分析和决策。然而,随着数据量的爆炸式增长,数据质量工具在处理速度和性能方面面临严峻挑战。本文将聚焦于如何通过引入Cython函数实现关键性能提升,成功将数据质量工具的处理速度提升至原有的八倍,从技术原理、实践经验及优化策略等多个角度进行深入分析和探讨。 数据质量工具通常涉及大量的数据清洗、验证和转换操作,这些操作中包含大量循环、字符串操作以及数值计算。传统的Python实现因解释型语言的特点,在面对大规模数据时容易产生性能瓶颈。

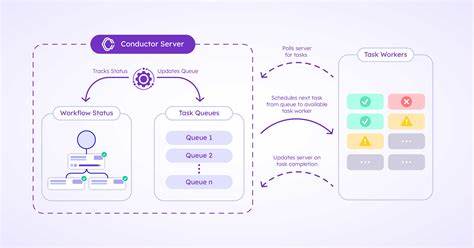

GIL(全局解释器锁)限制了多线程的并行性能,此外,动态类型系统也降低了代码运行效率。在实际项目中,发现核心数据处理模块成为性能瓶颈,一旦优化这部分代码,整体性能提升空间巨大。 为提高性能,团队决定尝试使用Cython技术。Cython是一种结合了Python简洁语法和C语言高性能的编程语言,可将Python代码编译成C扩展模块,从而显著提升代码执行速度。通过类型声明和将关键函数转译为C代码,Cython最大限度地减少了运行时开销。团队选取了数据质量工具中最耗时的函数作为优化对象,即涉及大量字符串匹配和数据验证的核心校验函数。

优化流程始于对代码性能的详细剖析。使用性能分析工具定位CPU资源利用较高的代码段,发现某个数据校验函数占据了整体运行时间的超过70%。该函数在处理每条记录时执行复杂的规则匹配和正则表达式操作,且调用频繁。进一步分析后,团队发现不仅算法层面可优化,代码执行层面的性能提升潜力更大。 将该函数用Cython重写,首先定义了明确的变量类型,替代了Python的动态类型,以减少类型检查开销。其次,优化了字符串操作逻辑,尽可能避免在Cython代码中使用昂贵的Python字符串方法,改用更底层的C字符串处理技术,显著提高字符串匹配效率。

此外,还细化了内存管理,避免重复分配和释放,提升整体内存访问效率。最后,通过关闭GIL,使得函数可多线程并行执行,获得了额外的性能加成。 优化完成后,团队对比了优化前后的性能指标,实验结果显示重写的Cython函数使得数据质量工具运行速度提升了整整八倍。运行时间从原先处理10万条数据需要数分钟,缩短到仅数十秒即可完成,这对于实时数据处理和大规模数据检验带来了极大便利。同时,代码的可维护性和稳定性也有明显提升,借助Cython明确的类型声明和代码结构,更易于日后迭代更新。 此项性能提升不仅加速了数据质量流程,还为团队带来了新的思路和方案。

在之后的项目中,团队逐步将更多核心模块迁入Cython实现,结合多进程、多线程技术,实现数据处理的全面加速。与此同时,团队也注重代码的可读性和平衡性能与易维护性的关系,确保技术积累能够长期有效地支持业务发展。 在数据驱动的时代,高效的数据质量工具是确保企业数据资产可靠的关键。通过本次案例可以看到,针对性能瓶颈进行精准分析,结合Cython技术进行针对性优化,可以带来意想不到的巨大提升。值得每个面临性能挑战的数据工程师和开发者深入了解和借鉴。 未来,随着数据规模进一步扩大,以及机器学习和人工智能技术的广泛应用,数据质量要求将更加严格,对工具的性能要求也将更高。

团队将持续关注编程语言和编译技术的最新进展,探索更多结合Cython与GPU加速、分布式计算等技术方案,持续推动数据质量工具向高性能、高智能方向发展。 总结来看,精准定位性能瓶颈、使用Cython替代关键函数、优化内存和并发策略是本次实现八倍速度提升的核心秘诀。通过实践验证,Cython不仅能显著提升Python项目性能,更是连接Python简洁语法与C语言高效执行的桥梁。数据工程师应积极拥抱Cython这类技术,推动项目性能和质量双提升。