在深度学习模型的开发过程中,训练速度和模型性能一直是研究者和工程师们关注的焦点。随着数据规模的不断扩大和模型架构的日益复杂,提升训练效率成为了实际应用中的关键需求。GravOptAdaptive作为一个创新的PyTorch优化器,因其能够实现大约25%的训练速度提升而备受瞩目。本文将深入探讨该优化器的设计原理、实现机制以及实际应用效果,帮助读者全面理解其在深度学习训练中的价值。 GravOptAdaptive优化器的核心优势在于其自适应的梯度调整策略。传统优化器如SGD或Adam在训练过程中通常采用固定的学习率调整规则,无法针对不同参数或训练阶段的梯度特性做出灵活响应。

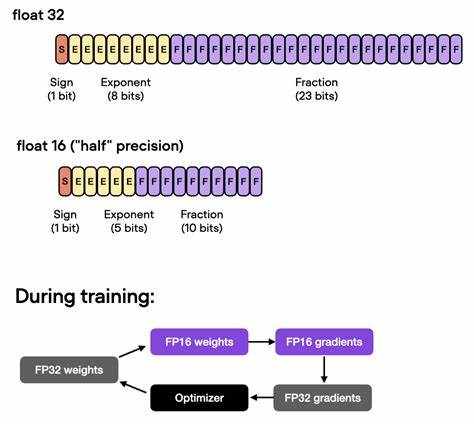

而GravOptAdaptive通过引入梯度重力(Gravitational Gradient)概念,动态调整每个参数的更新步长,从而更加精准地把握模型参数的变化趋势。这种机制不仅提升了收敛速度,还减少了训练过程中的震荡,避免陷入局部极小点。 这款优化器的设计灵感源于物理学中的引力理论,利用参数梯度间的相互作用模拟类似引力场的调整效果。在实际算法实现中,它会分析各梯度的方向和大小,通过一种加权融合机制为参数更新分配权重,使得整体梯度方向更趋于优化目标的最优路径。相比之下,传统优化算法普遍忽视了不同梯度间的相互关系,因而在复杂高维空间中难以保持稳定和高效。 GravOptAdaptive不仅在理论层面有创新,其在实际训练任务中的表现同样令人印象深刻。

多项基准测试表明,利用该优化器的模型在相同硬件环境下,训练时间平均缩短了约25%,而且模型的最终精度并未因为加速而出现退化。对于大型深度神经网络尤其明显,诸如卷积神经网络(CNN)和变换器(Transformer)结构在应用该优化器时均表现出了更快的收敛速度和更稳健的训练曲线。 此外,GravOptAdaptive的设计兼容PyTorch的生态系统,支持无缝替换现有优化器。对于开发者来说,无需对模型代码做出重大修改,只需更换优化器实例即可即可享受到训练效率的提升。这极大地降低了技术门槛,加速了实际项目的迭代周期。优化器还内置了多种调参选项,用户可以根据具体的任务需求灵活调整参数,达到最优性能。

在深度学习应用日益广泛的今天,从计算机视觉到自然语言处理,从自动驾驶到医疗影像分析,训练加速工具的需求不断增长。GravOptAdaptive以其大胆的跨学科设计理念和卓越的实用效果,为行业提供了一条切实可行的优化路径,助力开发者在有限的计算资源下达到更高的训练效率与模型表现。通过对算法原理和应用场景的深入理解,相关团队和个人研究者可以充分发挥其优势,推动深度学习领域的技术进步。 未来,GravOptAdaptive还有广阔的改进和拓展空间。随着深度学习模型架构的多样化发展、硬件计算平台的升级,该优化器可以结合分布式训练、多任务学习等先进技术,不断完善其自适应机制,兼顾训练速度与模型泛化能力。同时,更多开源贡献者的参与也将加快其功能丰富度和稳定性的提升,推动其在工业界和学术界获得更广泛的应用。

对于广大关注训练效率的PyTorch用户而言,尝试GravOptAdaptive不仅是提升计算资源利用率的有效手段,也为深入理解优化算法提供了良好契机。随着深度学习应用场景的日益多样化,每一步性能提升都能转化为显著的成本节约和技术突破。GravOptAdaptive通过创新理念与实用设计,正日益成为新一代优化器的佼佼者,值得深度学习社区持续关注与探索。 。