近年来,人工智能技术在全球范围内飞速发展,深刻影响着各行各业的运作方式和人们的生活习惯。与此同时,随着AI模型的广泛应用,其潜在的安全隐患与漏洞也逐渐引起了安全研究者和公众的广泛关注。在这样的大环境下,一名年仅14岁的越南青少年研究员成功发现并报告了一项重大AI系统漏洞,然而却遭遇了令人关注的"报告被拒绝,漏洞被修复却无任何致谢"的经历。此事件不仅折射出当今人工智能安全生态系统中的种种挑战,也引发了学界和业界对于漏洞处理、公平回馈机制和新兴研究者激励方式的深刻讨论。该事件引起的共鸣和质疑,值得我们认真审视当下AI发展的技术与伦理。多维度分析此事,有助于推动形成更加专业、公正的AI安全生态环境。

作为一名青少年安全研究员的自述和经历细节讲述,为整个行业揭示了许多不为人知的现实,这段经历既展现了年轻一代对技术的热忱和专业度,也呈现了当前AI技术供应商在处理安全反馈时存在的不足。年仅14岁的研究员Anh_khoa在今年七月发现了人工智能模型存在的系统提示泄露漏洞,按照安全负责任披露的原则,他通过该AI系统的官方漏洞奖励计划提交了完整的漏洞信息。然而,令他意想不到的是,官方的回应消息仅是"该问题超出漏洞奖励计划的范围,只是一个AI相关问题",明确拒绝了漏洞报告。此类处理方式令这位年轻研究者深感困惑和失望,毕竟系统提示被外泄的风险无疑属于安全问题范畴,其潜在影响不可忽视。更加令人诧异的是,几周后他再次核查时发现,该漏洞已被悄悄修复,但官方依旧没有对他的贡献给予任何认可或者感谢,也未支付相关奖励。此举激发了整个安全社区对于漏洞判断标准和奖励机制的严肃反思。

为何同一问题,一方面宣称不属于漏洞范围,另一方面却主动修复呢?这样的矛盾立场令外界不禁质疑官方系统的透明度和公正性。面对此种尴尬境地,安全专家指出,漏洞奖励计划通常会对奖金范畴设定严格限定,例如某些AI生成的"误判"或"幻觉"被认定为模型自身的问题,而不被视为系统漏洞,因此被列为"非支付对象"。然而对于真正涉及系统流程安全、数据泄露风险的漏洞,通常应予以重视。如何界定人工智能中的"漏洞"与"设计缺陷"是目前行业内面对的核心难题之一。近年来,随着AI生成对抗样本(adversarial examples)、模型信息泄露、安全提示绕过等风险层出不穷,漏洞奖励计划面临着前所未有的挑战。传统软件系统中漏洞的明确定义和分类标准难以完全适用于由大规模神经网络驱动的AI系统。

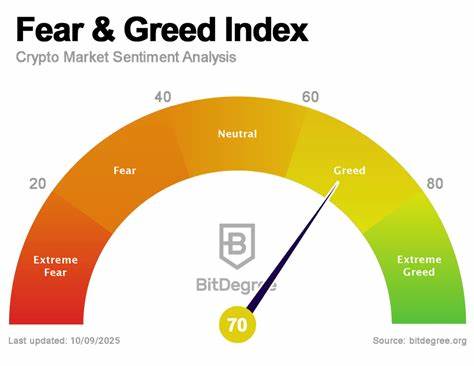

安全从业人员不断尝试适用新策略,包括引入AI专属漏洞类别、与模型训练数据安全相关的考量、甚至对"幻觉"行为的动态检测。然而,在实际操作中,企业和安全社区对漏洞信息的筛选和管理仍处在摸索阶段,导致不少有效报告可能被误判甚至忽视。此次越南青少年研究员的遭遇,在一定程度上是行业适应转型期的缩影。另一方面,企业修复漏洞却不给予信用的问题,在安全报告社区中历来备受争议。研究人员尤其是初级和业余爱好者的贡献,往往被大型科技企业忽视甚至压制,抑制了广大安全爱好者的积极性和热情。漏洞奖励是推动安全生态健康发展的重要引擎,合理的认可和激励机制能够促使更多人参与到人工智能安全体系的完善过程中。

如何平衡商业利益、安全责任和研究者权益,是现今AI厂商亟需解决的关键议题。除技术层面的讨论外,这起事件在媒介与公众层面也引发了广泛关注,反映出社会对青少年科技天赋和贡献的转变态度。越来越多年轻技术爱好者开始投身于安全研究、软件开发、AI算法创新领域,他们的视角新颖,探索更具创新性。然而权威机构尚未建立有效支持体系,导致众多青少年研究者要面对"被拒绝"、"无回馈"的困境。业界呼吁设立更加包容、多元的激励途径,确保新生代研究员能够得到充分的认可和鼓励。展望未来,人工智能技术的不断革新必然伴随着安全威胁的复杂化。

构建完善的安全反馈渠道、科学公正的漏洞奖励体系,以及尊重每一位研究者的劳动成果,将成为保障AI生态持续健康发展的核心要素。国际合作、行业标准制定和公众监督不可或缺,而年轻一代研究员的积极参与是推动行业进步的重要力量。只有当每一个发现都被认真对待,每一份贡献都被真诚感谢,整个人工智能行业才能向更安全、透明、负责任的方向迈进。回顾这次发生在越南青少年研究员身上的事件,我们不仅看到一个技术漏洞被发现和修复的过程,更应看到人性化管理、尊重创新的价值所在。让我们期待未来,在安全和创新的双重驱动下,人工智能能够真正造福人类社会,迎接更加光明的数字时代。 。