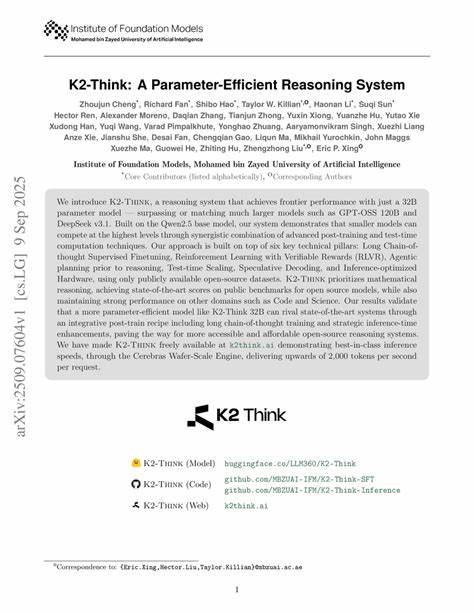

随着人工智能技术的飞速发展,大型语言模型因其强大的自然语言处理能力和推理能力而备受瞩目。然而,庞大的参数规模带来了高昂的计算成本和资源消耗,这在一定程度上限制了其广泛应用。面对这一挑战,K2-Think作为一种参数高效的推理系统应运而生,凭借32亿参数规模的模型,实现了与当前最先进的超大型模型相媲美的性能。这一突破性成果不仅彰显了技术进步的力量,更为开源人工智能推理注入了新的活力。K2-Think基于Qwen2.5基础模型,通过整合多项后训练和推理时间的计算技术,开创了参数高效推理的新范式。其核心技术涵盖长链条思维监督微调、可验证奖励的强化学习、推理前的主动规划、测试时的动态扩展、猜测式解码以及硬件优化推理策略。

通过这些技术的融合应用,K2-Think不仅提升了推理效率,还显著增强了模型的推理深度和准确性。长链条思维监督微调作为K2-Think的首个关键技术支柱,使模型能够在训练阶段模拟复杂的逻辑推理过程,从而有效捕获多步推理中的关键信息。这种方法帮助模型构建更为合理和连贯的推理路径,提升了数学推理等复杂任务上的表现。与此同时,强化学习与可验证奖励机制的结合,则进一步保障了推理结果的真实性和可验证性,为系统输出答案的可靠性提供了保障。主动规划策略则赋予模型在推理前对目标的清晰规划能力,通过合理预设推理步骤和方向,确保推理过程更加高效和有条理。测试时动态扩展技术则通过自适应调整推理规模和深度,使得模型在不同复杂度任务中都能保持最佳性能。

猜测式解码通过提前预测可能答案,加速推理速度,实现了高效的计算资源利用。此外,K2-Think在硬件层面采用了优化的推理硬件设施,如Cerebras Wafer-Scale Engine,大幅提升了推理速度,单次请求的处理速度超过每秒2000个Token,显著改善了用户体验和应用效率。这些技术的协同作用,使K2-Think在数学推理、代码理解和科学计算等多个领域表现卓越。特别是在公开的数学推理基准测试中,K2-Think以高分成绩彰显其领先地位,充分证明了其参数经济性和性能强大的结合优势。相比起市面上1200亿参数规模的GPT-OSS系列模型及DeepSeek v3.1,K2-Think凭借精巧设计和技术创新实现了性能的匹敌甚至超越,彰显了小型模型在推理能力上的巨大潜力。值得关注的是,K2-Think完全采用公开的开源数据训练,且整体系统对开发者和研究者免费开放。

这不仅降低了入门门槛,也促进了人工智能社区的合作与创新,加速了推理技术的落地与普及。未来,随着技术的持续优化和更多应用的拓展,参数高效的推理系统有望在智能问答、自动编程、科学研究辅助等领域扮演更为重要的角色,推动人工智能进入更为智能、高效、经济的新时代。综上所述,K2-Think以其先进的模型结构和多元化的技术集成,成功破解了参数与性能之间的矛盾,为开源推理系统树立了全新的标杆。它不仅展现了小型模型的大潜力,也开启了智能推理技术走向普及化、经济化的新篇章,激励着学术界和工业界共同探索更智慧、更高效的人工智能未来。 。