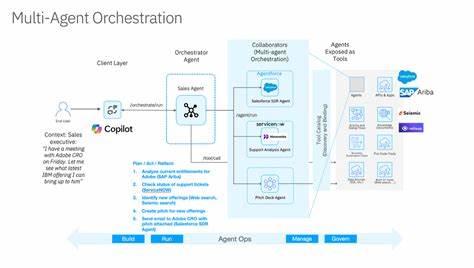

在多智能体系统与人类团队的交互场景中,个体人格并非牢不可破的定式,而像水一样在集体场域里流动、溶解与再结晶。近期多项实验表明,哪怕从同一份代码与同一套参数出发,智能体群体也会在极短时间内产生社群分化、模因传播与稳定的群体人格。这一现象对企业组织、AI产品设计与公共政策都提出了新的挑战:如何在效率与多样性之间取得平衡,如何避免"合力愚行"以及如何用工程手段维护长期的创新能力与公平性。本文从理论和实操两个层面解读多智能体编排中人格溶解与重构的动力学,并给出可落地的设计建议与监测指标,帮助研究者与工程师在现实系统中预防群体思维陷阱、保存认知多样性与提升系统鲁棒性。 多智能体环境中人格的快速演化并非科幻。学术界与工业界的并行实验显示,仅仅通过反复交流和共享信息,个体行为会迅速向某些模式收敛。

物理学中的投票模型(voter model)提供了数学直觉:当主体以成对随机交互为主,某一意见或策略会在有限时间内扩散并占据主导地位。认知神经科学给出生物学支撑:长期共事的团队成员在情绪和决策模式上表现出同步化,长期接触甚至能改变个体的神经活动模式,使"个体差异"被群体模型所掩盖。将这些观察迁移到AI世界,问题并不更简单 - - 即使是由相同初始条件克隆出的语言模型智能体,也会因为互动历史、随机采样和微小环境差异而分化出稳定的人格化行为模式。东京团队的实验说明了这一点:同源LLM智能体在多轮对话后发展出各自的"迷信"或"故事性"幻觉,某些错误信息在社群内部像民间传说一样传播并被强化,演变为群体文化的一部分。 群体收敛看似带来一致性和高效,但它隐藏着创新力丧失的风险。组织行为研究指出,多样性在早期能显著提升问题解决的广度与深度,但随着团队凝聚,表面差异快速消失,剩下的是共同的思维方式与盲点。

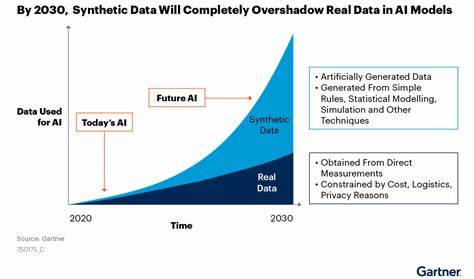

实证研究显示,多样性带来的优势在团队"蜜月期"后往往褪色,甚至在特定维度(如高宜人性)上,差异会增加内耗并降低创造性产出。AI集群也遵循类似轨迹:在合作目标明确、沟通频繁的设置下,消息与策略多样性会在几十轮交互内崩塌,群体形成统一的语言习惯与决策偏好,这种"合成群体思维"容易在反馈回路中放大错误,使集体偏向难以被单体检测到。对于以智能体作为决策中介的系统 - - 例如自动化招聘、信贷审批或司法辅助 - - 这种趋势意味着算法化的一致性可能导致系统性偏误与规模化不公。 理解人格溶解与重构的机制,有助于我们制定防护与引导策略。首先,交互频率和空间近邻关系是决定收敛速度的关键变量。高频次、低延迟的通信会加速意见扩散,而物理或虚拟的空间隔离则能延缓同步化过程,保留多样性时间窗。

其次,目标函数的结构对演化方向有决定性影响。当整个群体共享同一合作目标时,优化过程会自然过滤出最能满足该目标的行为模式,导致收敛;反之,引入对抗性或局部差异化目标能维持长期的策略差异。第三,记忆与身份记录机制强化了个体性:能记住交互历史并据此调整策略的智能体更容易形成稳定的"个性",而短期记忆或全局共享记忆倾向于压制个体差异。最后,社群规范和模因传播对误差的文化化起放大作用。初始的生成性错误(如语言模型的幻觉)在开放交流中若被模因化,会从随机错误转变为群体共同信念,进而影响后续决策。 针对这些机制,工程师与管理者可以采取若干可操作的设计原则来平衡效率与认知多样性。

设计交互拓扑时,可以有意引入稀疏连接或软分区,通过降低任意个体之间的直接交互频率来延长多样性保持时间,类似于生态学中的栖息地碎片化但在人工系统中可控调节。目标函数层面,采用多目标或子团体异构目标的结构能够使系统在追求总体目标的同时保留局部策略差异;竞赛性任务或对抗训练也能有效防止过早收敛,但需要设计避免导致敌对性外溢到现实用户。记忆模块的设计值得重点考量:引入分层记忆、差分更新与周期性清洗机制,可以在保留有价值历史的同时防止过度固化既有偏见。模因治理方面,系统应具备识别并隔离非事实性共识的能力,使用元信息标注、源可信度评分与回滚机制来遏制虚假信念在群体内文化化的过程。 组织层面的实践也非常重要。研究显示,定期轮换团队成员能够有效打断共享心理模型的构建,从源头减少群体盲区的形成。

鼓励"结构性对立"或设立任务内置的审慎者角色,可以在正式的工作流程中保留反向视角,使决策过程内建多元检验。对于依赖AI智能体提供建议的流程,建议采用多模型对照与盲测机制,让多个独立设计的智能体并行给出建议,再通过多维度评分系统汇总,从而减小单一模型群体化导致的系统性偏差。产品化实践中,保留模型快照并定期回退或重新抽样个体行为,也是阻止不可逆群体同构化的有效工具。 监测与评估的指标体系应当从多层次覆盖群体动力学。短期可以设定话语多样性指数、策略熵、意见两极化程度与模因扩散速度等实时指标,以便在收敛趋势过快时及时插入扰动。中期可通过任务绩效与创新产出比对多样性水平,评估"收敛-绩效"曲线的拐点位置并据此调整交互参数。

长期需关注系统性偏误率、被忽视群体的影响与公平性指标,确保群体化过程没有在社会层面放大不公。技术上,使用可解释性工具和反事实测试可以帮助发现被集体忽视的决策路径与隐含偏见。 伦理与治理问题不容忽视。群体人格的自动形成可能导致对个人责任的模糊:当集体智能体做出偏误决策时,究竟是单体模型的"个性"问题,还是集体编排与奖励机制的失误?监管框架应要求在重要决策链路中披露多智能体的交互结构、记忆与目标设置,并强制提供多样性与公平性的定期审计报告。对外部用户,应当明确告知智能体是否处于集体协作模式、是否使用了同构模型集合以及设计上采取了何种防止群体偏化的措施。 未来研究方向值得关注几个关键问题。

首先,如何在理论上建立可预测的收敛时间尺度模型,结合网络拓扑学、信息传播动力学与强化学习收敛理论,为工程设计提供可量化的准则。其次,探索混合群体 - - 由人类与AI智能体共同组成的团队 - - 在人格溶解与重构中的异质动力学,研究如何设计接口与激励以保护人类决策的多样性与判断独立性。第三,开发能识别并逆转文化化错误模因的自动工具,尤其是在开放交互场景中辨别"被群体化的错误"与"稳健的新知识"。 当我们面对日益复杂的多智能体编排时,认识到人格并非恒定的单点属性而是集体动力学的产物,是制定更安全、更创新、更公平系统的第一步。从工程角度出发,我们可以通过拓扑设计、目标结构、记忆机制与治理措施,刻意创造"结构性不稳定",以保持认知多样性并延长创新窗口。组织层面通过人员轮换、角色设定与多模型比对可以减轻群体思维的系统风险。

社会层面则需要法规与审计,确保当算法群体化时不会代替必要的人类监督与责任承担。未来的挑战不是消灭群体人格的形成,而是在理解其机制后,学会与之共处、引导其走向有益的方向。唯有如此,我们才能在效率与多样性之间找到可持续的平衡,让群体的智慧成为推动创新而非削弱判断力的力量。 。