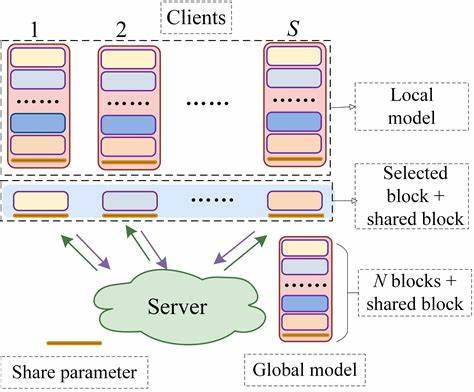

随着人工智能技术的发展,尤其是大型语言模型(Large Language Models, LLMs)的广泛应用,训练这类模型所需的计算资源和成本成了制约众多研究人员和企业的重要瓶颈。传统的大型模型训练往往依赖昂贵的高端GPU集群,如NVIDIA A100,而这对资金有限的中小型团队并不友好。近期,研究者提出了一种基于块坐标下降法(Block Coordinate Descent,简称BCD)的训练框架,配合多项工程优化,实现了在更为低廉的GPU硬件环境下高效训练大型模型的目标。该方法不仅降低了硬件资源需求,还有效提升了硬件利用率,成为对抗训练成本的有力工具。块坐标下降法的核心思想是将模型训练过程中大规模的参数空间分解为多个块,每次仅优化其中一个参数块,在保持整体模型性能的前提下实现内存和计算资源的节省。这种做法适合于分布式环境,尤其是在资源受限的GPU集群上,能够打破传统方法对显存容量的高要求。

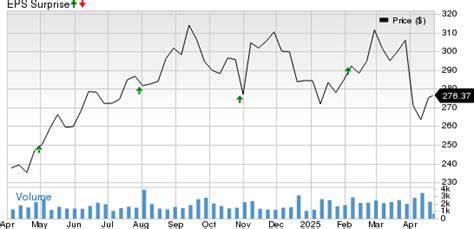

通过合理划分参数并逐步迭代更新,BCD充分利用硬件并行计算优势。以RTX 4090、NVIDIA A100及A800等中高端但价格相对亲民的显卡为基础,采用BCD方法的训练框架能够在成本上降低至传统全参数训练的2.6%到33%,大幅度减少了训练花费。更重要的是,在性能表现方面,BCD法训练出来的模型常常能够匹敌甚至优于传统全参数训练和微调策略,保证了模型的准确性和泛化能力。这使得大型模型的训练不再是大型企业或实验室的专属,中小团队也能凭借合理的方法和硬件组合开展高水平的研究。除了核心算法优化外,工程层面的配套措施也起到了关键作用。合理调度计算资源、优化内存管理以及提高数据传输效率,是保证BCD方法在实际集群环境中发挥作用的重要因素。

此外,参数块的划分策略也对训练效率和最终结果有显著影响,合理划分能够平衡计算负载,降低跨设备通信开销,从而进一步提升整体训练速度。采用该方法的实际案例证明,在相同硬件配置下,7亿参数规模的模型训练成本可以降至常规方法的三分之一甚至更低,而训练时间和最终准确率没有显著降低,真正做到低成本与高性能的兼顾。面对未来大模型的发展和日益增长的模型规模,传统的训练方法在硬件和成本上的局限日益明显。块坐标下降法的提出,为模型训练领域带来了新的思路。它不仅提供了一种适应硬件多样化和分布式环境的解决方案,也推动了大规模模型训练技术向更普惠的方向发展。伴随着算法和硬件技术同步进步,未来的训练架构将更具灵活性、可扩展性以及经济性。

对于希望打造自有大模型但预算有限的团队而言,深入理解和应用基于块坐标下降的训练框架,意味着一种创新突破。结合具体项目需求设计合适的参数分块方案,合理选用硬件配置并配合高效的软件调度优化,有望实现训练成本的极大降低,从而把握更多研发主动权。同时,开放社区和研究者的持续贡献也在不断完善这种方法的适用性和稳定性,推动其在工业界和学术界的广泛应用。综上所述,块坐标下降法凭借其降低显存开销、提升硬件利用率和确保模型性能的优势,成为当前低成本大规模模型训练的关键技术。它不仅打破了硬件资源对模型训练的瓶颈,也为更多创新型人工智能项目搭建了桥梁。未来,随着该方法与更多工具链的融合以及硬件环境的迭代升级,训练大规模模型将变得更加普及和高效。

对任何关注AI发展趋势和实践的研究者与开发者而言,了解并掌握这项技术将极大提升其竞争力和创新能力。