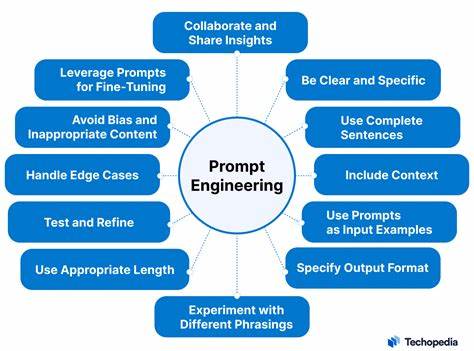

随着人工智能技术的迅速发展,尤其是在自然语言处理领域,提示工程(Prompt Engineering)逐渐成为研究与应用的热点。提示工程是指通过设计和优化输入模型的提示语句,以引导模型生成更准确、更符合预期的输出内容。然而,针对这一技术,有一个常见的质疑——提示工程是否只是在对测试数据进行过拟合?本文将从多个角度剖析这一疑问,探讨提示工程的本质、可能面临的风险以及应对策略。 提示工程的核心在于如何构建和优化提示,使得基于预训练模型的生成结果更加精确和实用。模型本身往往是在大量通用数据上进行预训练,具备较强的通用语言理解能力。而提示工程则像是在这基础上用具体的“指令”或“环境”来引导模型更好地完成特定任务。

比如,设计一个问题引导自然语言生成模型输出有关科学解释的答案,或者让模型以特定文学风格作诗。 有人指出,提示工程过程中往往采用一个特定的评估数据集,通过反复调整提示语,力求在这个数据集上取得更好的效果。然而,这种操作在本质上与机器学习中的过拟合十分相似——对同一套评估数据反复优化,可能会导致提示设计者无意间让模型只适应这套数据的特征,而忽略了在更广泛场景中的泛化能力。换句话说,提示很可能变成“为考试而学”,而非理解和掌握知识本身。 这种担忧有其合理性,尤其是在提示设计缺乏独立测试机制时。如果没有引入新的、未见过的数据集来检验提示效果,就无法判断优化后的提示是否具备真正的泛化能力。

正如经典机器学习中训练与测试数据的分离原则,如果提示调整过程“泄露”了测试数据的信息,就会导致误判模型真实性能。 不过,提示工程与传统机器学习训练存在本质区别。传统训练是对模型参数进行微调,整个模型权重因数据驱动而变化。而提示工程通常不改变模型参数,而是对输入文本进行设计,利用模型已有的语言理解能力。这种“外部”控制方式,其灵活性和局限性都不同于模型微调。 此外,提示工程的目标并非总是为了在一个特定数据集上获得最高精度,而更倾向于增强模型的适应性和交互性。

一个经过精心设计的提示,可以在多种任务和上下文中提供合理回答,而不是笼统地对某个数据集进行记忆。因此,尽管提示优化过程中会面对过拟合风险,但良好的工程实践和严谨的评估方法能够最大程度避免这种情况。 为防止过拟合,提示设计者通常需要引入独立的验证数据集,甚至是完全不同类型的任务或领域进行测试,以确保提示的通用性。一些先进做法还包括随机化提示的某些元素、采用多样性的评估指标,并通过人类反馈来辅助判定提示效果,这些方法有助于缓解单一数据集上的过拟合问题。 从更宽广的视角来看,提示工程的发展与人工智能模型向通用智能迈进密切相关。未来,提示设计不仅仅是精细调整文字,更可能演变为交互式的、动态调整的过程,结合用户反馈和环境变化不断优化。

这样的动态提示系统本身具备更强的适应性,能够超越传统意义上的静态过拟合风险。 与此同时,提示工程领域也在不断探索自动化设计与优化手段,例如借助强化学习、元学习等技术来实现自适应提示生成。这些方法通过更全面的数据覆盖和自动化评估机制,有望有效缓解人工手工调整时可能带来的过拟合风险。同时,自动化手段还能够挖掘出人力难以发现的最优提示结构,为应用场景带来更大价值。 当然,提示工程并非万能,存在的局限不容忽视。有些复杂任务可能需要对模型进行深度微调,提示优化无力解决根本问题。

另外,提示的设计也依赖于设计者的专业知识和理解程度,如何做到高效且科学的提示工程仍是领域内的挑战之一。 总结来说,提示工程虽然面临过拟合的潜在风险,但其本质区别于传统模型训练,具备独特的优势和应用价值。通过引入独立测试集、多元评估指标以及自动化优化手段,能够有效缓解过拟合问题,提升提示的泛化能力。未来,随着模型能力的提升和提示工程技术的成熟,我们有望看到更加智能、灵活且可靠的提示系统,推动人工智能更广泛的应用和发展。