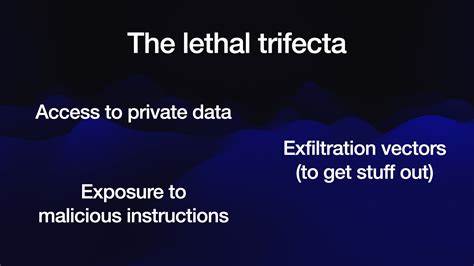

随着人工智能技术的快速发展,基于大语言模型(LLM)的智能代理系统在帮助用户自动化处理任务、提升工作效率方面展现出巨大的潜力。然而,这些系统在带来便利的同时,也伴随着不容忽视的安全隐患。尤其是当人工智能代理系统具备访问私有数据、处理未受信任内容以及与外部系统通信的能力时,存在极高的数据泄露风险,形成了所谓的“致命三重奏”。本文将从安全角度深入探讨智能代理为何面临如此严重的威胁,分析三大关键因素如何交织导致用户数据面临攻击风险,并提出应对措施以帮助用户保护个人隐私和企业机密。访问私有数据是智能代理的基本功能之一,对大多数用户而言,这也是它们存在的初衷——如查看邮件、管理文件、检索数据库内容等。智能代理时刻处理大量的敏感信息,涉及账户密码、财务记录、个人通讯等重要内容。

然而,正是这种访问权限成为攻击者瞄准的核心焦点。未受信任内容的出现极大增加了攻击复杂度。智能代理常常需要读取网页、邮件、文本文件甚至图片内容来执行命令或提供总结分析。如果任意一处内容由攻击者控制,智能代理很可能被“指令注入”——攻击者在内容中嵌入隐藏指令,误导代理执行非预期的操作。由于当前主流的语言模型在处理输入时无法区分指令的来源和可信度,任何内容都会被一视同仁地解读为指令的一部分。最危险的是智能代理具备外部通信的能力,这意味着它们能够通过互联网向外发送请求,包括API调用、图片加载甚至简单链接访问。

攻击者借助这一能力,将智能代理诱导至将私有数据悄悄发送给自己,实现数据的秘密外泄。三者结合,构成了从攻击者视角极具吸引力的攻击路径。攻击者只需投递恶意内容,诱使智能代理读取私有数据,并借助这些工具将数据安全送出,从而完成一次隐蔽且难以防范的数据窃取。近年来,这类攻击的实例频繁出现,影响范围广泛,涵盖微软365 Copilot、GitHub MCP服务器、Google Bard甚至ChatGPT等主流产品。安全社区对此保持高度关注,多数厂商在发现漏洞后迅速通过限制外部通信渠道、强化内容过滤等方式进行紧急修复。尽管如此,在用户自行组合或混合不同工具时,这种风险依然难以根除。

尤其是现有模型上下文协议(Model Context Protocol,简称MCP)的使用,鼓励用户跨平台、多工具协作,极易促成致命三重奏的组合,使得用户沦为安全链条中最薄弱的环节。有人设计了守护机制(guardrails),试图拦截恶意指令,防止数据外泄,但现实情况是,目前尚无任何方案能够做到绝对有效。许多声称可覆盖95%以上攻击的守护措施,在网络安全领域实际上意味着严重的安全隐患。复杂且多变的攻击手法使得攻击者总能找到绕过检测的路径。学术界和业界都致力于寻找更为安全的设计模式和防护系统。例如,研究人员提出了一些设计模式,主张限制AI代理在摄入未受信任输入后执行关键操作的能力,尝试从架构层面根绝指令注入的威胁。

同时,谷歌DeepMind的CaMeL项目在缓解提示注入攻击方面展示了创新思路,但这些研究成果对于普通用户在混合使用不同AI工具中的防护意义依然有限。针对智能代理的这类安全挑战,犯错的代价十分惨重。私有数据一旦泄露,不仅可能导致用户财务损失,甚至引发法律纠纷、商业机密泄露和品牌声誉受损。尤其是在企业级应用中,这意味着极具毁灭性的安全突破,严重威胁信息安全合规要求。用户在选择和使用AI代理工具时,应切实关注安全风险,避免无意中组合出拥有访问私有数据、接收未经审核内容及具备外部发送能力的三重功能。这种风险组合无疑是黑客眼中最理想的攻击目标。

合理规避的办法包括慎重评估所选工具的权限范围,限制外部通信能力,对外部内容加设多层过滤和校验,同时关注厂商发布的安全补丁和漏洞公告。教育和提高用户的安全意识同样重要,因为技术固然关键,但在安全链中最脆弱的环节往往是人。只有用户能完全理解潜在攻击原理,才能主动规避导致数据泄露的致命三重奏。总体来看,智能代理的安全问题不容小觑。私有数据访问、未受信任内容暴露和外部通信渠道构成的致命三重奏带来了前所未有的数据泄漏风险。虽然厂商和研究人员不断探索防护机制,但目前仍无法做到全面防护。

用户需要提高警觉,避免轻易将这三者混合使用,以保障自身数据安全和隐私权益。在AI技术迅猛发展的时代,关注安全不仅关乎个人利益,更是维护数字社会健康发展的关键。只有不断提升安全防护能力,才能真正释放人工智能的价值,拥抱未来智能化生活。