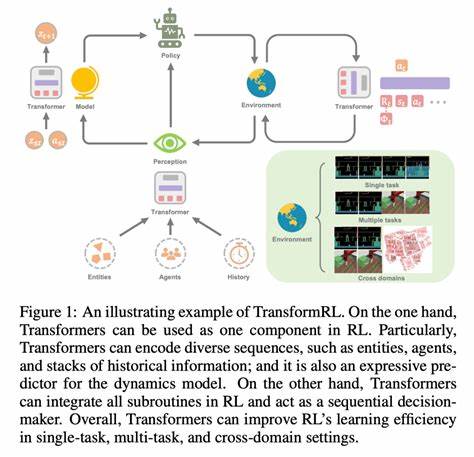

随着人工智能和自然语言处理技术的飞速发展,基于大规模语言模型的强化学习应用日益广泛。强化学习中的日志概率(log-probability)作为模型评估和梯度计算的重要指标,其准确性直接关系到算法的收敛性及最终性能。然而,很多实践者在使用不同的推理引擎与Transformers官方框架进行日志概率计算时,往往会遇到明显的差异甚至不一致性问题。本文将深入剖析引擎与Transformers日志概率差异的内在原因,结合具体的代码实现与实验数据,指导大家如何定位并有效调试这一难题,从而保障强化学习训练的稳定与高效。日志概率是自然语言模型生成过程中输出词语概率的对数值,利用日志概率而非概率本身能够更好地处理数字下溢问题并简化连乘计算。Transformers库中的AutoModelForCausalLM模型采用的是transformer结构,默认通过调用模型的lm_head将隐藏状态映射至词表,计算每一步生成词的概率分布,进而得到对应的日志概率。

而实际运行中,各个推理引擎如vLLM和sglang则基于不同的底层实现和硬件优化,存在着隐式的计算差异和数值稳定性处理策略,导致获得的日志概率数值出现偏差。理解这些差异的根源,是调试的关键。首先,隐式的数值精度及数据类型转换可能引入细微误差。Transformers模型通常支持float32和bfloat16等多种精度模式,不同引擎根据硬件支持会选择不同的数据类型。某些引擎会优先使用bfloat16以提升推理速度,但这会导致少量精度损失,影响最终日志概率计算。其次,模型输出的隐藏状态如何分批计算日志概率也影响结果。

传统Transformers通常采用逐步迭代输出每个时间步的词分布,而在优化的推理引擎中,为节省内存和时间,往往采用隐藏状态整块计算,分段处理,这里涉及内存分配、非阻塞数据复制及设备切换策略,如CUDA设备间切换,也可能引发数值不一致。此外,隐藏层权重对应的lm_head参数使用的位置与数据类型是否精确匹配,是准确复现Transformers日志概率的关键。若权重与隐藏状态未严格对齐,或者存在模块路径差异导致权重加载不完整,也会出现误差。再者,生成策略和采样机制的细微差异也不可忽视。例如,vLLM默认支持多种采样参数如温度(temperature)、top_p等,若与Transformers生成配置不一致,也会导致日志概率上下波动。通过对比实验,数据显示不同引擎间的平均绝对误差(MAE)通常在0.01至0.02区间,均方根误差(RMSE)约为0.03左右,皮尔逊相关系数极高,达0.999以上,显示整体相关度极好,但细节偏差则依赖具体配置。

调试流程应首先保证模型权重与tokenizer完全同步,并优先设定相同的生成参数。使用相同的prompt输入序列后,捕获每一步选中的token及其日志概率。基于官方Transformers的基线得分计算,分块调用线性层和log_softmax函数,再与推理引擎输出进行逐token对比。对出现较大偏差的tokens,检查其Embedding、隐藏状态维度及对应权重准确投影。进一步对引擎源码进行审查,看是否存在数值精度切换、设备内存复制延迟、非阻塞调用抑或OOM回退机制影响计算。使用缩短时间块(time chunk)尝试缓解OOM问题时,也要留意造成数值稳定性差异。

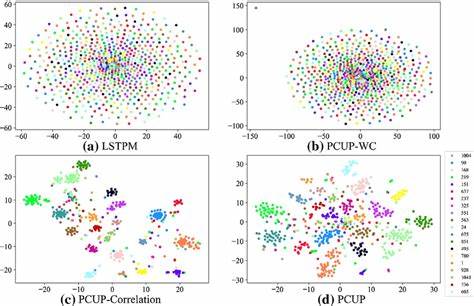

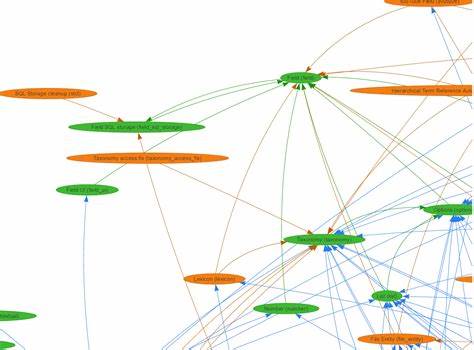

针对vLLM引擎特有的inductor编译配置,虽然提升了速度,但在某些边界条件下可能引入细小的计算抖动,需权衡性能与精度需求。此外,可以利用可视化手段对比两者的log-prob分布,如散点图及热力图,辅助识别误差集中区域。结合Token概率差异趋势曲线,分析生成序列中断点及逐步误差积累过程。调试的最终目的不仅是缩小误差,更是理解这些微小差别背后的原理。比如引擎计算中是否已经考虑padding token的过滤,是否采用相同的上下文截断策略,模型配置的use_cache参数是否被正确关闭,甚至批处理中的顺序处理都会引发微妙变化。理论上,理论推理流程应保持等价,所有差异应归结为实现细节上的折衷和优化。

但在实践中,面向高性能推理的工程设计时常需要在速度和数值稳定性之间做出选择,开发者必须在效果和效率之间找到平衡点。强化学习训练过程中,模型根据日志概率计算奖励和优化方向,若这一环节数据不一致,将在梯度更新中放大问题,导致训练无法稳定收敛,甚至性能倒退。因此,确保推理引擎输出的日志概率与Transformers一致,是提升强化学习算法鲁棒性不可或缺的前提。为此,社区和企业纷纷开源工具和测试代码,如上述compare.py脚本即为对比不同引擎与Transformers日志概率的实用利器。配合大规模数据集及多样化prompt样本,深入分析误差统计指标,帮助研发人员精准调优和排查。未来,随着硬件和算法的不断革新,对日志概率的标准化计算方法和跨引擎兼容设计将成为重点研究方向。

同时,借助更完善的调试框架与日志系统,缩短开发周期,提升模型训练与推理的一致性和可信度也指日可待。总而言之,探究与调试语言模型推理引擎和Transformers日志概率差异,是确保强化学习项目成功的基础。它帮助我们理解隐藏状态、lm_head权重计算、设备间协同处理等核心细节,发掘潜在风险点。通过严谨的实验与代码层面剖析,开发者能够把握每一次推理背后的数学原理与工程实践,用数据说话与问题共舞,推动智能对话、文本生成等领域迈入更高水平。 。