近年来,随着人工智能特别是大型语言模型(LLM)的快速崛起,全球网络内容爬取行为进入了一个前所未有的繁荣期。各种AI企业和技术巨头为了训练更强大、更智能的模型,大规模采集网络上的文本、图片、视频等各种形式的内容。然而,这种几乎不受限制的"网络爬虫自由采集"模式,正带来严重的伦理、法律和商业挑战,促使网络内容使用市场进入新的变革阶段。 长期以来,爬取网络内容的主要目的是为了建立搜索引擎或内容索引服务。典型如谷歌搜索,它通过爬虫扫描网页内容,将信息编制入索引,实现用户查询时的快速响应,这在很大程度上促进了信息的公开与流通。同时,网站运营者也乐于被搜索引擎收录,因为这带来了大量实际访问流量,促进业务和广告的转化。

然而,针对AI训练的数据爬取则完全不同。AI爬虫不仅仅是索引信息,而是无差别复制网站上的文章、新闻、研究成果、音乐和视频等作品,然后将其整合进训练数据中,用于构建对话式智能助手、内容生成和辅助创作工具。这样的行为没有给原始内容持有者带来流量和收入,甚至在某些情况下,AI生成的内容直接竞争影响了原创作品的价值和市场。 由此引发了作者、音乐人、视频制作者、新闻机构和出版商的大规模投诉与诉讼,呼吁AI企业为合理使用支付授权费用。面对这种压力,部分AI技术公司尝试通过与内容平台达成版权授权协议,合规获取训练所需的数据。例如OpenAI与Reddit、Vox Media等内容平台签订了合作协议,以求确保更新内容的合法使用权。

谷歌、亚马逊等公司也通过类似的授权合作,试图规范内容采集行为。 尽管如此,市场上仍有大量未经授权的AI爬虫无孔不入,频繁绕过网站防护,采用伪装成搜索引擎或普通用户的手法大规模抓取数据,甚至一些技术团队通过隐秘爬取来规避封堵手段。网站管理者深感无助,因面对数十亿次的数据请求,不仅带来服务器压力和流量费用,也严重影响了原创内容的安全和版权保护。 有报道泄露了Meta等巨头涉嫌非法爬取的具体网站名单,其中涵盖大量版权受保护的内容,甚至非法录制或盗版视频。这种普遍现象不仅仅困扰某一家企业,而是形成了行业的"默认操作规范",其背后的法律和伦理灰色地带尚未被有效解决。 与此同时,互联网基础设施提供商成为了应对这一危机的关键力量。

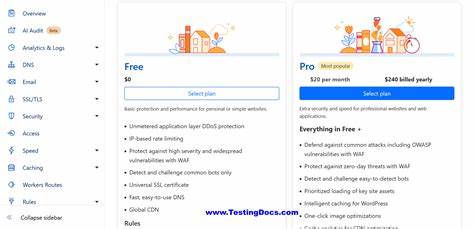

例如知名的Cloudflare通过推出AI爬虫监测与管理工具,帮助网站追踪爬取行为并限制非法访问,甚至计划建立一个内容授权定价市场,让网站能够明确标价授权使用内容。同时,Fastly等同行企业也参与到新的网络内容授权标准的制定中。 由Reddit、Medium、Quora等知名网络平台牵头推出的Really Simply Licensing(RSL)标准则代表了一个里程碑。它类似于早期的RSS订阅标准,创新在于网站可以声明是否允许AI爬虫抓取其内容,明确授权条款、版权归属以及使用费用。理论上,这不仅有助于控制爬虫数量,防止恶意采集,还能逐步形成版权费用收取的生态链条,为创作者带来实实在在的经济回报。 尽管这一体系的实施还面临巨大的挑战,特别是如何让巨型AI企业和无数中小型技术团队共同遵守及支付费用,RSL和类似举措标志着网络爬取自由时代的终结。

随着技术手段提升,更多的网站能够有效阻止未经许可的数据抓取,保护自身权益。这意味着AI企业在"免费"获取数据的路上将遭遇越来越多法律与技术双重障碍。 未来,AI模型的更新训练将不得不寻找更加合规和透明的内容来源,这或促使内容运营者与AI企业建立常态化的内容授权合作机制。AI行业可能逐渐形成付费许可为基础的内容获取模式,从而促进内容生态的可持续发展。同时,版权保护法规和网络治理规则亦将日趋完善,加强对数字内容的保护力度。 值得注意的是,这种趋势不只是技术和法律的胜利,更是内容创造价值回归的象征。

对于网络原创者而言,尽管数字版权保护历经多年斗争,此次人工智能引发的版权热潮,终将带来更切实的利益保障和商业变现机会。这不仅能激励更多优质内容产出,还将有助于打造更健康有序的数码内容市场。 总之,人工智能训练数据的无节制爬取时代正逐渐画上句号。随着法律规范的完善、行业自律的加强和新技术的引入,网络内容的版权管理进入了全新阶段。未来,公众网站将拥有更多话语权,为自己的内容设定使用规则和定价标准。而人工智能企业也将不得不重新调整战略,从"拿来主义"转向更加尊重和保护内容创作者权利的商业模式。

这一变革不仅是互联网技术发展的必然结果,更是数字时代版权体系进化的重要标志。面对类似RSL的标准化尝试和基础设施公司的合作,网站运营者迎来了掌控内容、阻止非法采集的有力工具。同时,这也预示着AI技术未来的创新增长,离不开与内容生态共荣的公平规则与合作精神。在新的网络版权时代,内容创造者、平台和AI企业将携手共建一个更加透明、和谐且可持续发展的数字世界。 。