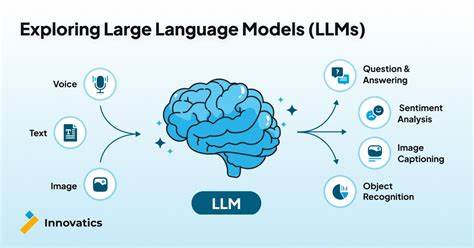

在人工智能快速发展的今天,大型语言模型(LLMs)无疑成为了科技领域的一大突破。尽管它们尚未达到类似人类的通用智能水平,但其在自然语言处理、内容生成及各类智能应用中的表现令人瞩目。与以往的算法相比,LLMs代表了全新的软件开发范式和思维模式。为了更好地理解这些复杂的模型,我们可以从两个不同的角度切入:白盒视角和黑盒视角。所谓白盒视角,是指深入探究模型的内部结构和运作原理,探讨其神经网络架构、训练数据和优化算法等技术细节。然而,鉴于大型语言模型的庞大规模和复杂性,完全解读其内部机制目前仍然极具挑战。

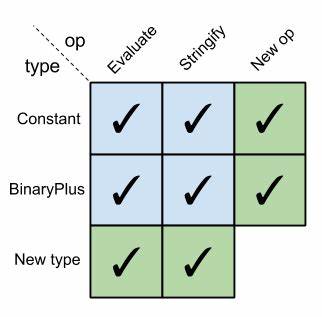

另一种则是黑盒视角,即只关注模型的输入输出关系,将其视为一个整体功能模块,无需了解其内部细节就能有效利用它的能力。将LLMs类比为经典的计算机算法快速排序,可以帮助我们更直观地理解这一点。快速排序作为一种经典、高效的排序算法,其核心流程和实现细节被人们详细理解和掌握。开发者们可以通过调用sort()函数直接对数据进行排序,无需关心排序的具体步骤。在这种意义上,尽管快速排序的代码行数远远少于LLMs庞大的代码和数据体量,但两者本质上都提供了可靠的服务 - - 输入给定的数据,输出符合预期的结果。对于最终用户而言,这种操作模式极具价值。

尽管LLMs的内部运算过程相对不透明,甚至存在偶尔的不确定性和错误,但它们在语言理解、生成与推理方面取得的实用性成果是前所未有的。传统工具难以胜任的复杂任务,因LLMs而变得可行。此外,LLMs为软件开发带来了全新的思考范式。正如人工智能专家安德烈·卡帕西在2017年提出的"软件2.0"概念所言,神经网络和深度学习方法代表了基于数据和训练的编程新模式。这种范式不同于传统明确编码逻辑,而是依赖大规模数据驱动模型自我学习和优化。2020年,研究者格温·布兰温亦提出,将GPT-3视为新的编程范式,促使业界从代码实现的角度转向模型能力的革新视角。

通过将LLMs视为编程的新途径,我们可以摆脱狭隘的人工智能是否达到通用智能的争论,聚焦于它带来的实际工具价值和技术潜力。它激励开发者和研究人员重新探寻哪些传统方法无法解决的问题,探讨利用数据训练模型的模式实现创新。例如,在自然语言处理领域,LLMs能够生成高度连贯、有逻辑且富有创造力的文本内容,辅助编程、翻译、写作甚至医疗诊断等领域的知识表达与交流。在实际应用中,利用黑盒思维方式与快速排序类似,人们对LLMs的核心期待是输入问题或任务描述,输出相应的解决方案或文本,而不必掌握模型背后的复杂数学和训练过程。与此同时,这种黑盒使用并不代表盲目。研究人员持续开展模型可解释性和可靠性研究,试图让LLMs的结果更易被人类理解和验证,以提升其在关键场景中的信任度和安全性。

作为一个跨领域新兴技术,LLMs的前景广阔。它衍生出的软件2.0范式不仅影响人工智能领域,也重新定义软件工程、数据科学与用户交互模式。未来,随着计算能力的提升和算法优化,LLMs将变得更加强大、精细化,甚至具备一定程度的自适应和自我改进能力。面对这些变革,开发者应不断调整思维,从传统算法的逻辑流程转向数据驱动的模型训练,从硬编码规则转向灵活的语言表达,这将为解决更复杂、更宽泛的问题提供新路径。总之,大型语言模型和快速排序虽然在本质与实现层面存在差异,但将LLMs视为可以像经典算法一样调用的黑盒组件,为我们提供了评估和应用它们的实用框架。与此同时,LLMs作为新时代的编程范式,正引领我们进入一个以数据和智能模型为核心的软件开发新时代,推动科学研究、产业应用和社会生活的深刻变革。

未来,理解并有效利用这些技术,将是各行各业取得突破和创新的关键所在。 。