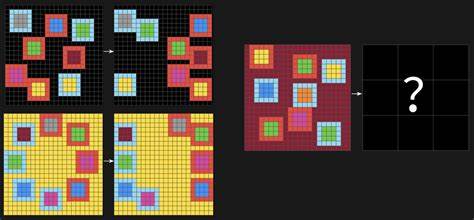

在人工智能领域,许多模型在各类标准测试上取得了骄人业绩,但存在一个特别的基准测试依然难以被机器成功攻克 - - Abstract and Reasoning Corpus for Artificial General Intelligence,简称ARC-AGI。这套测试由弗朗索瓦·肖莱特提出,旨在评估人工智能系统在面对崭新的抽象任务时的适应能力。ARC-AGI不仅对人类来说相对简单,而且强调通过规则发现和灵活应用来完成任务,使其成为衡量通用人工智能水平的重要工具。2025年推出的第二代ARC-AGI-2测试数据,进一步加强了符号解释、组合推理以及上下文规则应用等能力的考察,使得其难度远超前作。目前,尽管多款顶尖前沿模型如Grok-4、GPT-5和Claude Opus 4参与了竞争,但在ARC-AGI-2上的表现并不尽如人意,准确率仍停留在16%以下。人类参与者却能轻松达到近乎完美的成绩,这一差距凸显了人工智能在核心知识迁移及复杂推理方面的不足。

近年来,围绕如何提升AI在ARC-AGI上的表现,研究者提出了多种途径。其中"进化测试时计算"(Evolutionary Test-time Compute)技术表现突出,该方法由Jeremy Berman率先实现,其核心在于利用大型语言模型(LLM)生成大量潜在程序,通过测试筛选不断进化以解决单一任务。虽然这带来了突破性的准确率提升,例如在ARC-AGI-1中取得超过五成的成绩,但其效率较低,且未能实现跨任务知识共享,导致算法需要在每个任务上重新"学习"核心概念。与此形成对比的是谷歌DreamCoder框架,作为一种神经符号程序合成系统,它通过"醒-睡"循环机制逐步抽象和积累知识库,理论上具备跨任务知识迁移的潜力。然而,DreamCoder依赖于手工设计的领域特定语言(DSL),程序表达能力受限且不具备图灵完备性,且需要大量人力工程投入,这与AI持续发展中的自动化趋势背道而驰。基于以上利弊权衡,研究者Eric Pang提出结合两者优势的"高效进化程序合成"策略,将LLM生成的Python程序作为搜索空间,利用程序库不断扩充和进化。

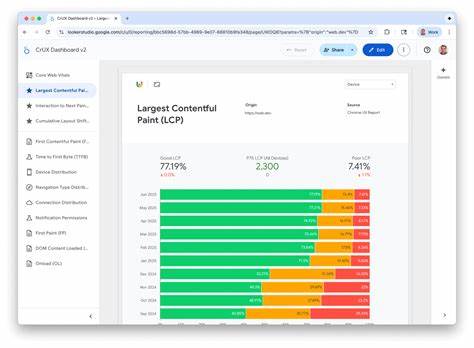

该方法避免了手工DSL设计的瓶颈,将先进的语言模型能力与进化算法融合,促进知识在任务间的共享和累积。具体来说,系统从空程序库出发,依次针对每个训练任务,调用LLM生成多个候选Python代码解决方案,并将当前库中表现最优的程序嵌入提示中,借此引导LLM进行更有针对性的生成。程序以主次两层准确度评估:主准确率关注训练示例全正确率,次准确率则细化至单元格级别的匹配度。如此,系统在每轮迭代中将最佳程序纳入库中,逐步壮大其知识基础并提升综合解题能力。该策略在ARC-AGI-1和ARC-AGI-2上均实现了前所未有的成绩 - - 在ARC-AGI-1峰值77.1%的正确率及ARC-AGI-2的26.0%得分,均优于众多竞品和定制系统。同时,该系统调用LLM次数远少于此前同类方法,显著降低了计算与时间成本,刷新了性能与资源消耗的帕累托前沿。

不同于纯粹基于准确率竞逐最高分,该系统强调"性能-成本"平衡,因而更具实用价值。此外,研究团队还探讨了引入神经网络辅助程序选择的可能性。利用Latent Program Network(LPN),一种基于变分自编码器的模糊潜空间编码模型,系统可以将程序映射至潜在向量空间,通过优化与目标任务间的向量距离,寻找更贴近理想解的程序类别。该方法在理论上能更细腻地捕获程序语义差异,进一步提升搜索质量。然而,由于计算资源限制,此技术尚未纳入最终提交版本,未来将是系统迭代的重要方向。从技术视角来说,此创新方案不仅彰显了LLM强大的程序生成和推理能力,也成功解决了程序合成中知识迁移的难题。

它突破了先前靠孤立任务"零起点"搜索的低效模式,使系统能像人类一样,随着解决问题经验积累,实现更高效的抽象与组合。其采用Python作为表达语言,天然支持图灵完备性,兼具灵活性和广泛适用性。值得关注的是,虽然目前某些后续研究在准确率方面实现了微幅领先,但其巨大的计算和资金成本限制了实际应用价值。相比之下,该系统以极具竞争力的成本效益比,成为探索通用人工智能在推理与自我进化方向上的范例。展望未来,将更多神经引导机制、动态提示策略以及多模型集成方法应用于进化程序合成,无疑将进一步推动AI理解和创造能力的边界。与此同时,随着ARC-AGI-3等下一代挑战的来临,基于本方法的多轮迭代和跨领域知识整合,有望为人类最终实现真正通用人工智能贡献宝贵经验。

总之,高效进化程序合成不仅是一种技术突破,更昭示着人工智能向自主学习、自我提升方向迈出的坚实步伐。随着技术生态的不断丰富,这一方法具备广阔潜力,将成为未来智能系统设计和优化的重要基石。 。