近年来,随着人工智能技术的迅猛发展,大型语言模型(Large Language Models,简称LLM)逐渐成为推动自然语言处理和生成式AI应用的核心动力。微软Azure AI作为云端AI服务的重要提供者,其集成的LLM功能被众多企业和开发者广泛依赖,支持从智能问答、内容生成到多模态交互等多样化场景。然而,随着模型迭代和新版本发布,部分用户开始反映同一模型在相同输入条件下其输出结果的准确性和连贯性逐渐下降,这一现象被戏称为"LLM脑叶切除"(LLM Lobotomy)。什么是LLM脑叶切除?它为什么会发生?对产品及用户体验又带来了哪些影响?本文将从实际案例出发,结合技术内幕和行业动态,带您全面了解这一复杂话题。在某些企业产品研发过程中,开发团队会定期通过自动化测试框架,以固定的测试集和参数(如温度设置为零,保证模型输出的确定性)评估所用语言模型的表现。这种方式用于确保在每次版本发布或配置更新后,模型的表现依然符合预期。

然而,一位使用Azure开放式AI服务的开发者"萨奇"分享了自己的观察:同一版本号的模型,在使用相同系统提示语和输入数据的情况下,随着时间推移,其生成的答案准确度却在逐渐降低。令人困惑的是,尤为突出的是在gpt-4o-mini模型版本开始出现明显退化,而在最新发布的gpt-5-mini、gpt-5-nano等模型上,发现准确度依然不佳,甚至响应速度时快时慢,令实际应用蒙上阴影。"脑叶切除"这个比喻描绘了模型似乎被"降低智力"或"削减能力"的感觉。与传统软件升级带来的性能提升不同,LLM服务的更新迭代却出现了"退步"的表现。这种现象让开发团队对现有云服务的稳定性和持续可用性产生了深刻疑虑。用户敏感地捕捉到:到底是模型规模缩水,还是微软方面为推动新版本升级,而牺牲了老版本的服务质量?甚至有猜测称,背后可能存在模型参数量的"暗度陈仓"调整,使得同一版本号对应的模型实际上运行的是不同性能的参数组合。

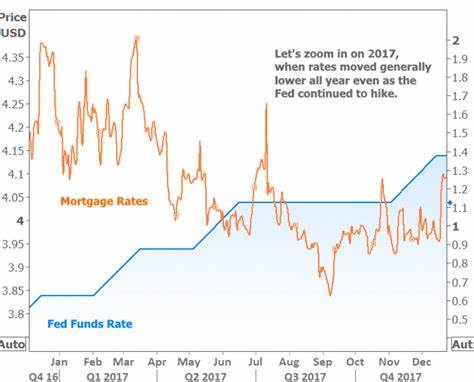

这种困惑引发了行业中广泛的讨论:企业如何在依赖云端AI服务的同时保证自身产品的可靠性和用户体验?微软的做法是否与其业务战略紧密相关?在实际研发中遇到这种模型"退步"趋势,团队如何科学应对和进行风险管控?从技术层面看,LLM的服务质量受多方面因素影响。首先,云端模型可能采用动态权重切换或多版本并行部署,意图在保证服务响应速度与成本的基础上,实现资源的弹性调度。但这种做法若缺乏严格的版本锁定和透明度管理,则极易导致模型表现的不稳定。其次,模型的参数量和架构虽然重要,但系统提示语(system prompt)在引导模型输出时同样起关键作用。修改系统提示语或策略调整未必会立即体现在用户侧,且存在潜在的上下文漂移风险。此外,算法层面的量化、剪枝、权重压缩等优化手段尽管能提升效率,也可能在无形中降低模型推理质量。

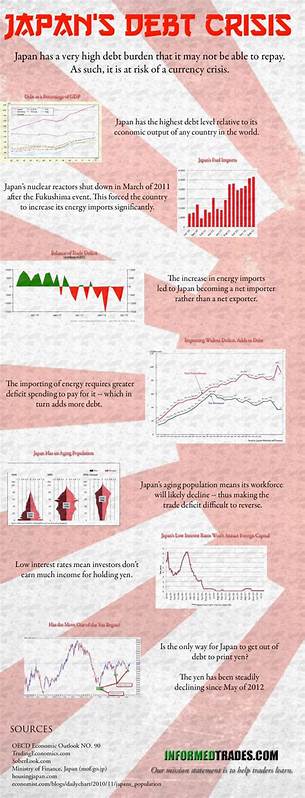

商业策略方面,微软可能正推动客户快速迁移至最新版本的模型。新版本通常伴随功能增强和架构升级,但初期存在性能瓶颈和不稳定因素在所难免。在此过程中,对于旧版本模型的维护力度可能下降,从而出现所谓的"强制淘汰"现象。虽然从技术创新角度看,鼓励客户采用更新、更智能的版本符合长远利益,但由于模型成熟度、请求响应时间和准确率未能同步提升,实际体验却适得其反,引发部分客户强烈不满。此外,Azure AI的支持机制和问题反馈渠道表现出的迟缓也加剧了客户的焦虑。遇到模型性能异常需等待长达一周的回复周期,严重影响产品快速迭代和用户问题响应。

这种体验给用户带来了信心危机,更有甚者开始考虑将底层服务迁移至其他云平台以求稳定保障。面对这样的挑战,技术及产品团队应采取多维度的应对策略。首先,建议用户在Azure AI上设置模型版本的手动更新策略,避免自动版本替换带来的意外波动,确保测试环境与生产环境一致。其次,加强部署前的持续回归测试和语义相似度监控,利用embeddings为文本结果建立基线,从而及时发现语义漂移和准确率下降。再者,实施请求日志的详尽记录,包含调用参数、返回结果以及平台响应头信息,给予云服务商足够数据支持以协诊断。最后,建立严格的应用层验证机制,对模型输出结果进行规则校验,如对枚举结果进行限制,避免因模型波动导致的业务错误。

对于云服务提供商而言,透明地公布模型升级路线、优化后的指标表现和已知问题处理进度有助于用户信任的建立。开放更多的版本锁定、灰度测试和性能对比工具,也将极大助力开发者合理选择并稳定使用模型。持续保持旧版本的维护和兼容性,是保证长期客户忠诚度的重要保障。在未来,随着AI模型的不断进化和行业生态更加成熟,类似"脑叶切除"这类现象有望逐渐被规范化的模型版本控制和监控体系消除。服务商和用户的双向透明互动,结合高质量的技术支持和明确的商业策略,将成为提升AI产品价值的关键所在。更重要的是,AI技术从科研走向生产,要求我们针对模型稳定性和业务贴合度投入更多关注,实现技术能力与用户需求的平衡。

总结来看,大型语言模型在云端应用中的表现起伏提醒我们,技术迭代永远伴随挑战。理解"LLM脑叶切除"现象背后的复杂因素,有助于开发者更好地规划和实现高质量的AI产品。同时,也促使云服务提供商不断改进支持体系和服务策略,以满足不断增长的市场需求和用户期待。面对不确定性,我们既需保持警觉,也要积极探索科学的测试与监控路径,推动AI生态健康有序发展。 。