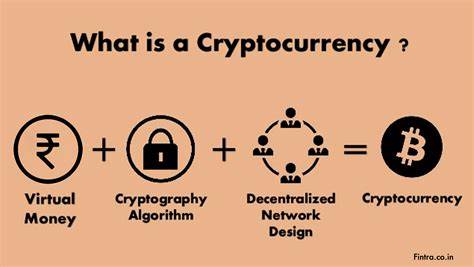

在人工智能领域,关于模型能力的评价经常成为公众讨论的焦点。近期,知名博主Scott Alexander发表了一篇名为《Now I Really Won That AI Bet》的文章,宣称生成式人工智能在图像组合性方面取得显著突破,宣告胜利。然而,著名认知科学家及人工智能研究者Gary Marcus针对这一观点提出了严肃质疑,认为Alexander的论证存在逻辑误区,并未合理反映当前AI技术对组合性理解的真正掌握程度。 组合性,指的是系统理解和构建整体时能够准确把握部分与整体之间的关系,这在图像生成、自然语言理解等多个领域都属于核心难题。Scott Alexander在几年之前曾与他人下注,预测生成式AI会在2025年6月前能较好地完成一组涉及组合性的问题。当前,GPT-4o等先进模型在这些特定任务上确实表现良好,支持了Alexander在赌约细节上的胜利。

然而,Gary Marcus指出,这种胜利仅仅触及了组合性问题的皮毛——即所谓“motte and bailey”论证误区。Alexander成功解决了一个狭窄的子集任务,即“堡垒”(motte),但是将这一局部成功夸大为整体的“组合性掌握”,即“围墙”(bailey),这种推论过于武断且缺乏充分证据。淡化复杂问题的多样性和深度,只凭借少数标准化测试任务宣称AI已经“精通”组合性,有违科学严谨态度。 Marcus在实验中展示了多例简单且典型的失败案例。例如,要求生成图像包含五个具有特殊部件描述的角色时,GPT-4o多次未能正确呈现诸如“单臂人”、“三头熊”或零轮自行车”等细节。生成的不准确还包括无法自我识别错误,这说明AI不仅在执行组合性任务方面仍有缺陷,更在自我监督与纠错层面表现不足。

这些挑战并不仅仅是细节微调就能轻易解决的问题,其根源在于当前深度学习模型的架构及训练方式对复杂关系和结构性知识的理解有限。 除此之外,Marcus强调公众广为流传的测试提示(prompts)样本可能已经渗透进训练数据,这引发了数据污染问题。换言之,模型成功完成某些公开测试,未必源于真正的理解能力,可能与记忆和过拟合有关。由此导致的表面成功难以被等同于广泛的、普适的认知技能。科学评估需要更多维度材料和未见数据支持。 从认知心理学的角度看,评估智能系统能力绝不能依靠单一测试。

早在20世纪70年代,著名心理学家John R. Anderson便提醒,有限样本的行为表现往往可以由不同机制解释。换句话说,AI模型对某几组示例做出正确回答,不足以证明它们具备通用策略或深度理解。广泛的、连贯稳定的能力考验,需要跨越多样化和复杂的测试场景。 反观Alexander的论证流程,他将特定时间点上的成功视为整体能力的证明,显然犯了“归纳偏误”的错误。即不合理地从部分样本的特征直接推及整体结论,忽略了其他未测试或容易失败的情境。Marcus呼吁对AI能力的评估应更客观,避免流于称赞和乐观主义,而应兼顾失败与瑕疵,真正认清模型现有局限和未来挑战。

在实际应用层面,虽然GPT-4o相较于前代如DALL-E 2在生成精确描述图像方面表现出更高的准确率,比如能够生成“夜店中的科学家拿着蓝色飞盘,上面放着红色篮球”的场景,但不足以证明已跨越所有组合性难题。许多复杂任务仍然难以保证所有子部件正确无误。对这一领域的分析和改进仍需要大量深入的研究和创新。 深入思考Alexander与Marcus的辩论,有助于我们更好地理解生成式AI目前的真实能力水平以及未来发展路径。一方面,不能否认的是,模型在某些预定任务上的进步确实反映出技术演进的快速步伐;另一方面,以此为据过早宣称“掌握”组合性不仅忽视了问题的复杂本质,也可能误导研究方向和公众预期。 Gary Marcus在文章最后通过开诚布公的公开信邀请Scott Alexander进行更高难度的挑战,表明科学探究的严谨态度。

他预计,到2027年底,生成式AI仍将显露出诸多组合性问题。这种期望既基于对当前技术架构不足的理解,也反映了对未来人工智能发展中需解决核心难题的现实把握。 总结来看,Scott Alexander的胜利庆功虽有其合理成分,却难以代表整个组合性问题的解决。AI领域的成功案例往往伴随着大量未解决的挑战,这正是推动科技进步的动力。理解和坦然接纳模型在组合性能力上的局限,有助于制定更加合理的研究目标和应用策略,促进人工智能系统向更全面、更稳健的认知能力迈进。 未来,人工智能的发展必然经历反复的胜利与挫折。

我们应以科学家般的严谨视角,既认可技术的进步,又保持对挑战的警觉。只有如此,才能真正推动AI走向具备普适组合性理解与创造力的“通用智能”阶段,为人类社会带来切实且深远的益处。