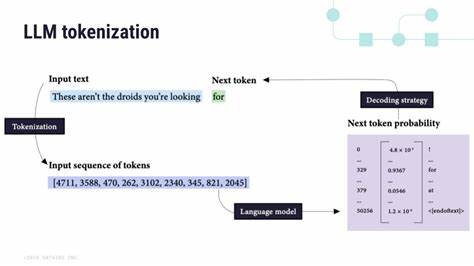

随着人工智能技术的迅速发展,基于大型语言模型(LLM)的应用在各大领域不断普及。这类模型在文字生成、对话系统和智能助手中发挥着重要作用,为用户提供丰富的交互体验。然而,在Web端运行这些模型时,开发者面临着一个关键技术难题,那就是如何在网页刷新过程中持久化LLM的Token流,从而保证用户的对话连续性和数据的完整性。本文将深入探讨这一问题,分析其背后的技术挑战,并介绍当前的解决思路,助力开发者打造更稳定、高效的AI产品。大型语言模型依靠逐步生成Token(即语素)的方式构建文本,每一次模型推理都会输出一个新的Token,形成一个连贯的语义流。在交互式应用中,比如聊天机器人,这些Token流实时决定了对话的连贯和用户体验。

然而,网页刷新操作通常会导致前端环境的重置,包括运行状态的清空、内存数据的丢失,从而使得正在生成或已生成的Token流无法被保存。这对用户来说意味着对话中断,数据丢失,体验不连贯。持久化Token流的核心在于保存语言模型当前的推理状态。这不仅包括已经生成的Token序列,还包括模型隐状态以及上下文信息等。这样一来,即使前端页面刷新,系统依然能从上一次停留的地方继续生成文本,避免重复计算和内容丢失。目前,解决该问题的技术途径主要集中在以下几个方面。

首先,利用浏览器的本地存储机制,如LocalStorage、IndexedDB,将Token序列和部分上下文数据进行序列化保存。这种方案实现较为简单,适合保存不太大的数据,但存在存储容量有限和安全性等问题。此外,纯前端的存储无法保存模型的中间状态,这在复杂对话场景中存在局限。其次,将模型推理状态和Token流同步到后端服务器。通过定期或者实时上传当前Token和上下文,服务器端可以持久存储完整的对话状态。用户刷新页面后,前端从服务器拉取上一次对话数据,实现断点续传。

这种方法确保数据安全和完整,支持大规模和复杂情境,但对网络稳定性要求较高,且实现较为复杂。第三,利用WebAssembly(WASM)等前端高性能运行环境,实现部分模型推理的本地化,并通过状态序列化技术保存中间状态。WASM可以在浏览器中高效执行模型计算,将推理状态序列化后存储到浏览器端,再次加载时反序列化恢复,降低了与后端的频繁交互。该方案具有前后端混合优势,但目前适配与开发难度较大。此外,一些开源和商业的LLM推理引擎正逐步支持中间状态序列化功能,这为持久化Token流提供了底层技术保障。与此同时,合理设计前端交互逻辑也至关重要。

对于用户,系统应当提供友好的断点续传体验,避免页面刷新导致对话中断。例如,在页面刷新时提示用户保存对话,或自动执行状态备份,最大程度减少信息丢失。对开发者而言,关注数据传输安全和隐私保护尤为关键,持久化方案应兼顾效率与用户数据安全合规。持久化Token流不只是技术挑战,也是提升用户体验的核心需求。随着Web应用中智能对话的普及,如何无缝维护对话上下文,减少重启等待和信息重复,已成为行业关注的重点。展望未来,随着前端技术的不断进步,模型压缩优化和推理状态管理将更加成熟,持久化方案也会更加多样和高效。

同时,云端与本地协同计算的架构趋势,将为解决Token流持久化带来新的机遇。综上所述,在网页刷新过程中持久化大型语言模型的Token流,是一个涵盖前端存储、后端同步、模型状态管理、交互设计和安全合规等多方面的复杂课题。通过合理组合本地存储和服务器端技术,搭配高效的模型推理状态管理,开发者能够显著提升智能对话应用的稳定性和用户满意度。未来技术演进将进一步降低实现难度,为用户带来更流畅、智能的交互体验。