在过去十几年中,云计算服务逐渐成为信息技术发展的主流,人们习惯于按需付费,享受强大的远程计算能力。而随着人工智能特别是大型语言模型(LLM)的蓬勃兴起,这种云端模式似乎再次被重复,用户需要支付大量成本来获得AI服务。然而,随着技术的快速进步和用户隐私保护意识的增强,越来越多的人开始倾向于在本地运行这些AI模型,从而催生了"自带大脑"的时代。本地大型语言模型为何会迎来快速崛起?透过数据隐私、成本控制、技术民主化以及环境影响等多重维度,我们可以详细剖析这一趋势背后的深层次动力。 保护隐私和数据主权是用户选择本地运行LLM的重要原因。随着AI应用的广泛普及,用户在享受智能便捷的同时,也面临数据被滥用的巨大风险。

调查显示,超过80%的美国用户担忧AI公司会滥用他们的数据。美国联邦贸易委员会曾多次敦促AI服务提供商严格履行客户数据保护承诺。然而,现实情况却充满挑战。例如,OpenAI虽然承诺应用户要求删除聊天记录,但在法律诉讼中必须保留相关数据。Anthropic公司更是近期将数据保留期限从30天延长至五年,且开始基于用户数据训练模型,虽然可选择关闭,但默认是自动采集。此类案例不断加剧用户对云端服务的数据安全担忧,从而促使企业和个人开始探索本地化部署的可能。

除了隐私,数据主权和合规性问题在全球范围内同样引发关注。欧盟严格的《通用数据保护条例》(GDPR)要求数据操作必须遵守高度标准,因此德国等欧洲公司纷纷开发本地运行的AI系统,确保AI的使用符合法律和道德规范,避免数据跨境流动带来的风险。这不仅是法律合规的需要,也代表着一种技术主权的体现,本地LLM成为言之成理的解决方案。 技术民主化的理念也深刻影响着本地LLM的流行。AI作为人类历史上最重要的杠杆力量之一,若由少数科技巨头垄断,不仅限制了创新的多样性,也让技术使用者失去主动权。许多开发者和企业倡导在个人和中小型组织手中普及AI技术,确保模型和工具的开放使用权。

例如,Jan项目及其负责人强调让AI保持开放,成为"掌握在大众手中而非少数巨头"的共同资源。本地部署正是实现这种技术民主化的有效路径之一,用户不必依赖外部服务提供商,从而获得更大自由度和控制权。 从经济角度来看,运行云端AI服务的成本持续上升且模式并不理想。基础模型供应商往往以亏损价提供服务,最终利润需要通过限流或提高收费获得。对于那些需要长时间、大规模使用AI的用户来说,云端服务的令牌计费方式极易导致成本小幅却迅速积累,体验也频繁被限速打断。早期开发者曾频繁感叹因每段代码运行所产生的高昂花费令人难以承受。

在这种情况下,拥有本地AI模型意味着无需持续支付令牌费用,只要硬件配置允许,就能实现无限制的AI推理,极大提高效率和用户体验。 环境保护角度同样不可忽视。数据显示,美国数据中心预计到2030年将消耗全球约9%的电力资源,且大量使用蒸发式冷却造成水资源巨大浪费。相比之下,本地运行AI推理过程中的电力消耗虽仍存在,但用户通常使用密闭循环水冷系统,减少了水的消耗。同时,电力来源的洁净程度和设备生命周期碳排放也是影响环境负担的重要因素。即使如此,本地推理的灵活控制仍然为环境可持续性提供了一定的优势,特别是在绿色能源普及的地区。

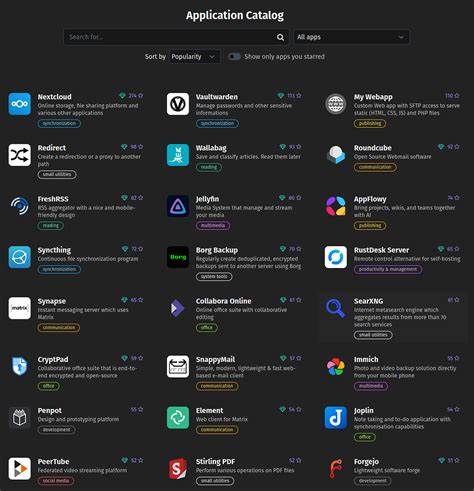

硬件升级和软件创新共同推动本地LLM的可行性。传统观点认为,AI模型体积庞大,计算要求极高,难以在个人设备上顺畅运行。然而,通过量化技术降低参数权值精度,例如使用16位半精度浮点数或更低的整数形式,极大减少了模型存储和运算需求,同时对模型准确度影响有限。此外,借助于高性价比二手企业级显卡或苹果M2芯片等先进硬件,十亿级至数十亿参数的模型均可流畅运行。 在软件层面,低级别推理库如ggml及其衍生项目llama.cpp极大促进了模型在多种硬件上的运行,这些开源项目支持CPU和GPU计算,降低了使用门槛。类似Ollama这样的用户友好型平台更进一步,提供数百个预配置模型,实现单行命令下载安装,让非程序员也能轻松接触和使用本地AI。

此外,LM Studio和Jan等工具通过抽象底层复杂依赖,将运行、管理和微调本地模型变得简单直观,吸引了法律、金融、教育等领域的从业者。 不同用户根据需求和硬件条件,选择适合自己的模型日渐多样。通用模型如Llama和Mistral覆盖从数十亿参数到更大型号不等,满足日常查询和写作需求。谷歌Gemma 2甚至能缩减至仅2亿参数,适合嵌入式设备。专门化模型如Qwen 2.5 Coder 7B聚焦编程辅助,提升代码编写效率。趣味性模型如Mythomax则为桌游角色扮演等场景增添乐趣。

用户只需匹配自身使用情境和硬件条件,便能找到合适的"智脑"。 然而,对于企业级或高难度应用,大型云端模型仍保持优势。参数规模决定了模型的广度和深度,超过数百亿参数的模型拥有更通用、更准确的知识库,这使得本地模型难以完全取代。同时,云端厂商的商业秘密和技术壁垒在某种程度上保持了其市场领先地位。尽管如此,随着技术迭代和模型差距的逐步缩小,本地模型的应用前景正愈发明朗。 面对这些挑战,检索增强生成(RAG)和多智能体架构提供了实用方案。

通过构建定制知识库,本地LLM可以专注于特定领域的问题解答,实现针对性强且准确率高的服务。多智能体系统则可将不同任务分配给专业模型,增强整体智能表现。诸如Langchain和CrewAI这样的框架,让用户能够灵活组合和协调多个AI代理,打造符合自身需求的智能体系。 趋势还显示,促使本地LLM快速发展的关键在于社区和开源生态的积极推动。技术贡献者不断优化推理效率、降低资源消耗,普通用户借助教程和交流平台克服了学习门槛。作为用户,了解自己的隐私需求、性能期望及预算限制,结合合适的模型和工具,是迈入本地AI世界的关键第一步。

随着未来技术的不断完善和硬件升级,属于"自带大脑"的时代将进一步普及,更多人将亲手掌控自己的智能助手,实现真正意义上的个性化和隐私友好型人工智能体验。 。