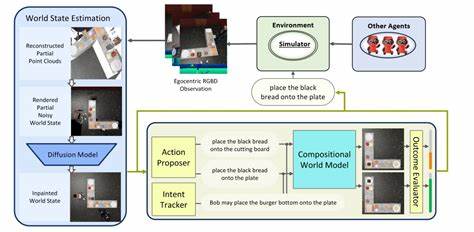

在人工智能领域,世界模型是智能体理解环境动态、预测未来状态的核心组成部分。传统的基于深度学习的世界模型虽然取得了一定成果,但常常需要大量数据和计算资源,且对稀疏观察的适应性较差。为了解决这一瓶颈,PoE-World引入了一种创新性的程序合成方法,利用大语言模型(LLMs)合成程序化专家,并通过专家的产品组合进行世界状态的推演和预测,从而形成灵活且精准的组合世界建模框架。 PoE-World的核心思想在于将复杂的环境动态拆解为多个独立但互补的小程序专家,这些专家分别负责环境中不同对象类型或不同机制的状态变换。通过对这些专家概率分布的加权乘积,系统能够获得更加细致和多样的状态预测。此方法不仅大幅提高了模型的样本效率,也极大地增强了泛化能力,使得智能体能从极少的演示数据中学习并适应未知关卡或场景。

这种程序化专家的产生依赖于先进的程序合成技术,特别是基于LLMs的自动编程能力。系统通过分析少量的演示数据,合成符合环境规律的Python程序,每个程序均可看作一个“专家”,负责处理特定条件下对象的行为变化。例如,专家可能描述当玩家对象接触传送带时速度如何变化,或当某一特定动作触发时玩家的运动状态如何调整。这种结构化、符号化的知识表达形式使得模型更具解释性,同时也便于后续在线的动态调整和优化。 PoE-World不仅在程序专家的构建上展现出创新,同时搭载其构建的世界模型在经典的Atari游戏如Pong和Montezuma's Revenge中表现出了卓越的适应性和效率。令人惊叹的是,PoE-World结合规划器(Planner)能够仅使用不到一分钟的演示且不依赖正分数表现,就达成在Monteuma's Revenge中实现正分的突破。

此外,在Pong的复杂变体Pong-Alt中,也能利用对原版Pong的短暂演示,成功应对含有三名敌手和三枚球的挑战环境。 在技术层面,PoE-World世界模型采取的产品专家模式,将各个小的程序专家输出的概率分布结合成一个集合的预测分布。例如,一段Python程序可能以概率分布的形式预测玩家的速度变化,另一程序则对位置更新做出解释。通过对所有专家的分布结果进行指数加权乘积,可以兼顾各专家的影响力度,从而形成更加准确的状态预测。此设计突破了传统单一模型的限制,实现了模块化和可组合的建模框架。 这些程序专家覆盖了环境中的多种对象类型,包括玩家、钥匙、骷髅、传送带、平台、梯子、围栏和弹球等,每个对象的状态变化均被多专家协同建模。

专家的细粒度设计使得模型能够在符号层面捕捉环境规则,如碰撞检测、速度调整和位置绑定等复杂机制,辅助规划器进行未来状态想象,驱动智能体做出更优行动选择。 此外,PoE-World也实现了在线的专家权重微调与更新,有效应对环境的动态变化和偶发事件。通过在交互过程中,系统不断根据实际观察调整专家权重,模型能不断提升预测的契合度及环境适应力,有利于长期运行中的性能持续优化。 PoE-World突破了以往程序结构化世界模型仅限于自然语言处理与简单网格世界的壁垒,成功应用于更复杂、非格状的游戏环境,彰显了其广泛的适用潜力和实用价值。其使用程序代码作为知识载体的方式,使得模型不仅具备强泛化能力,更能被人类工程师理解和修改,便于知识的编辑和迁移。 同时,我们可以发现,PoE-World融合了符号AI优势与现代统计学习的灵活性,实现了两者的互补,开辟了世界模型研究的新方向。

通过高效的程序合成技术实现对环境规律的挖掘与表达,减少了对大规模训练数据的依赖,也提升了模型的解释力和透明度,这对智能体在实际应用中面对少量数据和复杂动态环境尤为关键。 未来,PoE-World的框架有望推广至机器人控制、自动化推理和更广泛的智能规划领域。借助对复杂环境机制的程序化捕捉,智能体能从有限的观察中快速构建内在世界模型,实现更高效的决策和持续自适应。此举不仅提升了AI系统的通用性,也降低了其对数据和计算资源的需求,促进AI技术的普及与实用化。 综合来看,PoE-World作为一种基于程序合成的组合世界建模方法,以其创新的产品专家结构和强大的泛化性能,在复杂游戏环境中表现卓越,代表了程序化世界建模领域的重大进展。它不仅丰富了AI构建世界模型的方法学,也为实现更加智能、灵活和透明的AI系统奠定了坚实基础。

随着相关技术的进一步发展,PoE-World及其衍生方法必将在人工智能研究和实际应用中发挥越来越重要的作用。