近年来,人工智能,尤其是基于大型语言模型(LLM)的智能对话工具如ChatGPT,在为用户解答问题和提供信息上展现出了巨大潜力。然而,最新的研究表明,这类AI工具在为用户提供公司官方网站URL时,正确率并不理想,错误推荐的比例高达近三成。尤其是当用户请求提供金融、零售、科技等行业的公司登录网址时,AI往往会生成死链或者非官方的合法网站地址,这种现象引发了网络安全专家的广泛关注。Netcraft作为知名的威胁情报公司,针对GPT-4.1家族模型进行深入测试,发现仅有约66%的网址推荐准确无误,而29%的网址则指向已删除或暂停的站点,另有5%推荐了合法但非目标公司的网站。虽然不准确的URL推荐在使用者看来只是小小的不便,但这种缺陷无疑为网络钓鱼犯罪分子打开了方便之门。网络钓鱼者常常关注AI模型的推荐失误,选择尚未注册的错误网址进行注册和搭建伪装网站,从而诱导用户访问虚假平台,窃取账户信息和个人隐私。

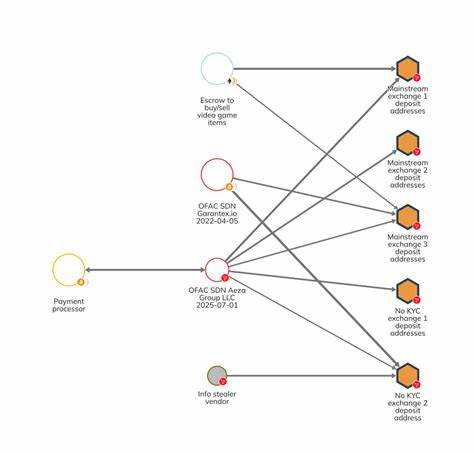

攻击者通过观察AI的推荐偏差,针对性地抢注这些错误门户,借此伪装成真网站诱骗无辜用户。这种利用AI缺陷发动的诈骗活动,已逐渐形成新的犯罪手法。漏洞的根本原因在于当前AI模型在处理网址信息时,主要基于关键词和文本关联进行匹配,并不具备验证网址真伪、信誉及安全性的能力。例如,在测试请求“莲花银行(Wells Fargo)的登录网址”时,ChatGPT曾错误地返回一个曾被用作钓鱼攻击的仿冒站点。这表明,在复杂的网络环境中,简单依赖语言模型的相关性分析不足以确保信息的准确和安全。网络钓鱼团队已经开始调整策略,不再单纯依靠传统搜索引擎获取目标,而是专门设计内容和网站,通过GitHub仓库、问答文档、教学示范、社交媒体账户等方式增加虚假信息的可信度,优化其在AI结果中的排名,以此诱骗程序员和普通用户访问钓鱼站点。

此次趋势表明,钓鱼犯罪不再局限于大众层面,正在向技术和开发者社区渗透。类似的攻击手段已被观察到针对区块链和开源代码生态的领域,如通过“投毒”Solana区块链API接口,引诱开发者误用恶意代码。黑客通过维护大量虚假技术文档、造假项目仓库和虚拟身份,精心打造可信环境,迷惑AI模型,从而让钓鱼页面和恶意代码更容易出现在使用AI助手的用户面前。这种策略在形式上可视为一种新的供应链攻击,需要警惕其对数字基础设施造成的潜在破坏。面对AI推荐网址错误导致的钓鱼风险,用户应提高警觉,避免单纯依赖聊天机器人给出的链接信息。验证官方网站应通过访问品牌的官方公告、通过受信任的渠道获取信息,以及利用浏览器收藏夹和官方认证标识进行确认。

同时,信息安全企业和AI开发者需要加强对模型的监督和训练,提升其识别恶意和虚假信息的能力。在服务设计层面应加入网站声誉检测、黑名单过滤等安全机制,减少错误推荐的概率。此外,建立跨行业的合作机制,通过共享钓鱼网站名单和攻击手段情报,加强对钓鱼链接的实时监测,也有助于防范此类风险。未来,随着AI技术的不断迭代,解决自动推荐系统的安全盲点成为业界迫切需求。教育用户提升网络素养,培养辨别虚假信息的能力,也是抵御钓鱼攻击的关键环节。通过开展普及网络安全知识的活动,提醒公众在依赖AI获取信息的同时,保持必要的怀疑和审慎,以免陷入数字陷阱。

综上,ChatGPT等语言模型在推荐网址时出现的错误,看似技术层面的不足,却直接助长了网络钓鱼犯罪的发展。面对这一新兴威胁,无论是用户、企业还是AI开发者,都需同步提升安全防范意识和能力。只有多方协作,才能在人工智能与网络安全的赛跑中,构筑起真正的防线,守护数字时代的安全生态。