随着人工智能技术的发展,强化学习(Reinforcement Learning,简称RL)在训练智能体解决复杂任务中展现出强大潜力。近期,一项基于苹果硅芯片(Apple Silicon)生态环境的创新项目,尝试利用RL能力训练大型语言模型(Large Language Model,LLM)来玩Wordle游戏,取得了令人瞩目的成果。Wordle作为一款以词汇猜测和策略推理为核心的游戏,具有结构清晰、反馈机制明确的特点,是验证RL策略和语言模型表现的理想试验场。本项目不仅仅为强化学习在语言理解领域的应用开辟了新路径,也通过苹果自研的MLX框架解决了本地训练的性能和内存瓶颈,展示了在无须云端资源即可实现复杂AI训练的可能性。 Wordle游戏的核心在于玩家需通过每次猜测获得的反馈,逐步缩小可能答案空间,最终确定唯一正确的单词。传统算法通常采用基于信息论的熵最大化策略,即通过计算每个可能猜测带来的信息增益,选择最优猜测以最快速度缩小词库。

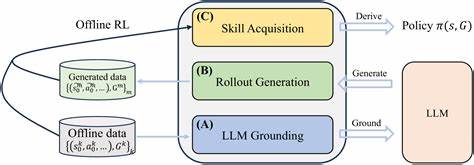

然而,本项目所采用的RL策略则截然不同。它通过引导语言模型根据奖励函数来制定猜词策略,奖励体现于猜测的正确率、策略合理性及信息贡献,惩罚则包括格式错误、重复猜词及违反线索的行为,因而赋予模型通过自主"试错"达到优良表现的能力。 在硬件层面,选择苹果硅芯片作为训练平台的优势显著。相比传统基于GPU的训练方案,苹果硅采用统一内存架构,配合Metal Performance Shaders(MPS)实现硬件加速,带来效率与能耗上的双重优化。MLX框架专为苹果芯片打造,在兼顾性能的同时也解决了此前PyTorch生态对Apple Silicon支持不充分,特别是在量化库bitsandbytes缺乏稳定支持的问题。通过对MLX的灵活利用,项目实现了本地从数据预处理、模型微调到推理全流程的流畅运转。

训练流程从环境搭建开始,用户需下载并配置Gemma-3大型语言模型权重,随后依据项目提供的合成数据生成脚本,构造多样化的Wordle游戏状态以提升模型对不同局面下策略选择的适应性。奖励函数设计尤为关键,融合了多维度的策略激励与错误惩罚。有效猜出正确单词给予巨大正激励,合理利用信息增益和未使用字母则获得额外奖励,而无效单词、格式不合或者重复猜测则受到严格惩罚,确保学习过程朝着预期目标前进。此外,还有针对效率的软性惩罚,鼓励模型优先快速收敛解答。 模型训练采用了策略梯度优化方法,结合了低秩适配(LoRA)技术,使得大模型在有限资源条件下依然能够高效调优。训练配置严格控制超参数,尤其重视梯度裁剪,避免政策崩溃现象。

训练过程中观察到模型在探索与利用上的平衡逐渐改善,累积胜率稳步攀升,充分证明策略优化的有效性 评估环节显示,带有历史游戏信息输入的模型表现优异,明显超过基准未微调模型。低温度(temperature)采样模式下,模型输出更加确定,整体表现更稳定,而高温度模式虽然增加随机性,但降低了胜率。尤其在首轮无历史时,模型尚未形成稳健的开局策略,导致整体性能下降。这指出了未来结合传统最佳开局词(如SOARE、CRANE)与RL策略结合的潜力,利用混合方法提升初始猜测效果后,模型可在后续回合发挥更佳推理能力。 项目过程中也积累了丰富经验教训。最基础的软件系统设计至关重要,只有确保环境的严格一致性和数据完整,RL代理才能有效学习。

奖励机制需反复调试以杜绝"奖励黑客"行为,如逃避任务或反复输出无效内容。Prompt设计方面,清晰的自然语言状态描述明显提升模型理解力及策略执行力。数据多样性和训练课程设计(Curriculum Learning)帮助模型更快掌握游戏规则和策略调整。最重要的是,纯RL训练无监督微调辅助对小型模型尤为不友好,往往导致训练不稳定或失效,表明规模和训练方案需合理搭配。 此外,对硬件资源的深入理解直接影响训练效率。内存管理尤其关键,过度使用会引发交换空间的大量占用,导致速度骤降。

KV缓存管理亦需权衡生成并行数和内存负载,合理配置可实现性能最大化。 整体而言,此项目不仅验证了强化学习结合大型语言模型在策略游戏中的可行性,更示范了苹果芯片生态下本地化AI训练的实践路径。其技术细节、训练策略及所获经验对强化学习、自然语言处理、模型微调以及边缘计算领域研究者具有借鉴价值。未来若能将游戏领域经验迁移至更宽泛的语言推理或交互任务,其潜力不可限量。与此同时,整合传统算法的先验知识进RL框架,以及探索多模态、多任务联合训练,将有望进一步提升智能体表现和泛化能力。 苹果硅芯片与MLX框架的结合则为本地AI训练树立了新标杆,推动未来更多开发者在无云依赖的环境中实现复杂模型的高效训练与应用。

Wordle作为契机,映射了人工智能在约束环境中学习策略的本质问题,也展示了强化学习与语言理解深度融合的丰富前景。随着技术的不断演进与优化,这样的实践案例将为智能软件设计和交互体验革新提供持续动力。 。