2025年6月,OpenAI正式推出了全新模拟推理模型o3-pro,标志着人工智能在专业领域应用中的一次重要升级。与前代型号o1-pro相比,o3-pro不仅在性能上有显著提升,更以大幅降价吸引了众多开发者和用户关注。该版本的诞生,激发了关于AI“推理”究竟意味着什么、其优势和局限性的广泛讨论。深入理解这些问题,对于把握人工智能研究的未来趋势极为关键。 o3-pro的独特之处在于其整合了链式思维(chain-of-thought)技术,专注于数学、科学和编程等复杂任务的处理。同时具备网页搜索、文件分析、图像识别以及Python代码执行等新型能力,这些功能使得o3-pro成为处理高难度分析问题的理想选择。

对比传统的一般化模型如GPT-4o,o3-pro更注重用更多的计算资源分步推理,通过显式表述“思考过程”来逐步解决难题,提升准确率并减少数学错误。然而,这种模拟推理并不意味着AI具备真正的人类逻辑思维或对问题本质的深刻理解。 实际上,目前的所有基于Transformer架构的语言模型,本质上依然是极其强大的模式识别系统。它们通过海量训练数据中的范例,学习并复制人类解决问题的思路和模式,但未必能真正理解或创新。这就导致了模型即使在模拟推理的情境下,也可能出现自信满满但错误百出的答案。不同于人类会自我反思和调整策略,AI模型无法主动察觉自身逻辑错误,面对矛盾甚至会盲目前行。

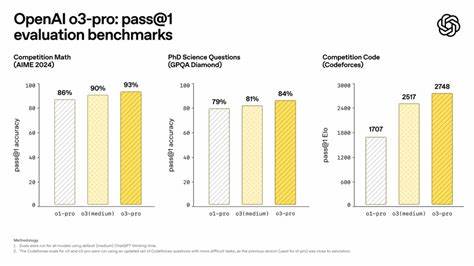

这种现象在数学奥林匹克题和复杂控制谜题的测试中均有体现。 尽管如此,o3-pro在专业测试中表现出色。例如,在2024年的美国中学数学竞赛AIME上,其首次通过准确率高达93%,明显优于o1-pro的86%。在博士级科学问题和编程挑战中,o3-pro同样展现了显著进步。OpenAI的内部评测也表明评审专家在科学、教育、商业和写作等多个领域更青睐o3-pro,给予其更高的清晰度、完整性和准确性评分。这些成绩充分证明了模拟推理模型在当前应用场景中的实用价值。

经济层面上,o3-pro大幅度降低了开发者的使用成本。在API调用费用方面,输入token的价格降低了87%,输出token价格降幅达到80%,极大提升了模型的性价比。这不仅符合产业界对高性能低成本解决方案的迫切需求,也为更加广泛的技术创新提供了基础。尤其是在教育、科研、软件开发等需要深度分析的领域,o3-pro能够更广泛地被中小型企业和个人开发者所接入。 不过,专家们也反复强调,理解和接受AI推理的模拟性质极为重要。“推理”在AI圈里并不是传统意义上的逻辑推断或认知反思,而是指模型在生成答案时,使用更多的计算步骤来分解与解决问题。

换句话说,AI的推理更像是在模式空间里细致巡游,把问题拆解成一连串的中间状态,并用训练中学到的模式连接这些环节。由此可见,推理是对算力的投入与输出形式的调整,而非人类式的意识驱动的思索。 更进一步的研究揭示了模拟推理能力的边界。例如,苹果公司的研究人员在设计控制环境下测试模型执行“河内塔”问题,发现即便给出明确算法,模型依然无法正确执行,表现出明显的理解缺失和逻辑错误。同时,随着问题难度增加,模型的推理尝试反而减少,体现出所谓的“反常扩展极限”,它难以通过简单算力堆叠来实现质的飞跃。 然而,模式匹配与推理并非水火不容。

在哲学和认知科学领域,何谓真正“人类推理”尚未有统一定义。当前AI的模式匹配在某种程度上可能是人类推理在统计层面的反映,只是缺乏意识和元认知。未来的人工智能发展,是否能够跨越这一鸿沟仍是开放问题。但眼下,结合自我一致性采样、多样解路径探索、以及自我批判提示等技术,已经使得模型在一定范围内“自查”错误成为可能。此外,工具增强策略让AI模型连接计算器或符号数学引擎,大大弥补了其计算与验证弱点。 从应用视角来看,o3-pro无疑是当前最先进的模拟推理模型之一。

它对于编程调试、复杂数学运算、结构化数据分析等任务提供了卓越支持,提升了工作效率和准确性。与此同时,使用者必须保持谨慎的态度,避免过度信赖模型结果,特别是在涉及创新性、新颖问题时,仍需人工监督和二次核查。 展望未来,AI推理的突破或许需要从根本架构和理论层面寻找突破口。如何让AI不仅是高度发达的模式匹配器,而是真正具备因果理解、元认知反思能力的“智能体”,是人工智能科学家们面临的重要挑战。当前的模拟推理技术虽有明显进步,但仍处于通往人工通用智能之路的初级阶段。 总的来看,o3-pro模型的发布和性能提升,既体现了AI技术对实际问题解决力的增强,也暴露了模拟推理固有的局限性。

作为用户和开发者,理解AI“推理”更多指代的是算力驱动的步骤展开,而并非有人类式推理意识,将有助于更合理地利用此类工具,发挥其优势,同时规避潜在风险。未来随着技术不断迭代,结合多模态输入、多任务学习和自主纠错机制的AI模型,或将推动AI推理迈向更高境界,实现更加智能和可信的人工智能服务。