近年来,随着人工智能领域的快速发展,语言模型作为其中的核心组成部分,受到了广泛关注。传统的自回归语言模型在自然语言处理任务中表现卓越,但其在推理速度和灵活性上存在一定局限。扩散模型则因其并行生成和可控性的优势,成为研究热点。然而,扩散模型在语言建模中的表现尚未完全超越自回归模型,尤其是在困惑度(perplexity)和推理效率方面仍有所不足。正是在这一背景下,Esoteric语言模型(Eso-LMs)的出现为语言模型研究注入了新的活力。Esoteric语言模型是一种创新的融合架构,将自回归模型与掩码扩散模型(Masked Diffusion Models,MDMs)巧妙结合,实现了技术层面的突破和性能上的提升。

自回归语言模型通过逐步预测下一个词来生成文本,因其顺序生成特性,能够准确捕捉上下文信息,展现出较低的困惑度和较强的语言理解能力。但其生成过程缺乏并行性,推理速度受到限制。扩散模型作为一种基于概率的生成模型,通过多次迭代逐步恢复数据分布,支持并行生成和生成质量的可控调整,这使得它们在图像生成等领域崭露头角。掩码扩散模型作为扩散模型的一个子类,强调整体文本的掩码预测,强化对词语上下文的捕捉,取得了迄今为止扩散方法中最优秀的语言生成效果。但它们仍面临如下挑战:推理阶段缺乏关键的KV缓存机制,导致效率低下,且难以达到自回归模型的困惑度水平。 Esoteric语言模型通过将自回归和掩码扩散模型的优势相融合,提供了一种灵活的插值机制,能够在两者的性能指标上实现平滑过渡。

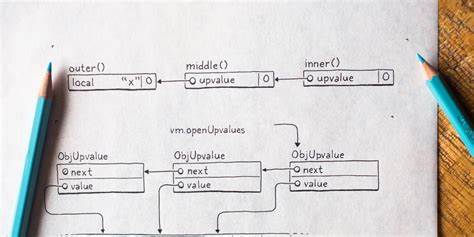

该模型不仅继承了自回归模型在语言生成准确性方面的优势,同时保持了扩散模型的并行化和生成可控性。更为重要的是,Eso-LMs首次将KV缓存机制引入掩码扩散模型,显著提升了推理效率。这种缓存机制允许模型在生成过程中复用先前的键值对信息,减少重复计算,推动推理速度大幅提升。据研究数据显示, Eso-LMs结合优化采样策略后,推理速度最高可达传统掩码扩散模型的65倍,并且比此前的半自回归方法快三到四倍,极大缓解了之前扩散模型在实际应用中的性能瓶颈。 此外,Eso-LMs在标准语言建模基准测试中刷新了性能纪录,展示了其卓越的文本生成和语言理解能力。通过灵活地平衡自回归和扩散机制,Eso-LMs实现更低的困惑度、更高的生成质量和更优的计算效率,为自然语言生成技术带来革命性的进步。

这不只是技术性能上的提升,还预示着未来应用场景的广泛扩展,包括智能对话系统、机器翻译、文本摘要、内容创作和自然语言理解等多个领域。 此外,Eso-LMs的开发团队还公开了代码和模型权重,使得业界和学术界能够共同探索和推动该技术的进一步应用与改进。通过开源,这些先进技术有望加速各类自然语言处理任务的创新,降低技术门槛,促进更广泛的技术普及和实际应用。 从技术原理角度看,Eso-LMs的成功在于打破传统模型之间的界限,创造出一种既不完全依赖自回归序列生成,也不受限于纯扩散过程的混合范式。这种模式通过精心设计的插值策略,实现了两种架构的优势互补。自回归模型提供强大的顺序预测能力,而掩码扩散模型则补足了并行处理的短板,捕获全局语义信息。

同时,KV缓存机制的引入,使得推理时计算资源的利用更加高效,显著缩短了生成时间。这些设计使得模型在实际生产环境中具备更高的可用性和适应性。 未来,Esoteric语言模型的研究方向和应用潜力依然广阔。随着算力的提升和算法的优化,融合型语言模型有望在更多复杂语言任务中取得突破,打破现有技术瓶颈。研究人员也可能进一步探索多模态扩散与自回归结合的可能性,实现语音、图像与文本的深度融合,为跨领域人工智能发展注入新动力。同时,其高效的推理能力将促进实时语言生成系统的普及,提升人机交互体验,推动智能助理、自动客服和内容生成平台更广泛的落地应用。

综上所述,Esoteric语言模型作为一种开创性的混合架构,成功融合了自回归与扩散模型的优势,打破了现有语言模型在性能和效率方面的限制,成为推动自然语言处理领域迈入新阶段的重要力量。它不仅刷新了标准评测的记录,更以其独特的KV缓存技术实现了推理速度的革命性提升,为未来智能语言应用提供了强大底层支持。随着更多研究和开发的持续推动,相信Esoteric语言模型将在人工智能语言技术发展史上留下浓墨重彩的一笔。