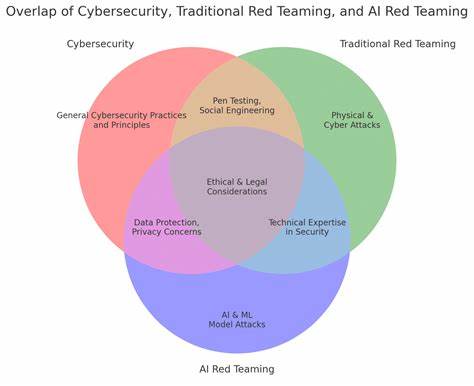

随着人工智能技术的迅猛发展,红队演练作为检测和强化AI系统安全的重要手段,逐渐受到各界的重视。红队演练原本旨在模拟攻击者视角,帮助组织发现系统中的漏洞与弱点,从而及时修补和强化安全防护。然而,近年来越来越多的专家指出,人工智能红队演练存在着一种令人担忧的“虚假安全感”,这不仅可能掩盖真实风险,还可能导致安全防护措施失效,给企业和用户带来严重后果。理解和解决这一问题,已成为保障AI系统安全的关键课题。人工智能红队演练中的虚假安全感主要源于对演练结果的误判和过分依赖。一些组织在完成红队演练后,自信满满地认为自身安全体系稳若磐石,然而事实上,这些演练往往无法覆盖所有潜在攻击路径,尤其在面对复杂多变的AI攻击技术时,红队方法和工具的局限性暴露无遗。

演练过程中使用的攻击模型可能过于单一,缺乏多样性,忽视了新兴攻击手段的演变,这使得演练结果偏向于“已知威胁”的检测,而未能有效识别隐藏的未知风险。此外,红队团队的能力水平和专业素养直接影响演练的深度和广度。若团队成员经验不足或缺乏对目标系统的深入理解,演练的针对性和有效性大打折扣,难以揭露关键漏洞。同时,内部团队与红队之间缺乏良好的沟通和协作,也可能导致安全隐患被忽视或误判。人工智能系统本质上具有高度复杂性和动态适应性,这要求红队演练同步具备灵活应变的能力。然而,目前市场上多数红队工具和策略仍停留在较为传统的攻击模拟层面,未能充分考虑AI模型的训练数据、模型更新机制以及对抗样本生成等特有风险。

红队演练未能涵盖这些方面,往往导致部分安全漏洞被遗漏,使得系统在实际攻击面前变得脆弱。“虚假安全感”不仅影响技术层面的判断,还可能导致战略层面的错误决策。高层管理者在红队报告的积极结果基础上,降低对安全投入的优先级,缩减预算和人员配置。这样一来,本应加强的防护机制反而弱化,增加了遭受重大安全事件的风险。面对这一挑战,组织必须重塑对AI红队演练的认知和实践。首先,红队演练应不断更新攻击模型,引入最新的攻击案例和技术,保持演练的前瞻性和实用性。

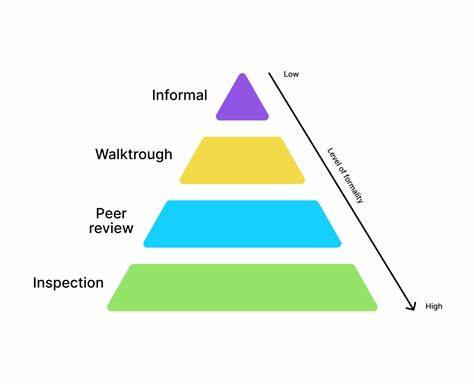

采用多种攻击路径和多样化手段,可提升演练的覆盖范围和发现隐患的能力。其次,提升红队团队的专业水平至关重要。通过持续的技术培训和跨学科合作,增强团队对AI系统架构、算法特点及其潜在风险的理解,实现更深入的漏洞挖掘。同时,加强内部安全团队与红队的协同,确保信息流通畅,攻防经验共享,将更有效地提升整体防御水平。技术手段方面,结合自动化工具和人工智能辅助的红队演练方案,也是未来发展的重要方向。利用机器学习模型识别和模拟潜在攻击模式,提高红队演练的效率和准确性。

此外,加入对抗性训练机制,通过持续对AI模型进行攻击与防御的循环测试,帮助系统不断调整和优化安全策略。在政策和管理层面,制定科学合理的安全评估标准及合规要求,推动企业建立系统化的红队演练制度和持续改进机制。安全治理框架应贯穿红队演练的全生命周期,从计划、执行到评估和反馈,确保演练成果切实转化为安全能力提升。人工智能红队演练虽然是保障系统安全的重要策略,但若依赖不当,极易产生虚假的安全感,掩盖潜在风险,造成误判和决策失误。只有充分意识到红队演练的局限,结合最新技术和管理经验,采用多层次、多维度的安全防护措施,才能真正筑牢AI系统的安全防线。在未来,随着AI技术不断演进,红队演练也需不断进化,才能有效应对复杂多变的安全威胁,保障数字经济和社会的稳健发展。

。