在当今互联网时代,网站的搜索引擎优化(SEO)变得尤为重要。一个设计良好且符合SEO要求的网址,不仅可以提升网站在搜索引擎中的排名,还能带来更好的用户体验和点击率。而如何自动生成SEO友好型的网址,成为众多开发者关注的焦点。本文将详细阐述如何借助Python的Scrapy框架和其管道功能,实现自动生成独特、美观且符合SEO标准的网址,从而帮助网站内容更好地被搜索引擎收录。Scrapy作为一个强大的网络爬虫框架,允许开发者高效采集网络数据。在实际应用中,常常需要将爬取的内容搬运至新网站或者进行二次处理,生成一套符合SEO规范的网址尤其重要。

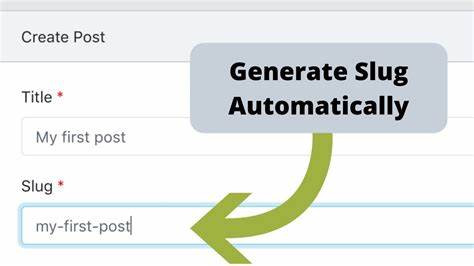

网址的生成不仅要保证可读性和简洁,还要确保唯一性,避免因重复标题产生冲突。解决上述问题的关键在于将标题转化为纯ASCII字符,去除特殊符号,同时结合一定的唯一标识符。该唯一标识符一方面保证同名标题的网址不会重复,另一方面尽可能保持短小,方便记忆和传播。实践证明,结合标题以及原始URL的部分加密内容,是实现这一目标的有效方法。核心思路是先对每条内容的标题进行处理。标题首先要去除前后空白符,再利用Unicode规范化方法去除非ASCII字符,将诸如带重音符号的字母转为简单的英文字符。

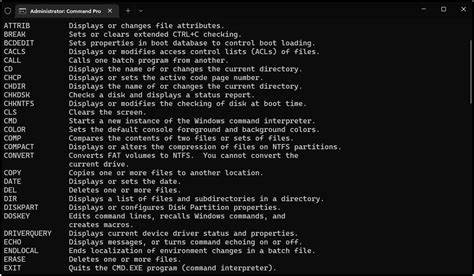

随后,再用正则表达式将标题中的常见特殊符号替换为空格,最后转换为小写并分割成单词序列。经过这一系列处理,标题被转换成一个纯英文、易读且无标点干扰的词组列表。接下来,为了保证网址的唯一性,需要引入一个简短的标识符。通过对原始URL计算SHA-256哈希值,截取哈希的部分字节,再将其转换为36进制的字符串,既保证了标识符的独一无二,又避免了标识符过长造成的网址臃肿。把处理后的标题词组通过连字符“-”连接起来,并附加上上述唯一标识符,最终构成了完整且SEO友好型的网址路径部分。通过这种方法,既突出页面主体信息,提高关键字密度,也有效避免了因重复标题而引发的网址冲突。

例如,对于维基百科中“Déjà vu - Wikipedia”的页面,处理后的结果会是“deja-vu-wikipedia-1q9i86k”,整齐、简洁且兼具唯一性。实际应用中,将这一流程放入Scrapy的管道类实现,对每条爬取的数据进行自动处理,无需人工干预。这样一来,爬虫不仅采集信息,还能直接输出已处理好的可用页面URL,大大节省后续内容管理时间。值得注意的是,在处理过程中应优先考虑内容的正确性和完整性。如果标题缺失,应当抛出异常或剔除该条记录,避免产生无效或乱码网址。同时,编码和解码环节对性能及稳定性要求较高,尤其在大规模数据抓取时更应注意内存和计算效率。

除了网址本身的写法,也可结合其他SEO策略,如合理设置标题标签、meta描述和站点地图等,从而最大程度提升网站的搜索引擎友好度。此外,选用带有高频关键字的字段生成URL,有助于搜索引擎更准确地理解网页内容,提高索引深度。现有的Scrapy生态中已经有不少辅助工具和库,可以帮助编码和字符转换。例如,Python的unicodedata模块提供了字符标准化功能,而第三方的base36库实现了高效的进制转换。综合运用这些工具,将自动化程度和代码简洁性提升至更高水平。这一自动生成URL的方法不仅适用于新闻类、百科类网站,也适合电商平台、博客和内容聚合站点。

尤其在面对大量网页时,自动化生成SEO友好网址减少了人工干预,保证网址规则统一,并且在搜索引擎排名中获得长远优势。此外,短小唯一的标识符便于用户分享和传播,提升用户体验,易于记忆和输入。随着人工智能和自动化技术的发展,类似的自动化SEO策略将成为网站维护的重要组成部分。只有不断优化URL结构与站点内容,才能在激烈的网络环境中脱颖而出。总结起来,通过Scrapy管道自动生成SEO友好型网址,核心在于良好的标题文本预处理和结合基于哈希的唯一标识。此方法避免了重复网址造成的尴尬,提升页面对搜索引擎的友好度。

该技术为开发者和网站运营人员提供了高效、可靠的解决方案,值得深入学习和广泛应用。未来,结合更多语义分析和关键词提取技术,URL自动生成的智能化水平将持续提升,为网站优化注入更强动力。