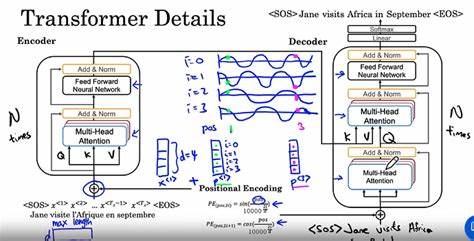

Transformer模型自问世以来,凭借其强大的并行计算能力和优异的性能,迅速占领了自然语言处理、计算机视觉等众多领域的核心地位。作为Transformer架构的基础组成部分,位置编码在模型处理序列数据时起着无可替代的作用。传统的循环神经网络通过顺序传递隐状态捕获位置信息,而Transformer由于其自注意力机制的设计,无法直接感知序列中元素的相对或绝对位置,因此必须借助位置编码来引入序列顺序信息。位置编码不仅为Transformer模型赋予了处理序列数据的能力,还直接关系到模型的表达效果、泛化能力和对长序列的推断能力。针对此关键环节,近期的最新研究提出了系统的理论框架,深入分析了不同位置编码方法的内在机理与性能表现,从而为Transformer模型的优化设计提供了坚实的理论依据和实践指导。 位置编码的核心目的是为输入序列中的每个元素赋予独一无二的位置信息,使得自注意力机制能够考虑到元素在序列中的顺序关系。

最初广泛采用的是由Vaswani等人在2017年提出的正弦和余弦函数组成的固定变换编码,这种基于周期函数的设计具有连续且平滑的性质,便于模型对序列位置进行插值和外推。随后,研究者们设计了可训练的位置编码,将编码参数作为模型一部分,通过数据驱动的方式学习最佳位置表示,进一步提升模型对特定任务的适配性。近年来,还出现了相对位置编码、ALiBi等创新性的偏置方法,这些技术通过引入相对位置关系或线性偏置,改善了模型对长距离依赖和序列外推能力的掌控。 针对上述多样的编码方法,理论分析框架从表达能力的角度对Transformer模型进行了严谨定义。表达能力衡量模型能近似的函数空间的广度和复杂度。借助数学工具,分析者利用函数逼近理论证明,不同编码方式在某些函数类别的逼近效果存在显著差异。

例如,正弦位置编码凭借其频率成分适合处理周期性序列,而基于正交多项式如勒让德多项式的编码则展现出更强的适用性和泛化潜力。这些正交函数具有正交性和局部性,有助于模型更好地捕捉序列中的复杂关系,降低过拟合风险,增强对未知序列长度的外推力。 泛化能力是衡量模型在训练数据之外,面对未知数据时表现稳定性的关键指标。该理论工作采用统计学习理论中的拉德马赫复杂度(Rademacher Complexity)对位置编码方式对Transformer的泛化界限进行了分析。结果表明,编码方案的选择直接影响模型复杂度及其泛化误差。固定频率的正弦编码因其确定性和参数少,在某些情况下减少了模型的自由度,从而有利于泛化。

而可训练的编码虽然灵活性更强,但若缺乏适当正则化可能导致过拟合。此外,引入依赖于输入序列长度的偏置策略如ALiBi,在保证模型相对位置感知的同时,也使模型更能适应长序列任务,提升了外推性能。 长序列任务一直是序列建模中的难点,传统Transformer因其计算和内存开销呈二次增长,且位置编码的周期性限制了对超长序列的处理效果。该研究通过系统性的理论推导,揭示了不同位置编码机制如何影响Transformer的外推能力。特别是将ALiBi偏置方式纳入统一的数学框架,明确了其对序列长度变化的鲁棒性原因。此外,提出的基于正交函数的新型编码通过扩展频谱范围和函数基空间,有效提升了模型在超长序列上的表现,避免了传统正弦编码频率不足导致的信息丢失问题。

在实际应用层面,研究团队选取了合成序列到序列任务对位置编码方法进行了综合评估。实验结果印证了理论分析的结论,基于正交变换的编码相较于传统正弦编码表现出更优异的泛化能力和外推性能,尤其在序列长度超过训练范围时优势明显。这不仅为位置编码的设计指明方向,也为Transformer模型在自然语言处理中如机器翻译、文本生成,以及计算机视觉中的图像序列分析,提供了强有力的技术支持。 随着Transformer及其变体成为AI领域的研究热点,位置编码的理论深度和实践广度的拓展显得尤为重要。这项最新的理论分析工作填补了学术界对位置编码影响机制了解的空白,推动编码设计从经验驱动向理论指导转变。未来,基于正交函数的编码理念可能成为主流的发展方向,同时,有望结合神经算子理论、多尺度分析等先进数学工具,实现更高效、更具适应性的序列表示方法。

综上所述,位置编码在Transformer模型中的作用远超简单的位置信息注入,它对表达能力、泛化性能及长序列外推能力具有根本性的影响。深入理解和创新位置编码技术,是提升Transformer模型性能、扩展其应用边界的关键。随着理论分析工具的不断完善和实验验证的丰富,未来的Transformer模型将在多个领域展现更加卓越的智能与灵活性。