随着人工智能技术的飞速发展,越来越多的企业和开发者开始思考如何将现有业务系统与智能模型高效连接,释放数据和服务的价值。gRPC作为一种高性能、跨语言的远程过程调用框架,广泛应用于微服务架构中,而AI模型尤其是大型语言模型(LLM)则渴望直接访问实时数据和功能接口。如何让AI模型方便地调用已有的gRPC服务成为了一个亟需解决的难题。ggRMCP应运而生,它是一款基于Go语言开发的高性能网关,能够将gRPC服务无缝转换为与MCP(Model Context Protocol)兼容的工具,从而让AI模型如Claude等能够直接调用现有的gRPC接口,极大地提升了AI与传统后端系统的协同效率。ggRMCP的核心优势之一在于对gRPC反射机制的支持。通过gRPC server reflection,ggRMCP能动态发现服务及其方法,无需修改任何现有服务代码。

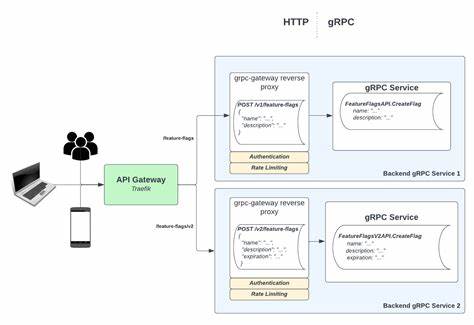

这种动态发现机制使得开发者不必重写或适配任何业务逻辑,极大降低了接入门槛和维护成本。更进一步,ggRMCP支持使用FileDescriptorSet文件,这种预编译的protobuf描述文件不仅能实现服务发现,还能提取注释和文档信息,丰富AI模型的交互体验,让调用者更清楚每个接口的用途和参数含义。ggRMCP的架构设计体现了现代网关的灵活性和高可用性。它采用连接管理器管理与gRPC服务的连接健康状态,并通过服务发现组件动态维护服务目录。作为一个语言无关的侧车代理,ggRMCP可以部署在任何支持gRPC反射的服务旁边,无论该服务是用Java、Python、C++还是Go开发,实现了跨语言的完美兼容。其内置的MCP处理模块负责在HTTP层面实现MCP协议,自动将JSON格式的请求转换为protobuf格式,并负责响应的反向转换和错误处理,确保AI请求与gRPC后端的通信顺畅无阻。

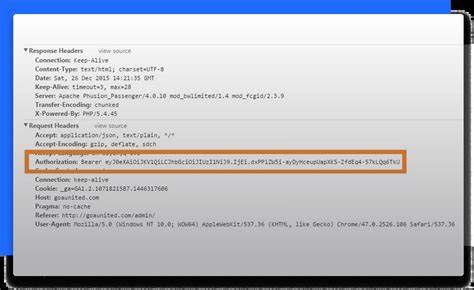

部署灵活性是ggRMCP的又一大亮点。开发者可以选择将其作为侧车代理随服务容器一起部署,避免业务服务改动,独立进行版本升级和扩展,保障服务的稳定性与隔离性。也可以采用集中式网关架构,由单一的ggRMCP实例统一管理多个gRPC后端,便于统一监控、身份验证和流量控制。无论哪种模式,ggRMCP都能保证实时转码,保持调用效率。从安全角度看,ggRMCP内置了精细的HTTP头部转发机制,默认屏蔽潜在敏感或影响服务正常工作的头部字段,仅允许经过验证的授权信息传递至后端服务。同时它采用了基于UUID的会话管理和限流策略,防止滥用和攻击,保障网关和后端服务的稳定运行。

ggRMCP对请求和响应均进行严格的protobuf模式校验,确保传输数据的完整性和合法性,有效避免异常数据引发的运行时错误。作为一款面向AI应用的工具,ggRMCP的最大魅力在于它提供的动态MCP工具生成功能。每个被发现的gRPC方法被自动转化为具备输入输出模式定义和文档说明的MCP工具,AI模型通过这些工具便能像调用本地函数一样访问远程服务,实现智能问答、实时决策和复杂数据处理等功能。同时ggRMCP为AI的会话上下文管理提供支持,能够保持状态连续性,处理复杂的多轮交互请求,提升用户体验。在实际应用中,ggRMCP极大简化了AI模型接入gRPC服务的流程。开发者无需侵入性修改业务代码,只需启动启用反射的gRPC服务器和ggRMCP网关,AI即可直接调用方法。

结合FileDescriptorSet还可获得更丰富的接口信息,帮助AI更准确理解调用语义。通过与Claude Desktop等支持MCP协议的客户端结合,开发者能在熟悉的环境下快速完成服务测试和集成,缩短从概念验证到生产应用的周期。作为一个开源项目,ggRMCP正在积极发展中,社区欢迎贡献代码和提出改进建议。它的出现为融合传统微服务架构与新兴AI应用搭建了桥梁,推动智能化服务的普及和创新落地。随着gRPC和MCP协议的成熟,ggRMCP在未来必将成为AI与企业服务系统协作的关键纽带。总的来看,ggRMCP通过创新的技术方案和灵活的部署方式,突破了AI模型调用传统微服务的壁垒。

它不仅节约了开发和维护成本,还提升了系统的实时响应能力和安全性,为企业在智能化转型过程中提供了强有力的基础设施支持。选择ggRMCP,意味着选择用现代化的协议和架构,让AI赋能现有的服务体系,实现数据价值的最大化和服务的智能升级。