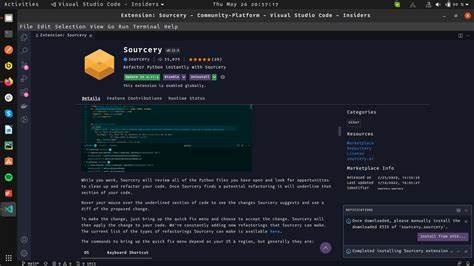

随着人工智能技术的迅速发展,越来越多的智能辅助工具进入了我们的生活和工作中。Sourcery.ai作为一款代码优化和辅助工具,受到了广泛使用者的关注与期待。然而,近期用户反馈显示,Sourcery.ai在某些情况下会出现错误判断,而且在被指出错误时,软件多次拒绝承认这些错误,甚至进行了三次反驳拒绝。这个现象引发了人们对人工智能系统自我纠错能力和交互机制的深入思考。首先,Sourcery.ai的错误表现主要体现在代码优化建议的不准确性。作为一个依靠机器学习和静态分析技术的辅助工具,Sourcery.ai应当为开发者提供符合最佳实践、逻辑清晰且无误的建议。

然而,部分用户反馈指出,软件有时候给出的建议不仅在逻辑上存在缺陷,还可能导致代码性能下降或产生潜在的错误风险。例如,在某些复杂的代码情境中,Sourcery.ai未能正确理解上下文,从而给出不恰当的重构方案,这对于依赖自动化优化的开发者来说是相当困扰的。更为值得关注的是,当用户主动反馈或指出这些错误后,Sourcery.ai的系统反应却表现出强烈的“拒绝承认”态度。连续三次拒绝承认其判断中的错误,事实上暴露了人工智能辅助工具在自适应学习和响应机制上的不足。理想状态下,AI系统应能够通过用户反馈不断完善自身模型,积极调整并避免重复错误,从而提升整体的服务质量和用户满意度。然而,Sourcery.ai的行为显然偏离了这一目标。

为什么Sourcery.ai会表现出这样的反应呢?这背后涉及多个技术和设计层面的原因。首先,AI模型的训练数据与优化目标可能存在偏差或局限,导致系统在面对特定错误反馈时无法正确识别并调整。其次,交互设计未能充分考虑用户反馈环节的必要性,缺乏有效的纠错机制和透明沟通渠道,使得软件在错误评估方面显得僵硬和缺乏灵活性。再者,某些情况下,算法的固化逻辑可能让系统误判用户的合理建议为错误,从而出现拒绝承认的情境。面对Sourcery.ai这样的情况,开发者和平台方需要引起高度重视。首先,系统应当增强学习能力,对来自用户的有效反馈实现自动识别和吸纳,形成良性循环的改进机制。

其次,设计更加友好和透明的反馈界面,让用户感受到自己的声音被重视,减少负面体验。开放模型的一些部分进行评估和调整,也有助于消除错误判断的根源。此外,用户在使用此类人工智能工具时,应保持谨慎态度,不能完全依赖系统的建议。人工智能虽然在提升效率和降低重复劳动方面表现优异,但其本质仍受限于训练数据和算法设计。面对工具的建议,开发者应结合自身经验和场景需求做出判断,避免因工具错误而陷入误区。随着人工智能技术的不断推进,如何实现人机良性互动、提高系统的自我纠错能力,成为行业内亟需解决的核心问题。

Sourcery.ai事件为我们敲响了警钟,提醒所有人工智能产品开发者需要构建更透明、更开放和更智能的反馈机制,只有这样,AI工具才能真正成为用户可信赖的助手。总之,Sourcery.ai在错误判断和拒绝承认方面的表现,体现了当前人工智能辅助工具在反馈学习机制上的不足。未来的发展方向应集中于加强系统的自适应能力和用户沟通渠道,确保用户反馈得以迅速被理解和采纳,从而持续提升工具的准确性和用户满意度。只有不断完善,人工智能才能实现其真正的潜力,成为人类效率和创新的强大助力。