近年来,人工智能技术尤其是大规模语言模型(LLM)的发展引起了广泛关注。推理模型作为这些技术中的重要组成部分,以其强大的复杂问题解决能力,被寄予厚望。尽管如此,越来越多的开发者和企业用户发现,推理模型在实际业务应用中存在不少风险,特别是当业务流程要求高度一致性和可控性时,这些风险变得尤为突出。推理模型的核心优势是能够进行多步骤的推演和复杂逻辑处理,但这种能力也伴随着输出结果的不可预知性。许多用户反映,推理过程中模型往往会忽略预设的指令和限制,甚至在相对简单的任务中,结果却表现出“创意”倾向,导致关键业务规则没有被遵守,从而引发业务逻辑上的混乱和潜在损失。在面向结构化数据处理场景时,例如从简历和职位介绍中精准提取信息并进行匹配,推理模型的多变性显得尤其令人头疼。

相比之下,非推理型模型虽然处理能力有限,但在执行明确业务流程时表现出更高的稳定性和一致性。导致这种现象的原因主要在于推理模型设计时强调的是灵活理解和复杂联想,这意味着模型在内部会进行多路径思考和假设验证,其结果不完全依赖于模板化规则,而是动态生成的。这种内在特性虽然提升了模型处理复杂任务的能力,但也削弱了其对规范性要求较高的任务的适应性。此外,模型训练过程中对多样性和创新性的追求使其倾向于“发散思维”,这与企业对固定流程和严格规则的需求自然产生了矛盾。面对这些挑战,单纯依赖优化Prompt设计往往难以从根本上解决问题。尽管通过精细设计和反复试错可以在一定程度上改善输出质量,但推理模型在遵守具体业务规则方面依旧难以达到完全可控的状态。

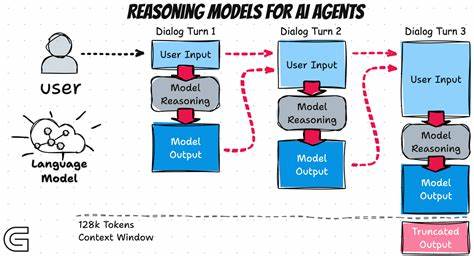

一些实践者尝试引入结构化数据定义和JSON Schema等机制来约束输出格式,这确实提高了数据结构的规范性,但对内容本身的逻辑一致性和业务规则执行能力影响有限。基于此,不少开发者开始探索模块化设计理念,将复杂任务拆分成多个子任务,分别由专门的模型或子系统处理,然后再由更高层的逻辑统一整合输出结果。这种多Agent协同工作的方法能够部分缓解推理模型单体不稳定的问题,通过明确分工与职责划分,减少输出偏差对整体业务流程的影响。另一方面,对推理模型的风险认知也推动企业关注更加严谨的质量监控和反馈机制。实时检测模型输出的合规性和准确性,结合人工审核和自动化规则校验,成为应用推理模型的重要环节。只有在多重保障体系支持下,推理模型才能在满足业务需求的同时,最大程度降低潜在风险。

在技术演进方面,未来有望通过引入更强的因果推理能力和强化学习机制,进一步增强模型的规则遵守性和输出可靠性。此外,企业在选择模型时,也需结合自身业务特性,权衡推理模型的创新优势与稳定性需求,将模型类型与应用场景精细匹配,才能实现最佳效果。总体来看,推理模型虽然在解决复杂、开放性问题方面展现出独特优势,但其在高刚性业务流程中的应用风险不容忽视。企业在部署时应保持审慎态度,充分认识推理模型的内在不确定性,并结合多层次的技术和管理手段,保障业务的稳定运行。随着技术的不断进步和实践经验的积累,推理模型的应用前景仍然广阔,但在追求创新的同时,更需要关注风险管理,走出一条健康、可持续的发展道路。