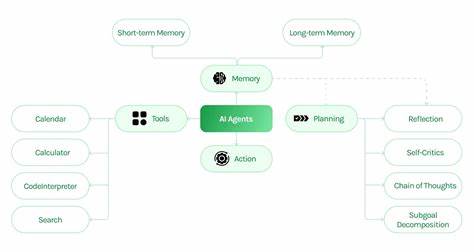

近年来,大型语言模型(LLM)在自然语言处理领域引起了广泛关注,诸如OpenAI的GPT系列、Google的Gemini系列等都表现出强大的语言生成能力。然而,随着技术的成熟,如何进一步提升模型输出的准确性、相关性和完整性,成为业界新的挑战。作为回应,Kritikos项目应运而生,旨在为大型语言模型打造一个即开即用的Go语言后端环境,支持LLM-as-a-critique方法,通过批判式迭代机制提升回答质量。 Kritikos是一套基于Go语言构建的后端系统,聚焦于对大型语言模型生成内容的自动评估和优化。它创新性地采用了“LLM作为批判者”(LLM-as-a-critique)的理念,即先由基础模型生成回答,再由评价模型进行质量打分和批判,反复迭代以获取更优质的结果。系统允许用户自由选定基础生成模型及批判评估模型,通过温度参数调控模型回答的随机性,评价模型温度逐步降低以强化回答的一致性和准确性。

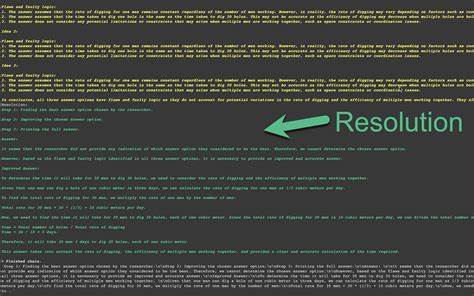

Kritikos的架构设计简洁明了,主服务入口位于cmd/api目录下,路由、处理器和控制逻辑分离存储于internal/api,确保代码结构清晰利于维护。利用Makefile提升开发者使用的便利性,仅需Go语言环境,即可快速构建运行服务器,默认监听3000端口,极大降低了接入门槛。 项目中附带环境变量模板文件,便于用户快速配置关键参数如API密钥和模型配置。同时,官方README文档内包含详尽的启动指导和API调用示例,使得非专业人员亦能迅速上手。 Kritikos的核心优势在于其将LLM批判机制程序化,实现自动化的质量提升循环。针对一则用户提问,基础模型首先输出初步回答,随后评价模型依据语言质量指标如相关性、正确性、完整性、清晰度和风格进行评分,并指出答案中的优缺点及可落地改进建议。

系统根据批判反馈调整模型参数,反复重试以得到更符合需求的最终文本。 通过这种方式,用户不仅获得了更加严谨、准确又富有条理的回复,还能明显感受到模型回答质的飞跃。尤其在面向复杂任务的应用场景中,这种多模型协同驱动的批判优化模式为提升用户体验和降低误导性信息提供了技术保障。 Kritikos的一个典型应用场景集成了Google Gemini模型。用户可通过API向后端发送包含提示词、基础模型(如Gemini 2.0 Flash)、评价模型(如Gemini 2.5 Flash)与温度参数的JSON请求。系统将自动执行多轮生成与评估,并返回包含详细评分、优劣势分析及改进答案的完整结果。

此外,Kritikos支持设定最大重试次数(maxRetries),避免无限循环,保持响应效率。这一设计体现了工程上的务实考虑,兼顾系统复杂性与性能表现。 Kritikos项目释放于MIT开源协议下,开发者可以自由修改和分发代码,拓展其功能。作为一个基础设施层组件,它不仅适配Google VertexAI和Gemini系列,也具备扩展到OpenAI模型的潜力,具备强大的跨平台与多模型兼容性。 Kritikos的批判式优化思路促进了自然语言生成技术的创新。相比传统单轮生成的模糊性和偶发性输出,采用多模型交互制衡的设计实现了回答内容的层层打磨,使生成结果更贴合用户意图、更具逻辑性和说服力。

未来,随着大模型能力不断提升和多模态发展趋势,结合知识检索增强(RAG)和外部资源接入的批判机制,将能够提供更具权威性和环境适应性的智能问答服务。 Kritikos也计划在后续版本引入更多模型选择选项,提升对Google Search的支持,实现更强的知识追溯和事实验证功能。 当前Google Search因无法兼容程序化JSON输出而被禁用,但随着技术进步,灵活支持多样检索方案仍是发展重点。 综上所述,Kritikos项目为LLM生态注入了全新的方法论和技术架构,基于Go语言,面向企业和开源社区提供稳定、高效的批判式后端支撑。它不仅帮助优化模型回答质量,降低误差和虚假风险,也为未来智能问答系统打造了可扩展的基础设施。 在人工智能持续渗透各行各业的大环境下,工具如Kritikos将助力开发者更好地驾驭复杂模型,释放AI潜力,实现更加智能、贴心且高质量的交互体验。

无论是教育、客户服务还是内容创作,基于LLM-as-a-critique的批判优化都展现出巨大的应用前景和价值。 关注并参与Kritikos社区,为AI技术的持续进步献计献策,将推动整个行业迈向更加成熟与可靠的智能未来。