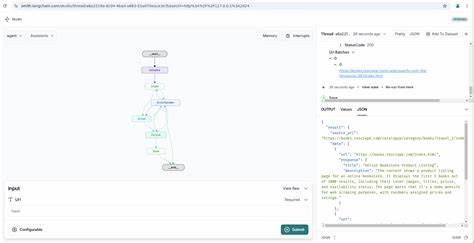

随着电商市场的激烈竞争,实时掌握竞争对手的价格动态成为企业赢得市场的重要策略之一。价格监控通常依赖于网络爬虫技术,自动从目标网站获取最新产品价格和库存信息。然而,随着反机器人检测机制的不断进化,传统的网页数据抓取技术面临前所未有的挑战。特别是在使用云端持续集成服务如GitHub Actions时,爬虫更容易被识别和封禁。本文将深度解析如何突破GitHub Actions环境中的反机器人检测,帮助开发者实现对沃尔玛等大型电商平台的价格有效抓取。 GitHub Actions作为现代自动化开发的重要工具,越来越多的开发者选择在其上运行爬虫脚本,以实现自动化的数据采集和分析。

它提供了强大的Linux云端环境和便利的集成,允许开发者将代码部署为流水线,定时执行和管理任务。然而,由于GitHub Actions的虚拟环境资源共享和IP地址的特殊性,目标网站往往能够识别出这些请求的异常特征,从而激活弹验证码、限制访问甚至封锁IP。这给依赖GitHub Actions进行网页抓取的项目带来了极大困扰。 数字反机器人技术主要通过多种手段判别请求的来源是否为真实用户,包括分析请求头信息、检测浏览器指纹、观察访问行为模式甚至利用机器学习方法识别异常流量。沃尔玛这类大型电商平台针对爬虫流量的识别尤其严苛,它们会根据短时间内的请求频率、请求路径和参数的规整度、访问环境(如无头浏览器的痕迹)等多维度信息综合判断。此外,验证码和JavaScript动态渲染页面也是阻止简单请求抓取的常见手段。

在GitHub Actions环境中,绕过这些检测的关键是模拟真实用户操作,丰富请求的多样性,合理控制访问节奏,并采用先进的反检测技术。例如,通过引入真实浏览器模拟技术(如Puppeteer或Playwright),可以完整执行JavaScript,避免因静态请求被视为异常流量。与此同时,为了规避虚拟机特征暴露,可考虑动态代理服务,使用高质量的住宅代理IP池,分散请求来源,从而降低被识别的概率。 另外,HTTP请求的头信息至关重要,完善且符合真实用户浏览器的特征能够有效迷惑反爬虫系统。Headers中应包含标准的User-Agent、Accept-Language、Accept-Encoding和Cookie等信息,且需要基于不同时间和访问情景动态调整。加之对浏览行为的微模拟,如随机等待时间、页面滚动、鼠标移动等细节,都能进一步提升来源的可信度。

GitHub Actions的流水线配置也需针对爬虫进行优化。合理安排任务间隔,避免批量高频访问,分散不同任务的运行时间,减少访问峰值,帮助降低检测风险。此外,灵活利用缓存机制存储已采集的数据,避免重复请求,进而减轻目标网站压力。 自动化的监控和异常处理机制同样不可忽视。当反检测系统生效时,及时识别验证码页面和异常响应,结合图像识别和自动输入技术实现自动验证码突破,保持爬虫高效稳定运行。若某个代理IP被封,可动态替换并重新发起请求,确保数据采集的连续性。

技术方案的选择和组合最终取决于具体业务需求和技术资源。例如,对于短时间内需求量大的批量价格抓取,优先考虑高质量代理与真实浏览环境结合的方案;而对于实时性要求极高的监控,则需更加注重系统的灵活性和自动化响应能力。 在实践过程中,不断调整和优化策略也是突破反机器人检测的重要环节。通过引入日志分析,对失败请求的原因进行深入剖析,结合反馈调整请求策略。数据采集之外,还需尊重目标网站的使用条款和法律法规,防止不正当访问造成的风险和纠纷。 总体来看,利用GitHub Actions自动化部署及执行网页爬虫任务,本身是一把双刃剑。

它极大提升了爬取效率和协作便利性,但也带来了被反机器人检测锁定的风险。通过技术手段模拟真实访问环境、合理调控访问频率以及灵活应用代理和自动验证码识别,爬虫团队能有效规避检测,持续获取目标网站如沃尔玛的最新价格信息,从而支持市场竞争策略的制定。 随着爬虫技术和反检测机制的博弈日益激烈,持续关注技术动态和创新应用将是保持数据采集优势的关键。对于开发者而言,深入理解环境特点,科学设计抓取方案,结合自动化工具和智能分析手段,将能在GitHub Actions的云端环境中实现高效稳健的数据采集,助力电商数据驱动的智能决策。 。