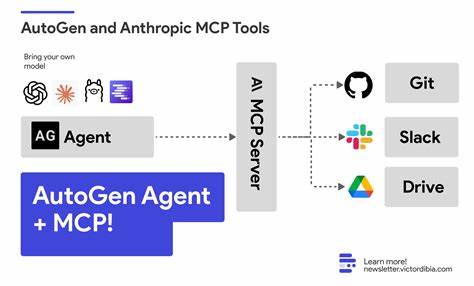

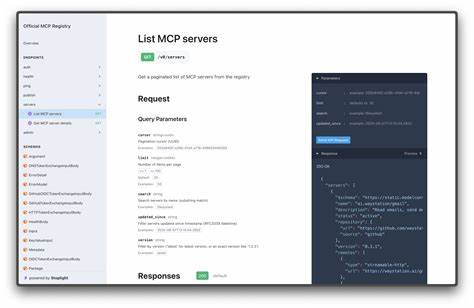

近年来,人工智能技术的飞速演进推动了各种智能应用和智能代理的发展,MCP(Model Context Protocol)作为标准协议应运而生,为跨团队、跨应用的工具调用架构提供了统一方案。MCP协议以其灵活的工具调用和集中管理能力,帮助企业实现了微服务式工具复用,增强了AI应用的扩展性和协作性。然而,尽管MCP在概念和功能上具有很大优势,在实际生产环境中,其动态工具定义和不可控的内容更新也带来了一系列安全与质量问题,制约了MCP协议的广泛落地。理解并解决这些隐患,对于企业构建安全、可靠的AI系统至关重要。MCP工具定义通常包括工具名称、功能描述和参数结构,这些信息直接融入代理的上下文提示中,为模型决策提供依据。然而,这些定义往往是动态加载的,由上游MCP服务器维护和更新。

若这些定义在不经审核的情况下发生变动,存在"提示注入"(prompt injection)的风险。攻击者或恶意维护者可以通过修改工具描述嵌入恶意指令,以影响模型生成的内容,造成数据泄露或不当操作。即使MCP服务器本身未遭破坏,正常的版本升级也可能引入权限扩展的工具,例如一个原本只读的查询工具突然被添加了删除功能,从而使用户拥有了超出预期的操作权限,引发安全隐患。此外,动态加载还意味着工具的名称和参数架构可能发生变化,导致AI代理生成调用请求时出现不一致,影响准确率,甚至造成关键功能失效。除此之外,动态加载也影响系统的性能。MCP服务器为了适配广泛需求,往往加载庞大的工具定义,可能达到五万令牌级别。

对大多数具体应用而言,只有少数工具真正被调用,这导致不必要的上下文占用,令牌开销激增,同时带来响应时延增加,浪费资源与成本。为解决上述问题,Vercel公司推出了mcp-to-ai-sdk工具。这是一款基于命令行界面的静态工具生成器,能够连接任意MCP服务器,下载当前工具定义并将其转换为本地化、静态的AI SDK兼容工具代码。这些工具代码直接纳入开发者项目,成为代码库的一部分,由版本控制管理,避免了动态定义带来的不确定性。mcp-to-ai-sdk极大地提高了系统整体的安全性和稳定性。系统开发者可以严格控制导入的工具列表,避免意外的新功能引入带来风险,而且所有工具的描述和参数模式在代码层面固定,杜绝提示注入风险。

除此之外,开发者还能够根据自身模型需求,定制或优化工具描述,使其更贴合应用场景,提升模型调用准确率。mcp-to-ai-sdk生成的工具代码仍然在运行时调用MCP服务器,保持了灵活的功能扩展性和后端服务的活跃更新,但架构边界清晰,风险降至最低。此外,静态化工具定义显著降低了代理上下文占用。开发者可以选择只卖命那些真正用到的工具,精简了令牌使用,减少了调用延迟,降低了运营成本。该工具支持包括身份验证、自定义请求头和不同传输协议的多样MCP服务器,具备极佳的适用性和可扩展性。针对AI应用生产化过程中安全和可靠性的重要性,mcp-to-ai-sdk开创了"供应商化"(vendoring)工具定义的全新模式,打破了传统灵活与稳定间的二元困境。

既适合开发阶段探索使用MCP的丰富资源,也保证上线环境中工具定义的稳定可控。此外,开发者社区和企业级使用者均反馈,通过此方案,AI代理的维护成本得以大大降低,代码审查和变更管理成为保障安全的有效手段。除了技术层面的改进,mcp-to-ai-sdk也强化了开发体验。命令行简单易用,集成友好,可以无缝导入现有AI SDK项目,极大提升了工具生产和迭代的效率,支持一键更新和定制化配置。展望未来,随着AI技术的成熟与推广,MCP将持续在工具调用领域发挥关键作用。结合静态化工具定义策略,行业将逐步实现高安全、高性能的AI代理解决方案。

同时,随着协议版本化和规范完善,工具描述和权限管理的机制将更透明化,进一步提高用户信任与系统稳定性。综上所述,虽然MCP工具为AI代理提供了前所未有的灵活性和统一的调用框架,动态定义所带来的安全和质量隐患仍不可忽视。mcp-to-ai-sdk通过将工具定义静态化、本地化,为AI开发者和企业搭建了一条稳健可靠的生产路径。未来通过持续的社区协作与技术演进,MCP与静态工具管理的结合将助力打造更加安全、高效的智能应用生态,推动AI产业健康发展。 。